Cloudwatt apporte une composante analytique à l'offre Hadoop as a Service qu’il a officiellement ouverte en juillet dernier sur son cloud public. Utilisée depuis plus d’un an par différents clients pilotes – notamment dans le cadre du partenariat avec Micropole et de son offre Big 24 – l’offre permet de configurer et démarrer en une dizaine de minutes un cluster Hadoop en ligne. On peut choisir entre les distributions Apache, Hortonworks, Cloudera, MapR du framework, ou encore opter pour Storm ou Spark. A partir d’un workflow unique, les clients de l’infrastructure cloud peuvent ainsi créer des clusters leur ajouter ou leur enlever des nœuds à la volée - scale up/scale down – et les détruire en fin d’utilisation le cas échéant, nous a décrit Alvin Heib, responsable du produit big data chez Cloudwatt. Les clusters sont facturés en fonction du temps d’usage des nœuds utilisés (maîtres et esclaves indifférenciés), au mois ou à l’heure. Les autres composants du service sont Ubuntu 14.04 et MySQL 5.5.43.

« Nous ouvrons maintenant la partie Analytique as a Service avec un même workflow pour traiter tout type de données », indique Alvin Heib. Les données sont transférées dans le cluster à partir du service de stockage objet de Cloudwatt, utilisé comme un data lake. Elles y sont réinjectées après le traitement qui aura été exécuté (suivant le type de tâches à faire, à partir d’algorithmes JavaScript, Pig, Hive, etc.), explique le responsable big data. « On pourra utiliser les modèles ainsi définis autant que l’on veut ». Plusieurs clients d’Orange Cloud for Business ont déjà démarré des projets. L’offre est ouverte depuis une semaine.

Des clusters orchestrés avec OpenStack Sahara

Avec Hadoop as a service, le cycle de vie des clusters sur Cloudwatt est géré par l’orchestrateur Sahara d’OpenStack. C’est également Sahara qui permet de gérer les tâches Analytics as a service. Il s’installe sur l’un des serveurs cloud créés par le client en lançant la stack Hadoop as a service préparée par Cloudwatt, explique le fournisseur sur son site. C’est à partir de son interface que l’on gère les contrôles d’accès, que l’on peut suivre plusieurs clusters en parallèle, effectuer la planification des tâches, ajouter ou retirer des serveurs dans le cluster, etc.

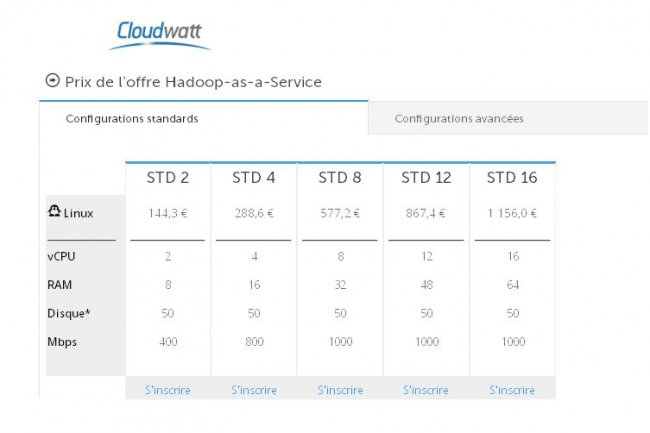

La tarification d’Hadoop as a Service va de 144,30€ à 1 156€ par mois en configurations standards (de 2 à 16 CPU, avec 8 à 64 de RAM, 50 Go sur disque et de 400 à 1000 Mbps de capacités de transfert). La tarification par heure va de 0,222€ à 1,7784€. Cloudwatt fournit l’exemple d’une heure d’usage d’un cluster de 10 nœuds n1.cw.highcpu-4 dont 2 masters et 8 esclaves, facturé 0,3444€ par nœud soit 3,44€.

Commentaire