Databricks veut se passer de toute intervention humaine pour les tâches d'analyse complexes. L’éditeur, qui fournit une version commerciale de la plateforme de traitement de données Open Source Apache Spark, propose maintenant un outil pour configurer et exécuter automatiquement des tâches d'analyse au dessus de celle-ci. « Il devient possible de créer des workflows très complexes sans avoir à recourir à une intervention humaine », a déclaré Ali Ghodsi, directeur de l'ingénierie de Databricks.

L’entreprise a été fondée par les développeurs à l’origine d’Apache Spark et la version commerciale de la plate-forme a été conçue pour tourner sur le cloud d’Amazon Web Services. Spark permet notamment d’analyser de très grands ensembles de données sur plusieurs serveurs, par exemple pour envoyer des recommandations à destination d’un service Internet ou encore faire des prévisions sur les revenus d'une entreprise. A mesure que les entreprises s’accoutument à devoir traiter de très grands volumes de données, ils se mettent de plus en plus à le faire de façon régulière. Cela requiert alors qu’un administrateur se connecte à une console pour coordonner les étapes nécessaires à la réalisation de ces tâches.

Programmer l’exécution d’applications à des moments précis

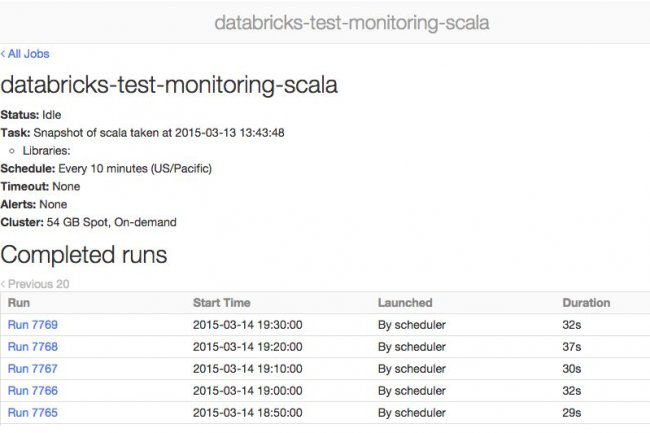

La nouvelle fonctionnalité de Databricks Cloud, appelée Jobs, permet aux administrateurs de préparer cette programmation en amont de façon à ce que chaque tâche soit exécutée de façon autonome et à des intervalles déterminés dans Spark. L’utilisateur peut par exemple programmer l’exécution d’une application Spark sur un cluster Databricks Cloud spécifique à une heure déterminée. Il peut aussi décider s’il préfère utiliser un cluster dédié afin de profiter d’une performance maximale, ou un cluster partagé avec d'autres utilisateurs pour faire des économies. Le service prévient l'utilisateur quand la tâche est terminée. Il tient également à jour un journal qui permet de savoir si la tâche a été exécutée avec succès. Et au moindre problème, le service prévient l'administrateur.

En fait, la fonction revient à mettre en place un pipeline de production, c’est-à-dire une série de tâches réalisées automatiquement et en coordination les unes avec les autres. L’administrateur peut définir un workflow impliquant l’exécution de deux tâches simultanées dans Spark. Une fois ces deux tâches achevées, le flux peut reprendre en charge une nouvelle tâche qui utilisera les résultats des deux premières. Si l'une des deux tâches précédentes échoue, le workflow est interrompu. Les tâches sont inscrites dans des carnets Spark, à l’image des carnets ou notebooks iPython de Python. Générés par l'utilisateur, les carnets Spark contiennent tous les composants nécessaires pour lancer une analyse interactive des données sur un cluster. Ils peuvent être écrits en Python, Scala, SQL, ou tous ces codes à la fois. Le tarif de Databricks dépend de l’usage, du type de support choisi et des fonctions utilisées, sur la base d’un prix plancher de plusieurs centaines de dollars HT/mois.

Commentaire