Sur le salon ISC de Hambourg, Nvidia est revenu sur ses dernières cartes accélératrices Tesla basées sur l'architecture graphique Kepler, déjà utilisée depuis plusieurs mois sur les produits pour gamers avec les Geforce 670/680/690. Les Tesla K10 (avec 2 puces GK104 Kelpler1 avec 8 Go de mémoire) et K20 (avec 2 puces GK110 Kepler2) sont les concurrentes directes de la plate-forme Mic Xeon Phi d'Intel, que nous avons détaillée dans un précédent papier. « Le GPU est une part du HPC même si Intel veut aujourd'hui mettre toute la lumière sur son Mic »., nous a indiqué Sumit Gupta, responsable de l'activité Tesla GPU computing chez Nvidia. Ce dernier nous a exposé les avantages de ces deux cartes et notamment de la K20 qui, en sus de la puissance brute, intègre les fonctionnalités Hyper-Q et le Dynamic Parallelism. Avec l'architecture Fermi (32 coeurs), une seule tâche MPI pouvait être traitée à la fois alors qu'avec Kepler2 (192 coeurs) - et son Hyper-Q - 32 tâches MPI peuvent être exécutées simultanément sous le contrôle d'un processeur. « Cela veut dire que l'on pourra fournir 1 pétaflop dans un système 10 racks avec une consommation de 400 Kwatt », précise M. Gupta.

La Tesla 20 introduit également le concept de parallélisme dynamique ce qui signifie que le GPU s'adapte aux données pour lancer de nouvelles threads mais il ne s'agit pas de prédiction de branches comme sur certains CPU, comme nous l'a précisé M. Gupta. Cela limite simplement les échanges entre le GPU et le CPU pour diminuer la latence due aux aller-retour incessants. Enfin les deux cartes bénéficient d'un agencement différent des blocs de calcul baptisé SMX et qui offrirait un rapport performance/watt trois fois supérieur à la précédente architecture Fermi selon M. Gupta. Enfin, via Cuda 5, l'architecture Kepler bénéficie du GPUDirect qui permet à une puce de communiquer avec une autre puce du serveur ou avec celle d'un autre serveur via le réseau sans passer par le CPU. « Cela enlève la dépendance vis-à-vis du CPU et de la mémoire du CPU », nous a précisé M. Gupta. « Et cela allège la charge de travail du CPU et maximalise l'usage de la mémoire du GPU ».

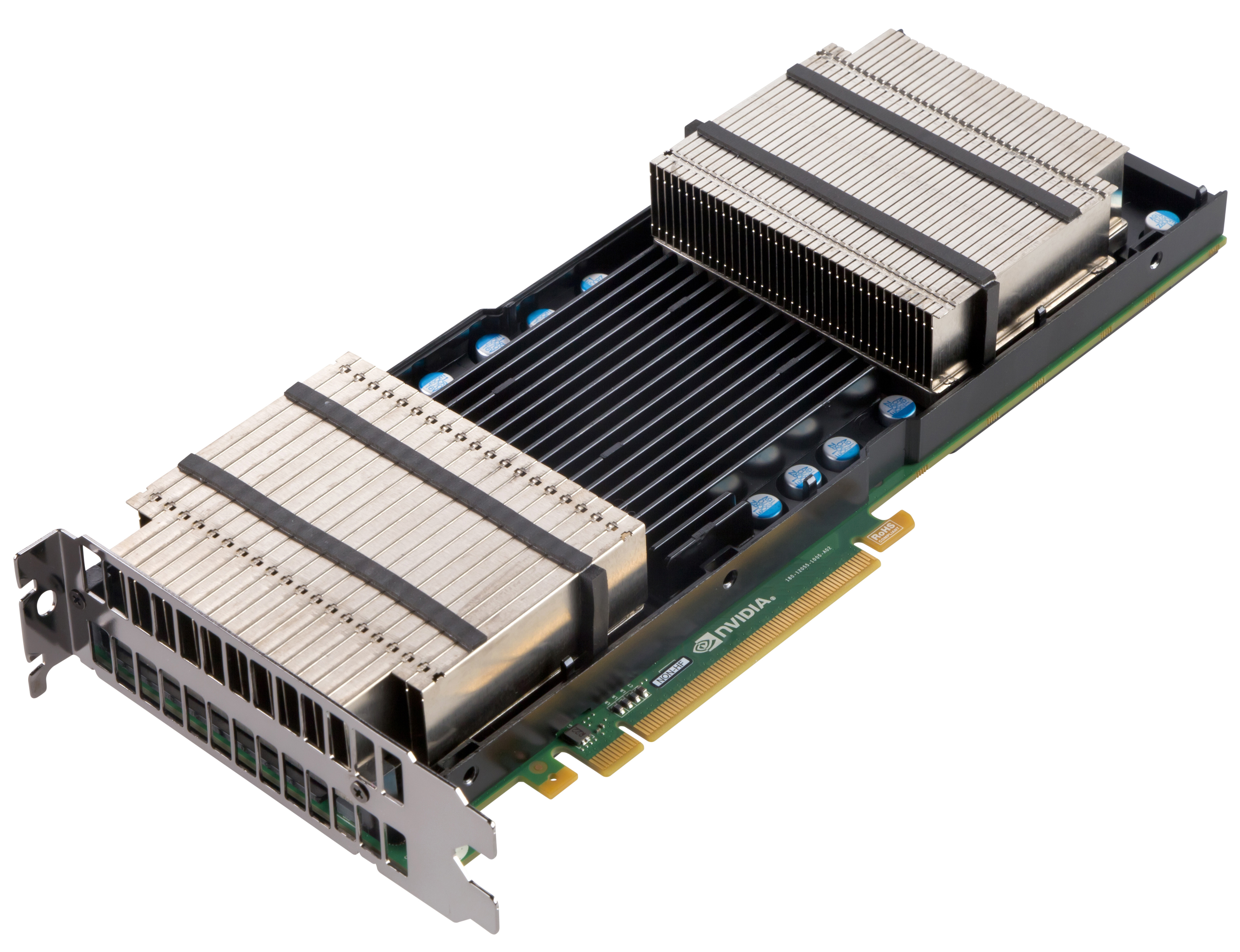

La carte Nvidia Tesla 10 intègre deux puces GK104 basées sur l'architecture Kessler

La K20 disponible en fin d'année seulement

Si la K10 est déjà disponible pour un prix de 2 000 dollars environ, la K20 ne le sera qu'au quatrième trimestre de cette année pour environ 3 000 dollars. Selon M. Gupta les marchés clefs du Tesla 10 sont le pétrole, la défense, la vidéo et les sciences de la vie. Dans ce dernier domaine, les performances pourraient être multipliées par 2 ou 3 avec les applications les plus utilisées en R&D : Amber, Gromacs ou Lammps, Sur la marché de la recherche pétrolière et gazière, où on frappe le sol pour étudier les retours des ondes, les capacités de traitement supérieures permettent d'affiner les calculs géomorphologiques.

Du coté de la plate-forme de développement, Nvidia a présenté en mai dernier Cuda 5 et Nsight pour Linux et Mac OS X. En plus du GPUDirect, Cuda 5 inaugure la compilation segmentée. Il s'agit de compiler séparément des bibliothèques de code puis de les relier au sein d'une seule et même application. Enfin le support d'Eclipse dans l'IDE de développement Nsight apporte une solution aux développeurs Linux et Mac OS X qui ne pouvaient pas ou ne voulaient pas travailler avec Visual Studio.

Serveurs à mémoire partagée

Toujours sur le salon ISC, SGI mettait en avant sa seconde génération de serveurs à mémoire partagée, l'UV 2 supportant jusqu'à 64 To de RAM, qui vient épauler le modèle sorti en 2009, l'UV1. Après des années de domination des serveurs en cluster, les architectures de type ccNuma reviennent sur le devant de la scène pour des usages spécifiques comme la génomique où le traitement de base de données en mémoire permet de comparer plus de 1 000 séquences génétiques, nous a expliqué Marc Simon, directeur technique de SGI France. Les acteurs du web et les grandes oreilles de la défense sont également friands de ce type de machines qui permettent la surveillance en continu des informations circulant sur les réseaux.

Le SGI UV2 repose sur des processeurs Intel Xeon E5-4600 huit coeurs cadencés de 2 à 2,9 GHz. L'UV 20 accueille jusqu'à 4 processeurs - et 32 coeurs donc - épaulés par un maximum de 1,5 To de RAM quand l'UV 2000 intègre jusqu'à 256 processeurs - et 2048 coeurs donc - alimentés par 64 To de mémoire vive. La communication entre les serveurs de l'UV 2000 - 4 racks avec 8 lames de 8 sockets dans un châssis 10U - est assurée par des liens Numalink, un bus haute vitesse et basse latence maison offrant 6,7 Go/s de bande passante. Les distributions Linux Red Hat et Suse sont certifiées pour cette machine.

L'annonce de la plate-forme Xeon Phi d'Intel était l'occasion de rebondir sur les projets de SGI quant au Mic. « La puce est en cours de validation chez nous et devrait apporter une force brute plus facile à utiliser qu'un GPU. C'est une solution pour reprendre la course à la puissance vers l'exaflopique ». Un supercomputer avec des cartes Mic pourra réutiliser du code existant. SGI a déjà un projet avec la Nasa, ICEx, pour passer de 1,7 à 10 pétaflops avec des cartes Mic Xeon Phi. Interrogé sur l'intérêt des processeurs ARM dans le monde du HPC, Marc Simon s'est montré plus dubitatif. « On regarde, on a une équipe de R&D sur le sujet, mais pour accompagne des workflows locaux à la mode web, le cloud computing ou encore le cloud storage ».

ISC 2012 : Nvidia et SGI sur le devant de la scène HPC

0

Réaction

Sur le salon International Super Computing de Hambourg (du 17 au 21 juin), les principaux acteurs du HPC ont profité de l'événement pour remettre en avant ou dévoiler leurs dernières innovations techniques.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire