Andreas Braun, directeur technique de Microsoft Allemagne avait laissé entendre la semaine dernière la sortie prochaine de GPT-4. Ce jour est finalement arrivé, hier, lorsque Sam Altman, CEO d’OpenAI a levé le voile sur cette évolution du transformer qui alimente le service ChatGPT. Dans sa présentation, le dirigeant met l’accent sur le principal élément différenciant : le système multimodal.

Texte, vidéo, audio, le combo magique

Dans la version précédente (3.5) GPT n’était capable que de traiter du texte. GPT-4 va plus loin en traitant non seulement du texte, mais aussi des images, de la vidéo ou de l’audio. « Les démonstrateurs présentés sur le multimodal sont impressionnants », constate Alexei Grinbaum, directeur de recherche au CEA et président du Comité opérationnel pilote d'éthique du numérique (CNPEM). Il ajoute en prenant un exemple, « un étudiant pourra très bien depuis son téléphone prendre une photo d’un devoir et demander à ChatGPT, motorisé par GPT-4 de résoudre le problème ou rédiger une réponse ».

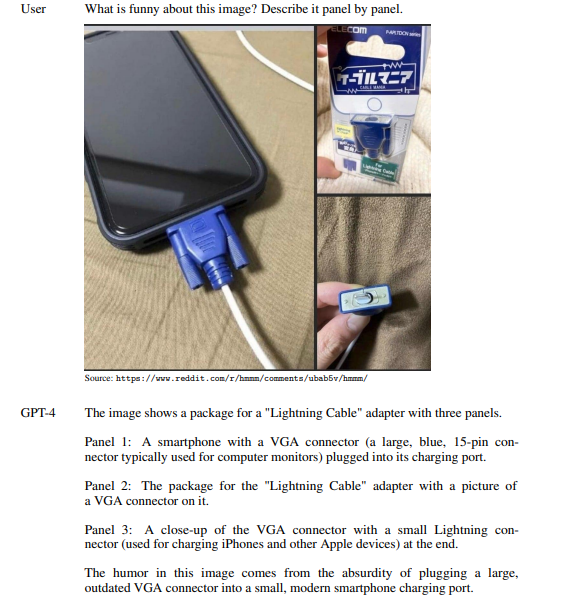

Exemple de reconnaissance d'image et d'explications par ChatGPT. (Crédit Photo : OpenAI)

En dehors des questionnements autour de l’éducation et l’enseignement, GPT-4 apporte des éléments intéressants pour les entreprises. « Il offre des contextes composés de 32 000 tokens, cela signifie la capacité de mettre des textes plus longs quelle que soit la langue, mais également des images comme des PDF. Il est capable d’endosser un rôle (playground) », indique le chercheur. « Par exemple un banquier peut fournir à GPT-4 l’historique d’un client et demander à ChatGPT ensuite de prendre le rôle d’un conseiller financier et de lui proposer des offres ou déterminer si un prêt peut lui être accordé », complète-t-il. Les rôles peuvent être déclinés sur plusieurs professions, RH, conseiller juridique, développeur,… Alexei Grinbaum alerte néanmoins sur le fait que les réponses aussi impressionnantes soient-elles « ne constituent pas une vérité ». Il s’agit de prendre cet outil comme « un brouillon, une aide à la décision ».

Les erreurs subsistent et la concurrence à la peine

En effet, les erreurs (ou hallucinations dans le jargon IA) restent toujours présentes dans GPT-4. « Elles sont plus rares », reconnait Alexei Grinbaum. Il constate par ailleurs qu’OpenAI n’a pas communiqué sur le nombre de paramètres utilisés pour entraîner la dernière itération du transformer. « On sait qu’il tourne sur des dizaines de milliers de cartes accélératrices Nvidia au sein d’un supercalculateur de Microsoft, cela signifie que le temps d’entraînement a été long », suggère-t-il.

Est-ce que GPT-4 plie le jeu face à la concurrence ? Hier, juste avant l’annonce d’OpenAI, Google s’est empressé de dégainer sa riposte en présentant les intégrations des IA génératives dans GCP et sa suite de productivité Workspace. « Les performances du transformer de base chez Google, PALM, ne sont pas moins bonnes que GPT. Par contre, la couche de contrôle LAMDA l’est moins que celle d’OpenAI », constate Alexei Grinbaum. De son côté Facebook (Meta) a choisi une autre voie avec des mini modèles LLAMA dont un vient de fuiter pour être testé en local. Il existe aussi des initiatives européennes comme le projet Bloom, qui en est « au niveau de GPT-2 », remarque le directeur de recherches. Le travail sur ces modèles d’IA est gourmand en ressources IT et en argent, les GAFAM semblent donc plus à même pour s’imposer dans ce domaine. « Mais les initiatives vont se multiplier dans des pays comme la Chine, la Corée ou Israël », prédit Alexei Grinbaum.

Commentaire