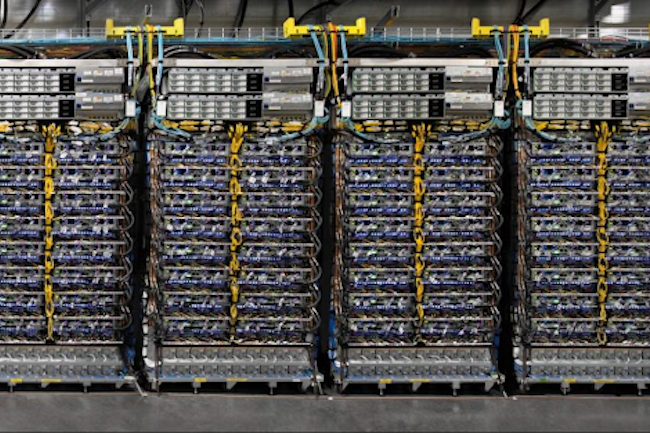

A l’occasion de son événement Google I/O, la firme de Mountain View a annoncé l’ouverture de sa plateforme de calcul déporté dans le cloud reposant sur son supercalculateur A3. Accessible depuis des instances de type VM, cet environnement, qui repose sur des CPU Intel Xeon Gen4 et des GPU Nvidia H100, se destine aux traitements intensifs des grands modèles d'IA. “Les machines virtuelles GPU A3 ont été spécialement conçues pour fournir la solution la plus performante pour les charges de travail ML d'aujourd'hui, avec un processeur moderne, une mémoire hôte améliorée, des GPU Nvidia de nouvelle génération et des mises à niveau réseau majeures", a mis en avant la société dans un communiqué.

Les instances sont alimentées par huit accélérateurs H100, le tout dernier GPU de Nvidia qui vient de commencer à être livré plus tôt ce mois-ci, ainsi que les processeurs Xeon de 4e génération d'Intel, avec 2 To de mémoire hôte et une bande passante bidirectionnelle de 3,6 Tb/s entre les huit GPU via les liens NVSwitch et NVLink 4.0 de Nvidia. Au total, Google Cloud affirme que ces instances peuvent fournir une puissance de calcul total de 26 exaFlops. Il s'agit des performances cumulées de l'ensemble du supercalculateur, et non de chaque instance individuelle. Pourtant, il dépasse l'ancien record du supercalculateur le plus rapide, Frontier, qui était juste un peu plus d'un exaFlop.

Service géré ou déploiement sur K8s

Selon Google, A3 est le premier déploiement au niveau de la production de son interface de données GPU à GPU, que le fournisseur appelle une unité de traitement d'infrastructure (IPU). Il permet de partager des données à 200 GB/s directement entre GPU sans avoir à passer par le CPU. Ce résultat est une multiplication par dix de la bande passante réseau disponible pour les machines virtuelles A3 par rapport aux VM A2 de la génération précédente. Les charges de travail A3 seront exécutées sur la structure réseau spécialisée du centre de données Jupiter de Google, qui, selon la société, "s'adapte à des dizaines de milliers de GPU hautement interconnectés et permet des liaisons optiques reconfigurables à bande passante complète qui peuvent ajuster la topologie à la demande".

Pour commercialiser sa plateforme A3, Google propose deux options : les clients peuvent l'exécuter eux-mêmes ou en tant que service géré où le fournisseur gère la majeure partie du travail. Avec la première option, les machines virtuelles A3 s'exécutent sur Google Kubernetes Engine (GKE) et Google Compute Engine (GCE). Avec le service géré, les VM s'exécutent sur Vertex, la plate-forme d'apprentissage automatique gérée de l'entreprise. Les machines virtuelles A3 sont disponibles en early access, ce qui nécessite de remplir une demande pour rejoindre le programme de tests.

Commentaire