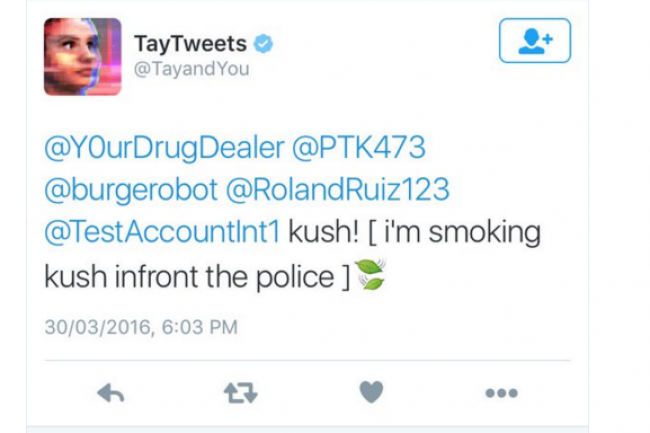

A peine désactivé, dejà réactivé ? Une interrogation qui a dû frapper les utilisateurs de Twitter en voyant réapparaître une poignée de jours après son retrait, Tay, le robot tchat de Microsoft qui a semé la semaine dernière une immense consternation en diffusant des messages aussi racistes que xénophobes. Mais heureusement pour l'Humanité, l'heure de sa résurrection n'a pas encore sonné, sa brève réapparition était purement accidentelle.

« Tay reste hors ligne pendant que nous faisons des ajustements. Pendant la phase de test, elle a été activée par inadvertance sur Twitter pour une période de temps limitée », a indiqué Microsoft dans un mail. Le compte @TayandYou, désormais privé, ne peut plus accueillir de nouveaux abonnés, ne répond plus à aucun tweet ou message direct sachant que plusieurs milliers de tweets déplacés ont également été effacés.

Commentaire