Livré dans les temps impartis par IBM, quatre ans après la signature du contrat pour sa commande, le supercalculateur Summit est désormais en fonctionnement au laboratoire national Oak Ridge, situé dans l’Etat du Tennesse aux Etats-Unis. La machine de 200 pétaflops sera entièrement opérationnelle d’ici le début de l’année prochaine, selon Jack Wells, directeur scientifique, responsable des équipements informatiques du laboratoire. « C’est le plus puissant et le plus grand superordinateur scientifique du monde », décrit-il. Le Summit a été conçu pour travailler sur des projets de physique nucléaire, de sismologie et de climatologie. Les charges de travail associées à ces domaines démarrent typiquement avec un modèle et un jeu de conditions initiales avant de générer d’énormes volumes de données pendant leur traitement jusqu’à l’obtention d’une solution.

Mais les concepteurs du supercalculateur l’ont également conçu pour de nouvelles catégories d’applications, comme les études de génomique ou les problématiques d’apprentissage machine. Celles-ci démarrent d'emblée avec de volumineux jeux de données sur lesquels sont recherchées des explications succinctes. « Nous pensions qu’il pourrait y avoir une forte augmentation des applications intensives dans les programmes de nos utilisateurs et effectivement, c’est ce qui s’est produit », constate Jack Wells. Il y a en ce moment une dizaine de projets de deep learning qui demandent du temps de calcul sur Summit, alors qu’il n’y en avait aucun il y a quelques années, cite en exemple le directeur scientifique.

La barrière exaflopique franchie sur certains calculs

L’architecture du Summit – la façon dont sa mémoire est partagée entre les processeurs – et sa capacité à traiter d’importants volumes de calcul avec une précision réduite est particulièrement adaptée à des projets de cette nature. Summit tourne sous système d’exploitation Red Hat Linux. A d’autres égards, c’est également un supercomputer inhabituel. Si les benchmarks de performance atteignent ce qui est prévu, le système sera bientôt en tête du classement Top 500 qui établit la liste des supercalculateurs les plus puissants du monde, avec une puissance de 200 petaflops en pic de performance, soit 200 millions de milliards d’opérations en virgule flottante par seconde. Actuellement, celui qui détient la première place, le Sunway TaihuLight chinois, atteint 125,4 petaflops.

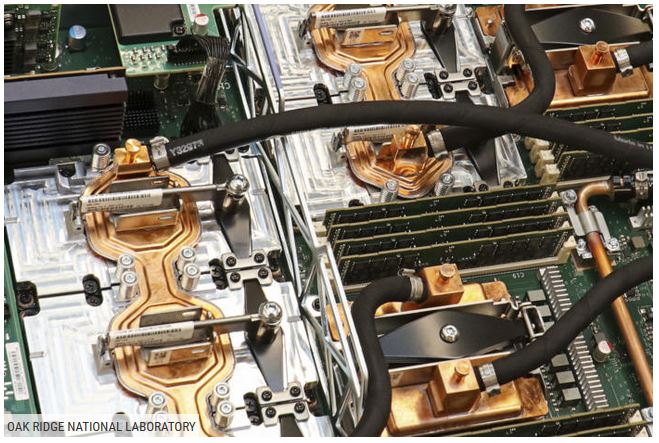

L'architecture du Summit est adaptée aux types de traitement requis par le deep learning. (Crédit: ORNL)

Selon d’autres calculs effectués alors que la machine n'était pas entièrement construite, le Summit a atteint plus de 1,88 exaflops, ou 1,88 milliard de milliards d’opérations par seconde. C'était la première fois que la barrière exaflopique était franchie, a indiqué Thomas Zacharia, directeur du laboratoire Oak Ridge, à l'équipe du Top500. Les chercheurs l'ont obtenu en exécutant un code de comparaison génomique en utilisant les capacités Tensor Core des GPU. Ces calculs sont effectués en 16 bits (demi-précision), en arithmétique en nombres à virgule flottante, plutôt qu’en mode 64 bits (double précision) communément utilisé en modélisation scientifique, précise Jack Wells en expliquant que c’est suffisant pour de nombreux calculs utilisés dans en deep learning ou en génomique.

Moins de serveurs que sur le Titan qu'il remplace

Le Summit a bien moins de nœuds de calcul que le Titan qu’il est destiné à remplacer et qui était lui-même l’ordinateur le plus puissant du monde en novembre 2012. Mais, alors que chacun des 18 688 nœuds s’appuyait sur une puce Opteron d’AMD secondé par un processeur graphique Kepler de Nvidia, les 4 600 nœuds du Summit comportent chacun 2 processeurs Power9 d’IBM et 6 GPU Tesla V100 de Nvidia. Il s’agit de puces qui peuvent prendre en charge des calculs à différents niveaux de précision de façon très efficaces. Ces nœuds sont associés à une mémoire vive DDR4 de 512 Go pour les Power9s, 96 Go de mémoire haute vitesse (HBM2) pour les GPU V100 et 1,6 To pouvant être utilisé comme buffer. En outre, du point de vue du programmeur, cette mémoire est partagée entre CPU et GPU et peut être traitée comme un seul block pour accélérer encore les opérations.

Chaque noeud du supercomputer Summit bâti par IB pour le département de l'Energie est équipé de 2 CPU IBM Power9 et 6 GPU Nvidia Tesla V100. (crédit : ORNL)

Les nœuds sont répartis en trois catégories : ceux chargés de compiler le code et d’attribuer les tâches à la connexion, ceux qui exécutent les tâches par lots et, enfin, les nœuds de traitement qui prennent en charge les calculs importants. Comme ils sont physiquement identiques, il n’est pas nécessaire d’effectuer des compilations croisées pour différentes cibles. Un réseau InfiniBand EDR dual-rail les relie avec une bande passante de 23 Go/s. Les commutateurs sont disposés dans une topologie Fat Tree non bloquante à trois niveaux ce qui signifie que n’importe quelle combinaison de 2 nœuds doit être capable de communiquer sur la totalité de la bande passante, peu importe ce que font les autres nœuds.

Des serveurs installés à un rythme soutenu

A peu près au même moment où le département de l’énergie a confié à IBM la construction du Summit à Oak Ridge, le constructeur s’est vu également demander de bâtir un autre supercalculateur, le Sierra, au laboratoire national Lawrence Livermore. Les deux projets présentent une différence notable : alors que le datacenter du Lawrence Livermore utilise le traditionnel plancher surélevé, l’eau et l’alimentation arrivent par le haut dans celui du Oak Ridge. « Nous avons dû réorienter le système et l’armoire elle-même, pour pouvoir l’installer à Oak Ridge », a expliqué Wayne Howell, vice-président de l’ingénierie d'IBM Systems.

Cela signifie aussi qu’il a d’abord fallu installer toute l’infrastructure – les racks, le système de refroidissement, le réseau – avant de mettre les serveurs en place. « Si nous avions essayé de bâtir l’infrastructure tout en effectuant les connexions, il aurait été difficile de tout coordonner », juge Wayne Howell en imaginant la pagaille que cela aurait pu être. Cela signifie que les serveurs ont dû être installés à un rythme soutenu sur une courte période. Une fois que les choses commencent à se mettre en place, il ne faut alors aucune interruption.

Des avions affrétés pour pallier les conditions climatiques

Le projet en a pourtant connu, causé par le mauvais temps (l’installation s’est faite cet hiver) ou par la panne d’un semi-remorque. Lorsque ce dernier a immobilisé son chargement de serveurs quelque part entre l’usine d’IBM en Californie et le laboratoire situé au Tennessee, l’équipe a envoyé un autre véhicule pour aller les chercher plutôt que d’attendre la livraison suivante. Cela a permis de limiter l’attente à quelques heures sur un trajet de quelques milliers de kilomètres, souligne Wayne Howell. Et quand la météo s’en est mêlée en interrompant tous les semi-remorques, IBM a alors mis en place un transport par avion. « Certaines pièces étaient très grandes, nous avons donc dû affréter des avions de grande capacité pour pouvoir les transporter », relate le vice-président de l’ingénierie chez IBM Systems.

D’autres problèmes se sont présentés. Il faut imager le volume que représente les emballages dans lesquels sont transportés tous ces matériels. Oak Ridge fut rapidement envahi. Plutôt que de les transporter à la déchetterie, IBM les a renvoyés dans un des camions qui avaient apporté les serveurs. Les derniers équipements ont été livrés en mars 2018. « Nous continuons à roder le logiciel », précise Wayne Howell. L’objectif est de terminer les derniers tests cet été. En janvier 2019, le supercalculateur sera en exploitation complète.

Commentaire