Créé en 2021 par Donpaul Stephens (CEO), un des deux fondateurs de Violin Memory, Matt Youill (responsable de l'analytique) un spécialiste des bases de données auparavant chez Betfaire.com, et Chia-Lin Wu (en charge du stockage objet), une ancienne d’AOL, AirMettle ambitionne de bouleverser le paysage du big data avec Analytical Storage, une plateforme de stockage et d'analyse de données (structurées, semi-structurées et non-structurées) compatible S3 baptisée . Toujours en cours de développement, ce projet est soutenu par des organismes publics, des universités et des entités de recherche tels que Carnegie Mellon, le Los Alamos National Labs, la National Science Foundation NOAA, ou encore l’Université de Chicago. Comme chez feu Igneous (première époque), StorageX, Yellowbrick Data ou même Databricks et Snowflake, la solution d'AirMettle vient bouleverser le paradigme analytique traditionnel en intégrant des capacités de traitement parallèles directement dans sa plateforme de stockage objet. Au lieu de déplacer les données vers les serveurs, AirMettle apporte la puissance de calcul aux données, ce qui permet d'effectuer des traitements analytiques sur place, au sein même de la couche de stockage et de réduire une partie des coûts allouée aux infrastructures. Comme l’explique la start-up, La valeur ajoutée consiste à réduire le trafic réseau à l'ensemble des résultats de la requête plutôt qu'à l'ensemble des données.

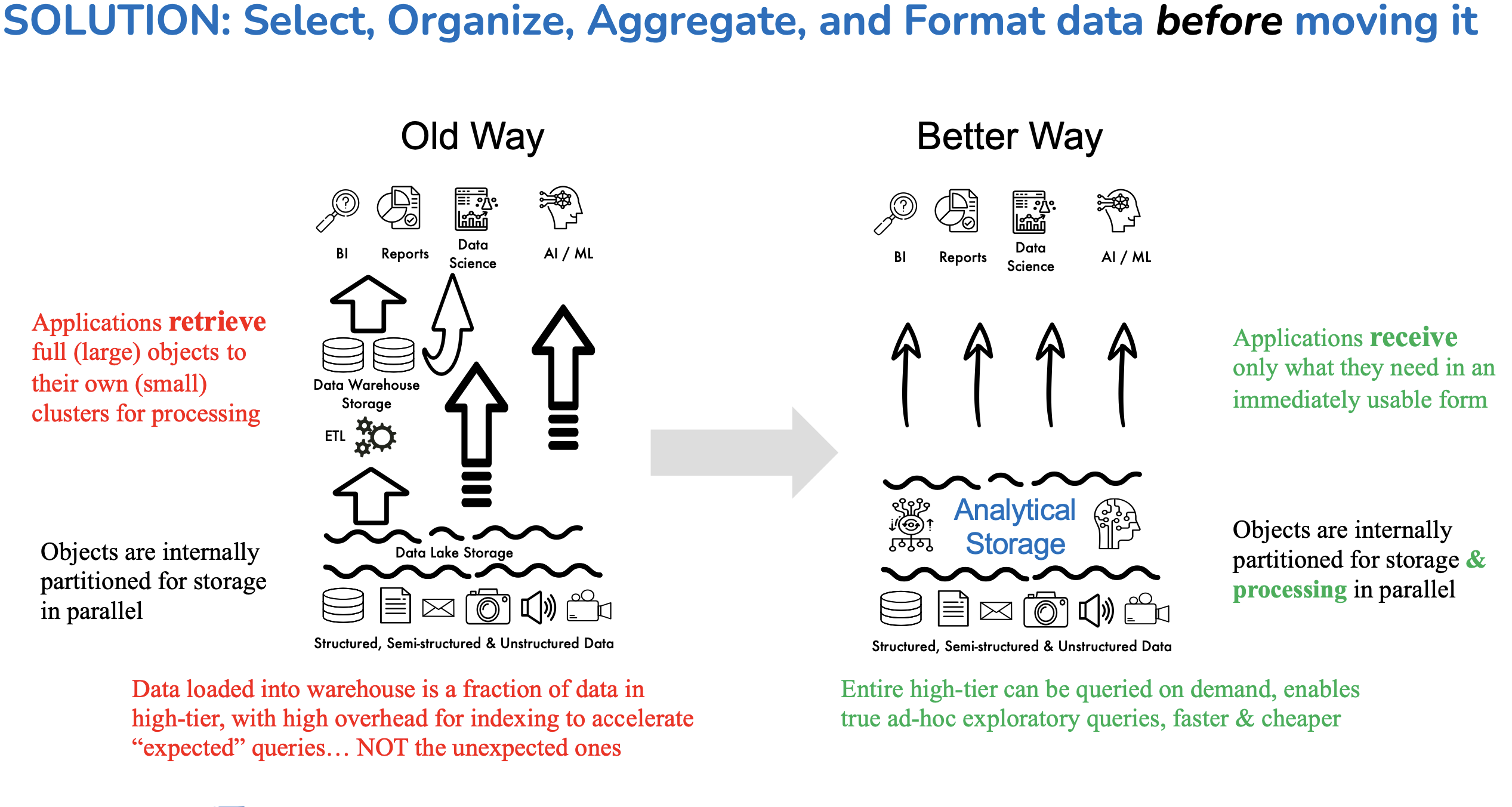

Avec AirMettle, l'ensemble du processus analytique se déroule au sein de la couche de stockage, ce qui élimine la nécessité de déplacer les données et permet des temps de réponse plus rapides. (Crédit S.L.)

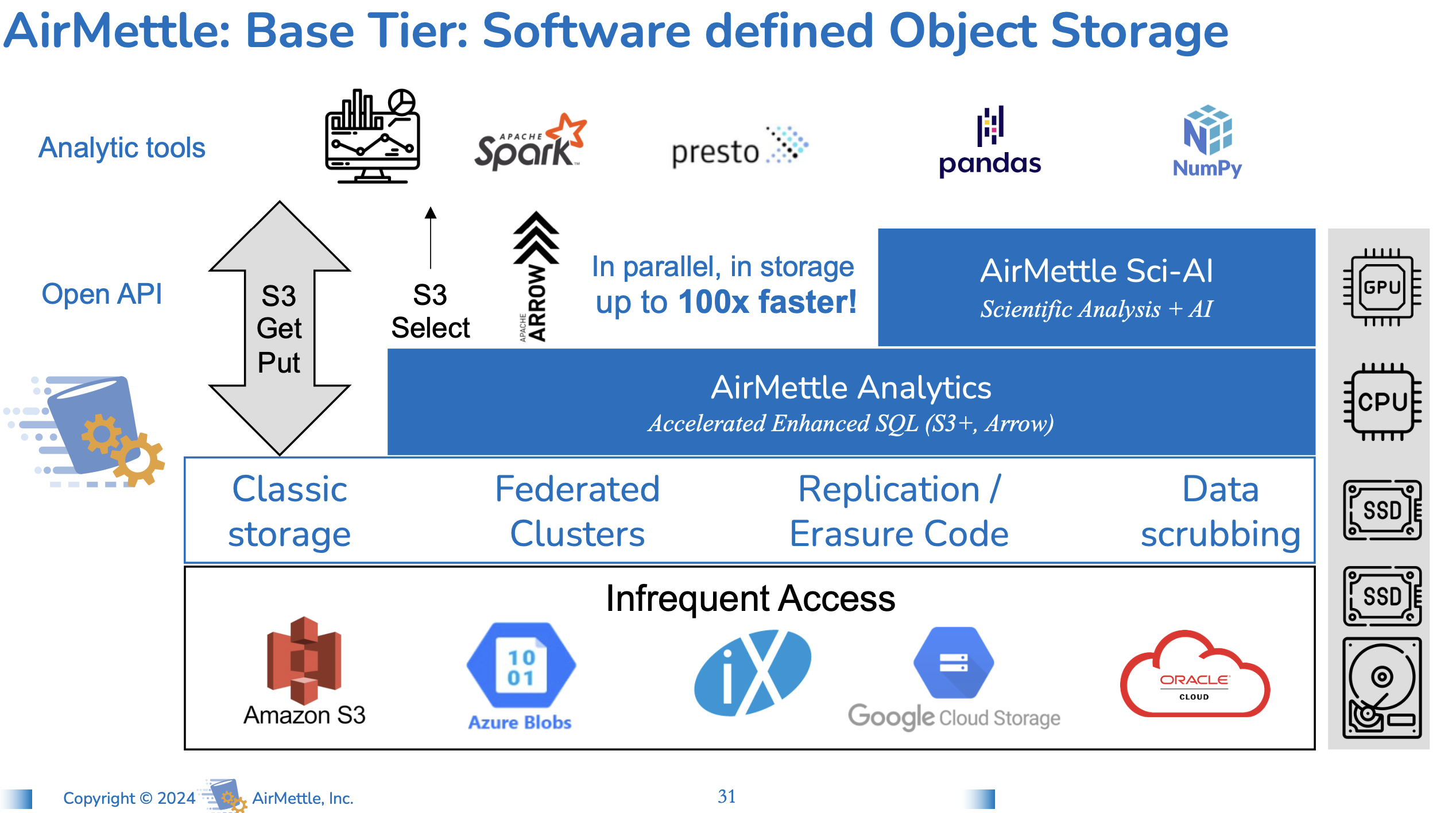

Et pour éviter les silos, les ensembles de données partiels et l'indexation limitée, la solution de la start-up exploite un modèle horizontal avec un système sophistiqué de partitionnement et de gestion des métadonnées. Lors de l'ingestion, les objets (documents, images, vidéo, etc.) sont segmentés de manière transparente en composants logiques, chaque objet étant taggé avec son propre ensemble de métadonnées. Ces dernières permettent ensuite à AirMettle d'effectuer un large éventail d'opérations analytiques, telles que la sélection, l'agrégation et le formatage, en parallèle sur ces segments, sans qu'il soit nécessaire de déplacer ou de dupliquer les données. Les données sont transmises aux systèmes analytiques sans devoir passer par un outil ETL pour alimenter un data warehouse, qui est ensuite utilisé comme source de données d'analyse. La plateforme d’AirMettle effectuant intrinsèquement l'ETL en interne. L’idée est d’abandonner le concept de data warehouse pour stimuler le traitement analytique avec une plateforme, fonctionnant sur site ou dans le cloud, capable d'accélérer une grande variété de charges de travail analytiques, à savoir requêtes SQL, analyses multidimensionnelles et même le traitement de données non-structurées telles que les images, les sons et les vidéos, avec des capacités IA.

La couche de stockage objets exploite une interface compatible S3 avec erasure coding et réplication pour garantir l’intégrité des données stockées sur les clusters. (Crédit S.L.)

Si AirMeetle n'a pas encore démarré une véritable commercialisation de son logiciel, il a déjà des clients payants comme Los Alamos Labs et la National Oceanic and Atmospheric Administration aux États-Unis. Lors d’un IT Press Tour en janvier dernier à SF, le CEO nous a expliqué qu'AirMettle discute avec des opérateurs télécoms pour des cas d’usages comme le traitement de vidéo, ainsi que la sélection et la remise à l'échelle de données météorologiques.

Commentaire