Il vous reste 96% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

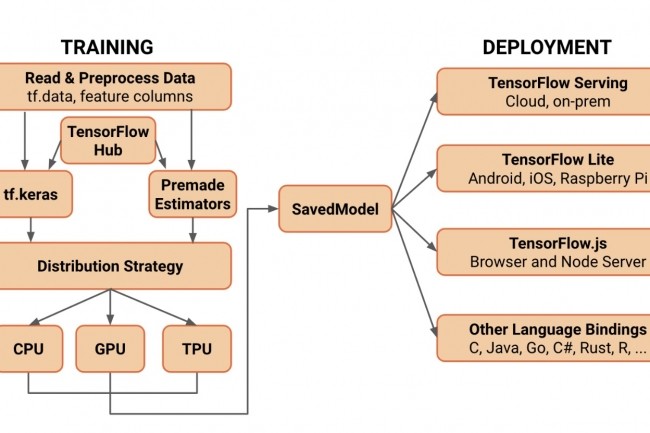

Utilisée avec le langage Python ou avec JavaScript, la bibliothèque open source TensorFlow, développée par Google, facilite et accélère l'apprentissage automatique et le développement de réseaux neuronaux.

Il vous reste 96% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire