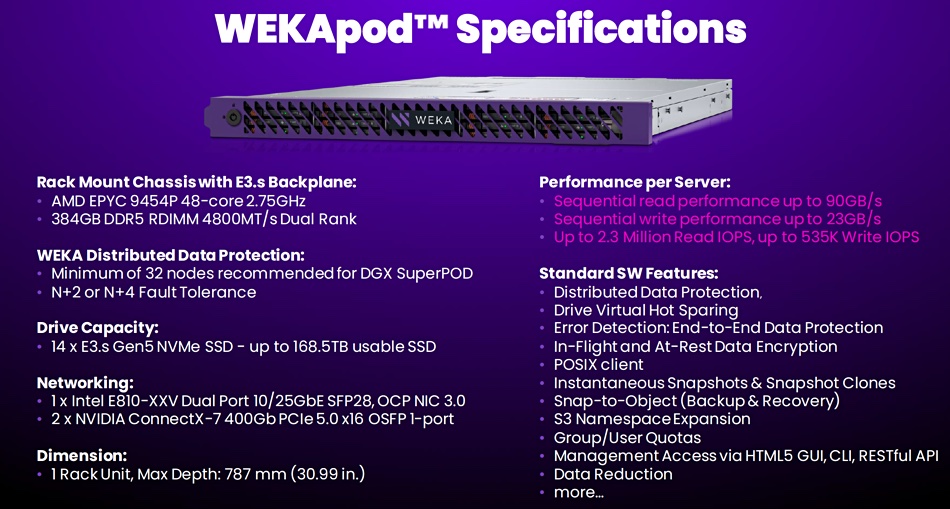

Dans la course au stockage pour les serveurs HPC, une solution fait la différence avec les autres propositions : les systèmes de fichiers parallèles et distribués. Sur ce marché, peu d’élus ont vraiment réussi à percer : dans le rapport du cabinet d’études Coldago (High Performance File Storage) huit fournisseurs sont classés parmi les leaders à savoir DDN, Dell, Huawei, IBM, Pure Storage, Qumulo, VAST Data et Weka, devant les challengers Quantum, HPE, Panasas et ThinkParq. Sur ce segment, un seul point fait la différence : la performance. Et à ce petit jeu, Weka a marqué un bel essai avec le lancement de sa plateforme WekaPod, taillée pour les systèmes DGX de Nvidia. Intégré au gestionnaire Base Command de Nvidia pour l'observabilité et la surveillance, chaque appliance WekaPod se compose de nœuds de stockage 1U préconfigurés avec WekaFS (voir notre précédent sujet sur l'architecture) pour un déploiement simplifié et plus rapide. Une configuration WekaPod de 1 Po commence avec huit nœuds de stockage et peut monter à plusieurs centaines (par lot de quatre) avec des liens Nvidia InfiniBand ConnectX-7 (400 GBps). Weka précise qu’associer à un serveur DGX, une baie WekaPod est capable d’ingérer 90 Go de données par seconde et d’enregistrer ses résultats à la vitesse de 23 Go/s. Une seule configuration WekaPod Data Platform Appliance peut fournir jusqu'à 18,3 millions d’IOPS à un système DGX SuperPOD (un cluster de 8 serveurs DGX), avec 20 Gbps de bande passante en lecture séquentielle, et 186 Gbps de bande passante en écriture à partir de huit nœuds. Cela représente 90 Go/s/nœud en lecture et 23,3 Go/s/nœud en écriture.

Taillés pour la performance, les WekaPod ont été certifiés pour les serveurs DGX de Nvidia. (Crédit Weka)

Supporter toutes les charges de travail sans tuning, en apportant les meilleures performances pour les metadatas avec des millions de fichiers sur de multiples clusters est un bon résumé de l’ambition de Weka. " L'une des choses pour lesquelles nous sommes vraiment connus, c'est que nous ne nous soucions pas du type d'IO qui entre dans le système. Ce n'est pas seulement du streaming, c'est vraiment du full random, des lectures et des écritures... Nous y parvenons parce que nous sommes hautement parallélisés sur l'ensemble du cluster” nous a expliqué Joel Kaufman, senior technical marketing manager chez Weka lors d’un IT Press Tour en Californie début mars.

3 040 brevets pour protéger sa solution

" L'une des principales caractéristiques n'est pas seulement le fait que nous pouvons effectuer des entrées-sorties parallèles sur les données elles-mêmes, mais aussi sur les métadonnées. Nous créons des ensembles de serveurs virtuels, essentiellement pour gérer les métadonnées d'une partie du système de fichiers. Et comme tout se fait en parallèle, nous obtenons des opérations de méditation extrêmement rapides, un temps de réponse extrêmement rapide et une faible latence sur l'ensemble du système”, a poursuivi M. Kaufman. Weka a ajouté 3 040 brevets supplémentaires pour protéger “sa sauce secrète”. Le second point mis en avant par Weka est que l’infrastructure est une simple commodité tant qu'elle répond au cahier des charges : un ensemble de SSD NVMe connectés en réseau, sur site ou dans le cloud. Et comme la solution est de type Software Defined Storage, l’adoption des nouveaux équipements est très rapide, ce qui a permis à Weka de certifier très rapidement des matériels après la pénurie qui a suivi la pandémie.

Des performances au dessus du lot

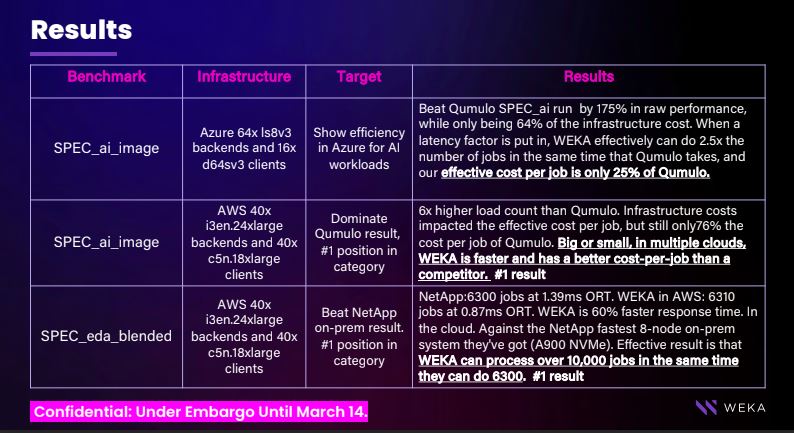

Un dernier mot sur les performances : à l’occasion de la GTC de Nvidia (du 17 au 21 mars), Weka a présenté une série de benchmarks SPECStorage Solution 2020 qui permettent de comparer la vitesse des systèmes de fichiers au prorata des caractéristiques matérielles sur lesquelles ils s’exécutent. “Donc le SpecStorage 2020, nous avons fait deux séries de tests”, nous a expliqué Joel Kaufman. La première était spec AI image pour les charges de travail d'IA. “Nous avons utilisé un environnement Azure, pour montrer l'efficacité absolue que nous pouvons obtenir. Un autre acteur du cloud, Accumulo, a obtenu des résultats dans ce domaine. Nous sommes sortis du lot, et pas seulement en termes de performances brutes, où nous sommes 175 % plus rapides. Mais il s'avère que nous n'avions que 64% des coûts d'infrastructure qu'Accumulo devait supporter. Notre temps de latence était tellement plus faible que lorsque vous prenez le nombre de tâches simultanées multiplié par le temps de latence, il s'avère que nous pouvons faire deux fois plus de tâches qu'il n'en faut”. (voir ci-dessous).

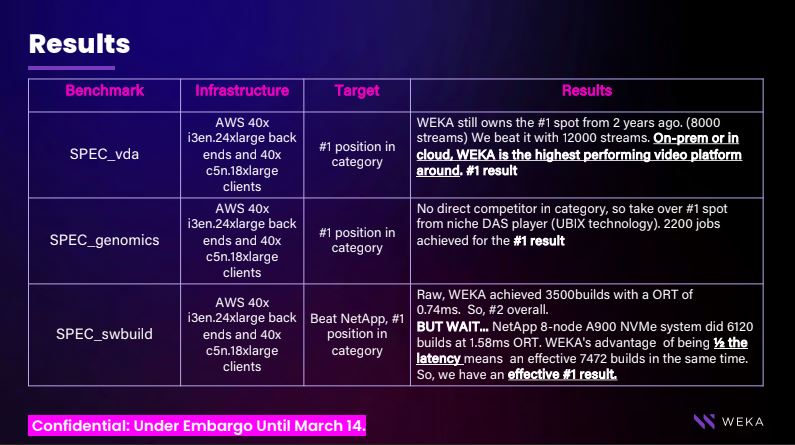

Weka a ensuite adopté une approche légèrement différente en tentant de construire un système d'une efficacité absolue. “Dans AWS, nous avons mis en place un très grand environnement sans changer les réglages avec AI image EDA blended “. (voir ci-dessous). Le cluster de 40 machines virtuelles avec 24 cœurs affiche des débits 1,75 fois supérieurs au système de Qumulo dans les mêmes conditions : “ Weka fournit un nombre de chargements 6x plus élevé (2400) que Qumulo pour un coût par tâche 76% moins élevé. Et fait même mieux qu’une baie NetApp AFF A900 NVMe composée de huit nœuds contrôleur : “ Avec SPEC_eda_blended , Weka peut traiter 10000 tâches dans le même temps que NetApp peut en traiter 6300”. Les benchmarks sont faits pour être dépassés, mais Weka montre ici sa maitrise sans pareil du stockage parallèle et distribué pour les environnements HPC.

Commentaire