Nvidia, qui vient d’annoncer des résultats financiers dépassant les attentes des analystes au dernier trimestre fiscal 2020 (des bénéfices de 950 millions de dollars pour un chiffre d'affaires de 3,11 milliards de dollars fin janvier), poursuit ses efforts sur le marché des datacenters et des accélérateurs GPU pour l’IA et le HPC. À l’occasion de sa convention GTC 2020, diffusée en ligne cette année pour cause de pandémie, le CEO de Nvidia Jen-Hsun Huang devrait présenter la plate-forme GPU Ampere, qui vient succéder à Volta, avec des performances en hausse.

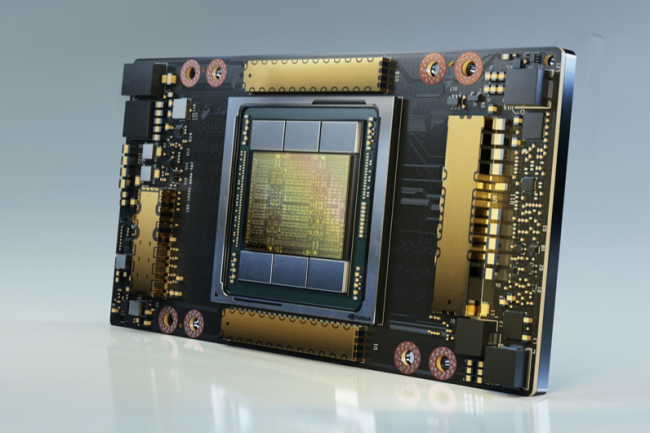

Gravé en 7 nm par TSMC avec une surface de 826 mm2 (contre 12 nm et 815 mm2 pour Volta), le circuit A100 (Ampere) intègre 54 milliards de transistors (21,1 pour Volta) avec des coeurs Tensor de 3e génération pour le machine learning. Le nombre de coeurs Cuda passe à 6912 contre 5120 pour Volta. Nvidia annonce une hausse des performances multipliées par 20 en FP32 (simple précision nombres à virgule flottante 32 bits) - soit 312 Tflops - et en inférence IA (nombres entiers à 8 bits) - soit 1,248 Tops - par rapport à sa précédente génération de GPU (Volta). Pour les calculs HPC en FP64 (double précision, nombres entiers 64 bits), la puce monte à 19,5 Tflops, soit une augmentation de x2,5.

Intel en embuscade avec Xe-HP

De son côté, Intel n’a pas encore précisé le nombre de transistors dans son accélérateur GPU Xe-HP Ponte Vecchio, gravé lui aussi en 7 nm et destiné au marché des supercalculateur. Mais il devrait dépasser les 35 milliards de transistors selon les derniers tweets de Raja Koduri, en charge du développement de cette plate-forme GPU chez Intel. Mais cet accélérateur est attendu en 2021 alors que la plate-forme Ampere est déjà entrée en production.

En attendant la sortie de son accélérateur GPU Xe-HP, Intel doit occuper le terrain médiatique avec des préannonces encore peu fournies. (Crédit Intel)

Selon Paresh Kharya, directeur produits management, datacenter et cloud plate-forme chez Nvidia, qui a tenu une préconférence de presse le mercredi 13 mai à l’attention des journalistes, trois technologies rendraient Ampere « très spéciale » selon. L’utilisation de coeurs Tensor de 3e génération (TF32), l’accélération sparsity et la gestion de plusieurs instances GPU. Avec TF32 (Tensor Float 32), Nvidia met en avant un modèle plus efficace pour les calculs en virgule flottante en IA, qui utilise une mantisse 10 bits de FP16 et l'exposant 8 bits de FP32. C’est ce qui explique le gain en performances (x20). Autre amélioration, le noyau tensoriel de 3e génération introduit avec Ampère prend en charge FP64 en natif. « Avec cette nouvelle précision, l’A100 offre 20 fois plus de calcul pour l'IA simple précision, et parce que les développeurs peuvent continuer à utiliser les entrées en simple précision et récupérer les sorties en simple précision, ils n'ont rien à faire de différent. Ils bénéficient automatiquement de cette accélération dès la sortie de la boîte », assure le dirigeant.

Déjà prévendu en Allemagne

Nvidia améliore aussi son traitement sparsity en exploitant un peu mieux le phénomène de rareté dans les réseaux de neurones. Une autre fonctionnalité pour HPC introduite avec l’A100 est la multi-instance GPU, qui permet à plusieurs applications complexes de s'exécuter sur la même puce sans partager de ressources telles que la bande passante mémoire, a expliqué M. Kharya. Il est possible de partitionner une puce A100 et d’obtenir jusqu'à 7 GPU virtuels avec des spécifications différentes, et de s'assurer qu'une application s'exécutant sur l'un des vGPU ne consomme pas les ressources de l'autre. En Allemagne, Atos a déjà vendu un supercalculateur baptisé Juwels au Centre de recherche des Laboratoires Jülich, qui s'annonce comme le plus puissant d’Europe avec une puissance de calcul de 70 pétaflops. Installé en septembre 2020, il embarquera plusieurs centaines de lames BullSequana X215 reposant sur des puces AMD Epyc couplées à des GPU Nvidia A100 interconnectés en NvLink.

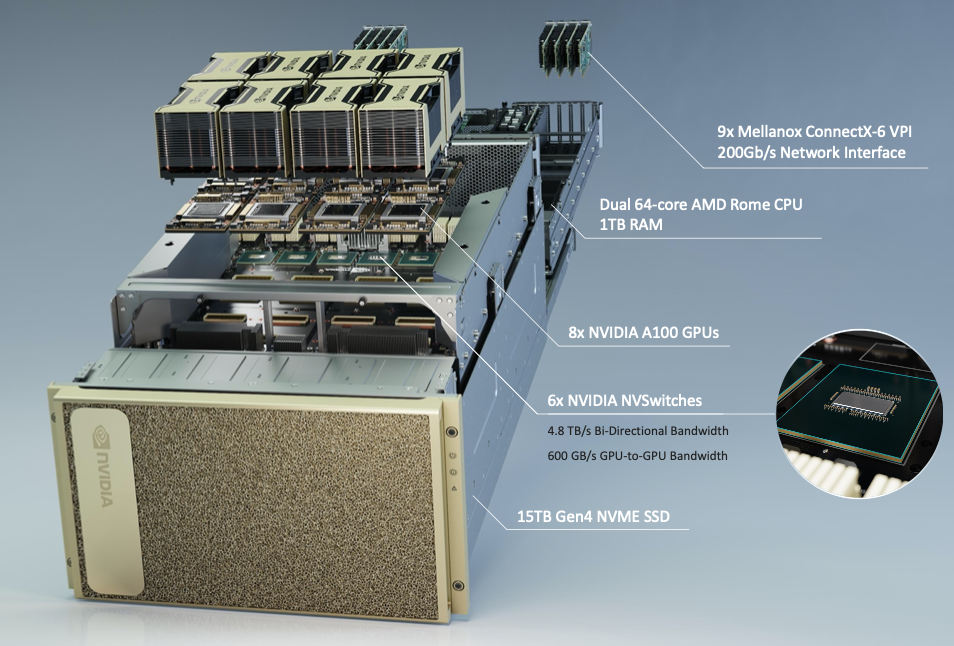

Avec la présentation de sa puce A100, Nvidia met aussi en avant son serveur HPC désormais baptisé DGX A100. Cette troisième génération de machine dédiée aux traitements IA combine toujours une paire de puces x86 (des AMD Epyc Rome 64 coeurs cette fois en remplacement d’Intel Xeon précédemment) et huit accélérateurs GPU Nvidia A100 pour une puissance de calcul de 5 pétaflops (FP16) sur un seul nœud. Le tarif est toujours corsé avec un démarrage à 199 000 $ HT pour un serveur. Pour un rack DGXA100 AI avec 5 noeuds DGX A100 (28 kWh) compter 1 million de dollars. Selon Nvidia, ce dernier est capable de remplacer un pod avec 50 DGX-1 (25 racks avec 600 GPU V100) facturé 11 millions de dollars et consommant 630 kWh. Le fournisseur destine ces systèmes aux traitements IA, mais également à l’analyse de données et aux applications scale-out. Les systèmes DGX-A100 ont déjà été installés au laboratoire national d'Argonne du département américain de l'Énergie, où ils sont notamment utilisés pour comprendre et combattre le Covid-19.

Un seul rack avec 5 DGX-A100 peut remplaçant un pot avec 25 DGX-1 , consommant 1/20 e de la puissance et coûtant un dixième des investissements pour un système équivalent basé sur CPU. (Crédit Nvidia)

Et, comme toujours chez Nvidia, l’annonce de cet accélérateur GPU préfigure l’arrivée de cartes graphiques plus musclées sous la dénomination RTX 3000 avec une amélioration du calcul en ray-trading et un coup de boost attendu avec la version finale de DirectX12 intégrée à la prochaine mise à jour de Windows 10 (fin mai).

Commentaire