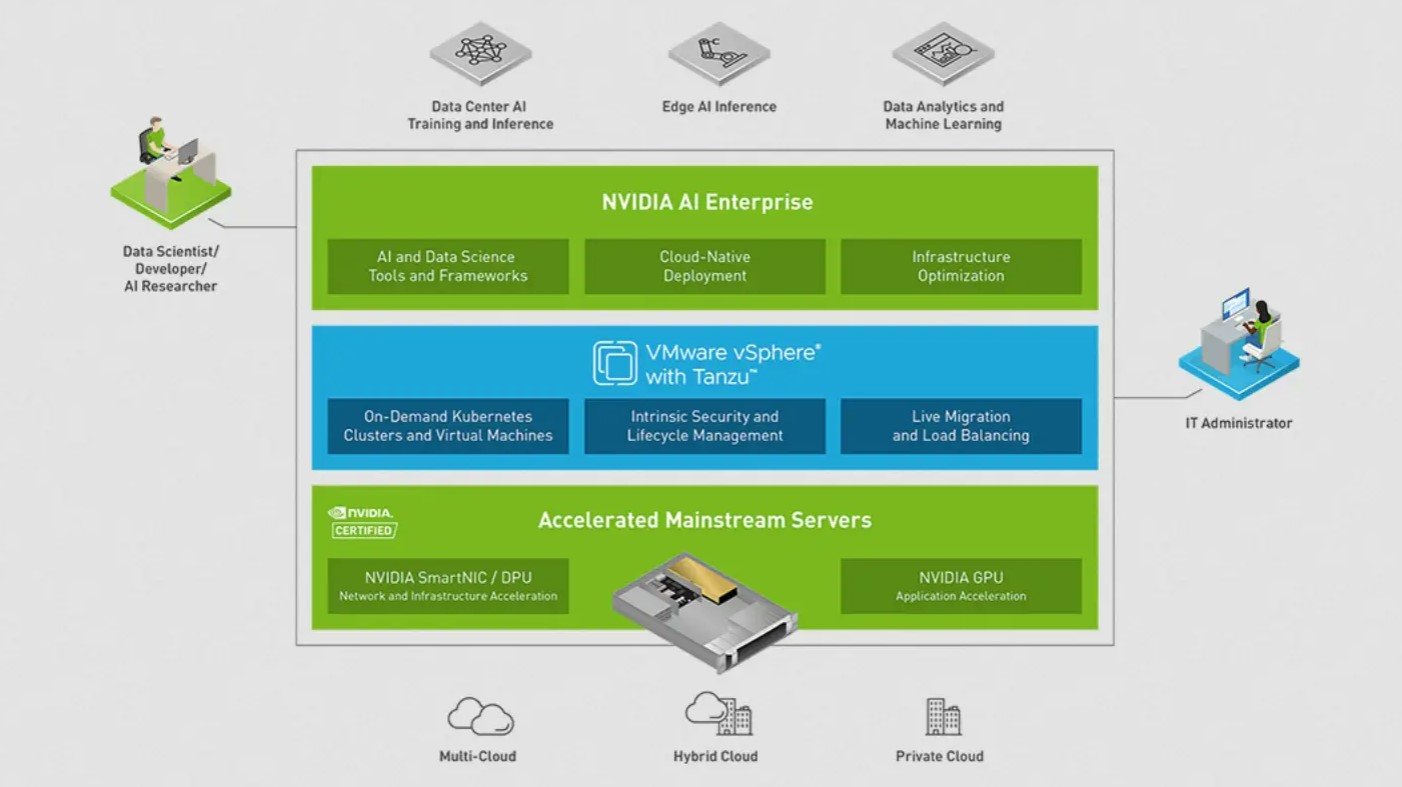

Nvidia AI Enterprise est un ensemble de solutions d'IA complètes. Cela comprend un logiciel pour nettoyer les données, les préparer, effectuer la formation des réseaux de neurones, convertir le modèle en une forme plus efficace pour l'inférence et le déployer sur un serveur d'inférence. De plus, la suite logicielle Nvidia AI comprend un GPU, un DPU (unité de traitement de données), une prise en charge réseau accélérée pour Kubernetes (la couche de déploiement cloud native que l'on retrouve dans le schéma ci-dessous) ainsi que le support des terminaux partagés sur VMware vSphere avec Tanzu. Tanzu Basic permet de l'exécuter et de gérer Kubernetes dans vSphere.

Le programme d'essai LaunchPad de Nvidia propose aux équipes IA et data science d'accéder gratuitement le temps d'un essai à la pile complète AI Enterprise s'exécutant sur une infrastructure de calcul privée. Il facilite aussi l'accès à des experts Nvidia et à des modules de formation. Nvidia AI Enterprise est une tentative de sortir la formation et le déploiement de modèles d'IA du domaine de la recherche universitaire et des plus grandes entreprises technologiques. Si ces dernières ont déjà des datascientists de niveau doctorat et des datacenters remplis de GPU, ce n'est cependant pas le cas d'entreprises ordinaires qui besoin d'appliquer l'IA pour les opérations, le développement de produits, le marketing, les ressources humaines et d'autres domaines. LaunchPad est un moyen gratuit pour ces entreprises de permettre à leurs administrateurs informatiques et praticiens de l'IA d'acquérir une expérience pratique avec la pile AI Enterprise sur du matériel pris en charge. L'alternative la plus courante à Nvidia AI Enterprise et LaunchPad consiste à utiliser les GPU (et d'autres accélérateurs de formation de modèles, tels que les TPU et les FPGA) et les logiciels d'IA disponibles auprès des fournisseurs de cloud hyperscale, combinés aux cours, modèles et laboratoires fournis par le les fournisseurs de cloud et les communautés open source du framework AI.

La pile Nvidia AI Enterprise se compose de plusieurs éléments incluant du hardware pour accélérer le traitement et les tâches jusqu'aux outils et frameworks de data science. (crédit : Nvidia)

Que trouve-t-on dans Nvidia AI Enterprise

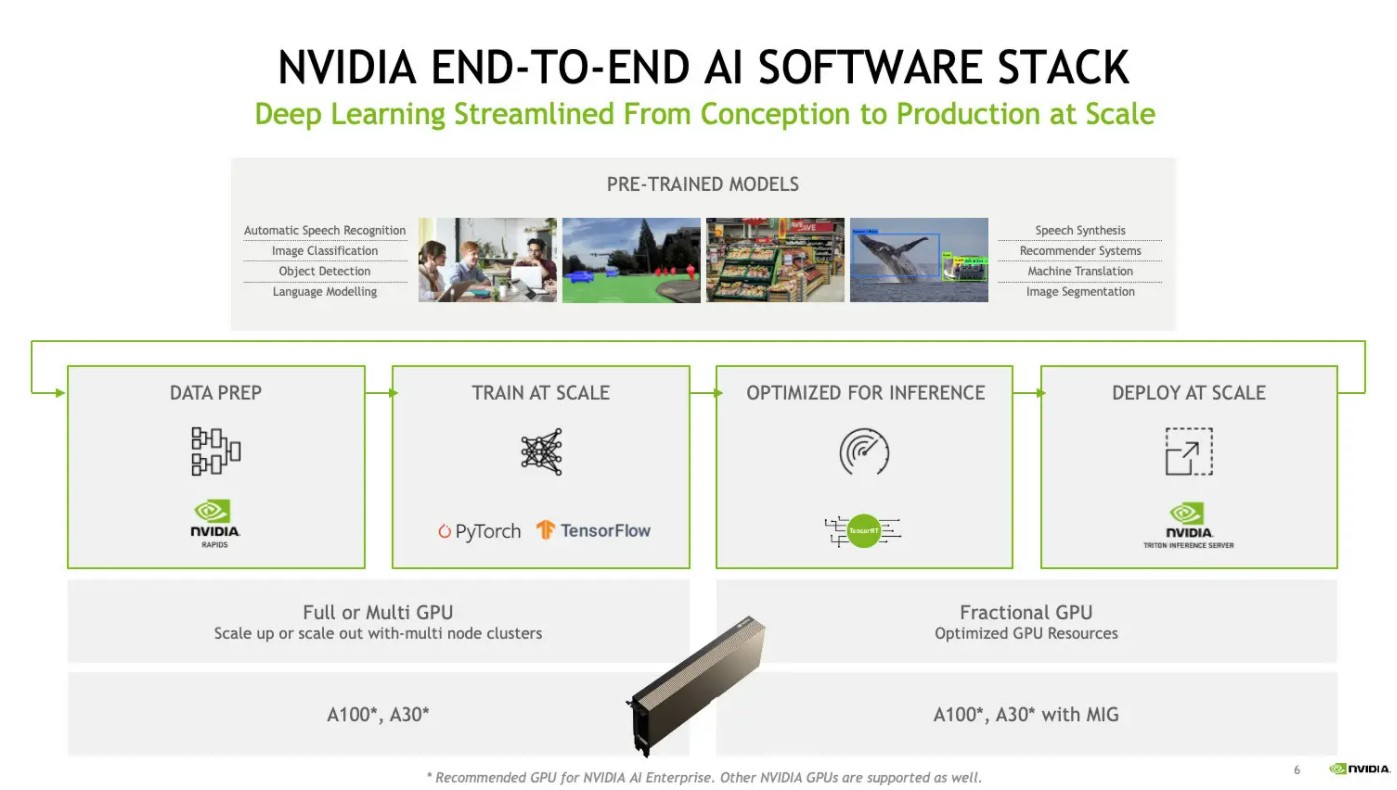

Nvidia AI Enterprise fournit une couche d'infrastructure intégrée pour le développement et le déploiement de solutions d'IA. Il comprend des modèles pré-entraînés, un logiciel compatible GPU pour la préparation des données (RAPIDS), des frameworks d'apprentissage en profondeur compatibles GPU tels que TensorFlow et PyTorch, un logiciel pour convertir les modèles en une forme plus efficace pour l'inférence (TensorRT) et un serveur d'inférence évolutif (Triton).

Une bibliothèque de modèles pré-entraînés est disponible via le catalogue NGC de Nvidia pour une utilisation avec la suite logicielle Nvidia AI Enterprise ; ces modèles peuvent être affinés sur vos ensembles de données à l'aide de ses conteneurs TensorFlow, par exemple. Les frameworks d'apprentissage en profondeur fournis, bien que basés sur leurs versions open source, ont été optimisés pour les GPU Nvidia.

Diagramme de flux de la pile logicielle Nvidia AI i pour la formation et l'inférence. (crédit : Nvidia)

Nvidia AI Enterprise via le programme LaunchPad

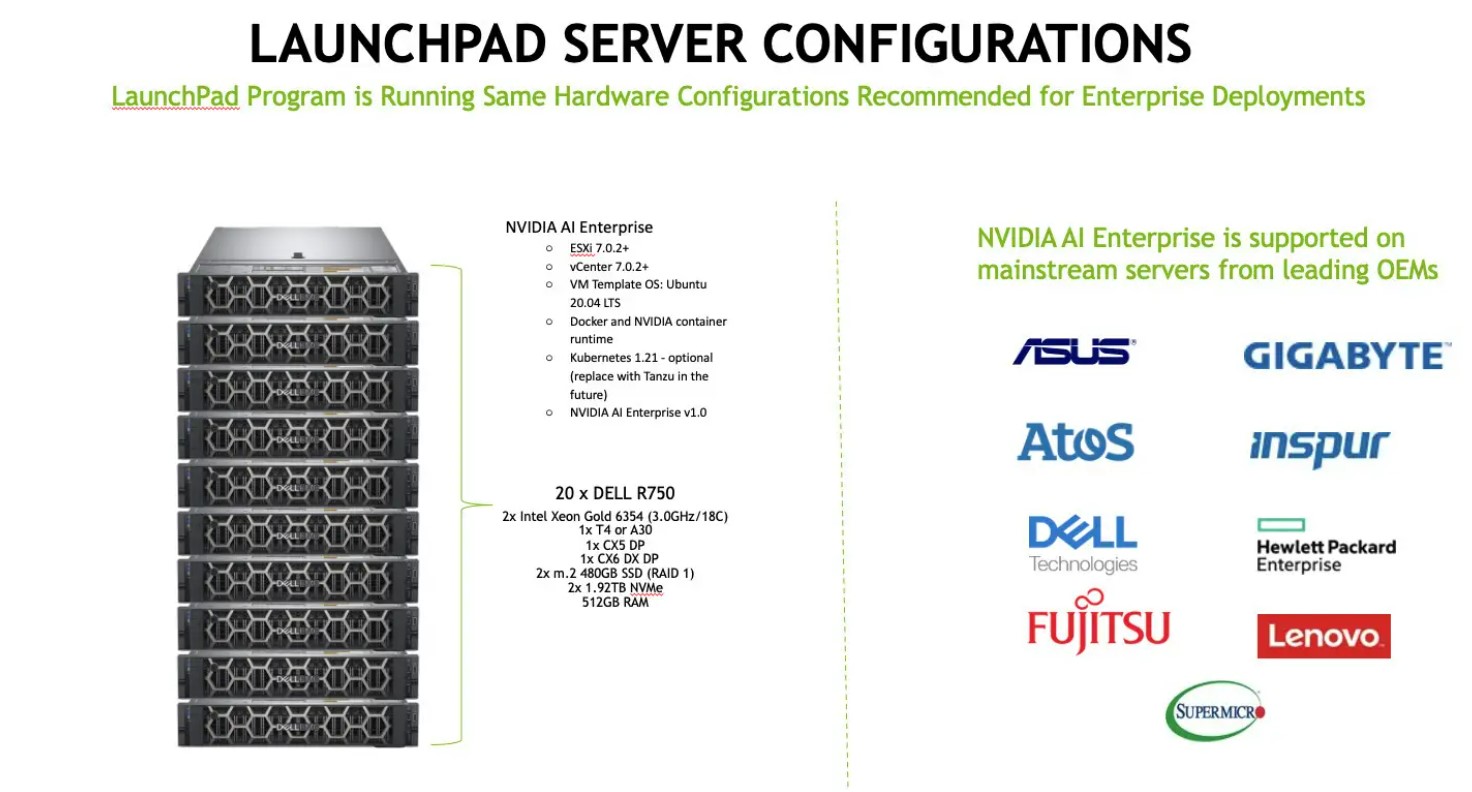

Nvidia a fait beaucoup parler de lui concernant les systèmes DGX, qui disposent de quatre à 16 GPU A100 dans divers facteurs de forme, allant d'une appliance de groupe de travail en tour aux systèmes en rack conçus pour une utilisation dans les datacenters. Alors que la société est toujours attachée à DGX pour les grandes installations, dans le cadre du programme LaunchPad, la société a assemblé des systèmes montés en rack 1U à 2U plus petits avec des serveurs de base basés sur deux processeurs Intel Xeon Gold 6354, un seul GPU Nvidia T4 ou A30, et DPU Nvidia (unités de traitement de données). Neuf régions de colocation Equinix dans le monde disposant chacune de 20 serveurs montés en rack de ce type sont qualifiés par Nvidia dans le cadre de ce programme.

Nvidia recommande les mêmes systèmes pour les déploiements d'entreprise de Nvidia AI Enterprise. Ces systèmes sont disponibles à la location ou à la location en plus de l'achat.

Les serveurs prenant en charge LaunchPad et Nvidia AI Enterprise sont variés pari lesquels les Dell R750 mais ceux d'autres constructeurs peuvent aussi convenir tout à fait. (crédit : Nvidia)

Prise en main de Nvidia AI Enterprise

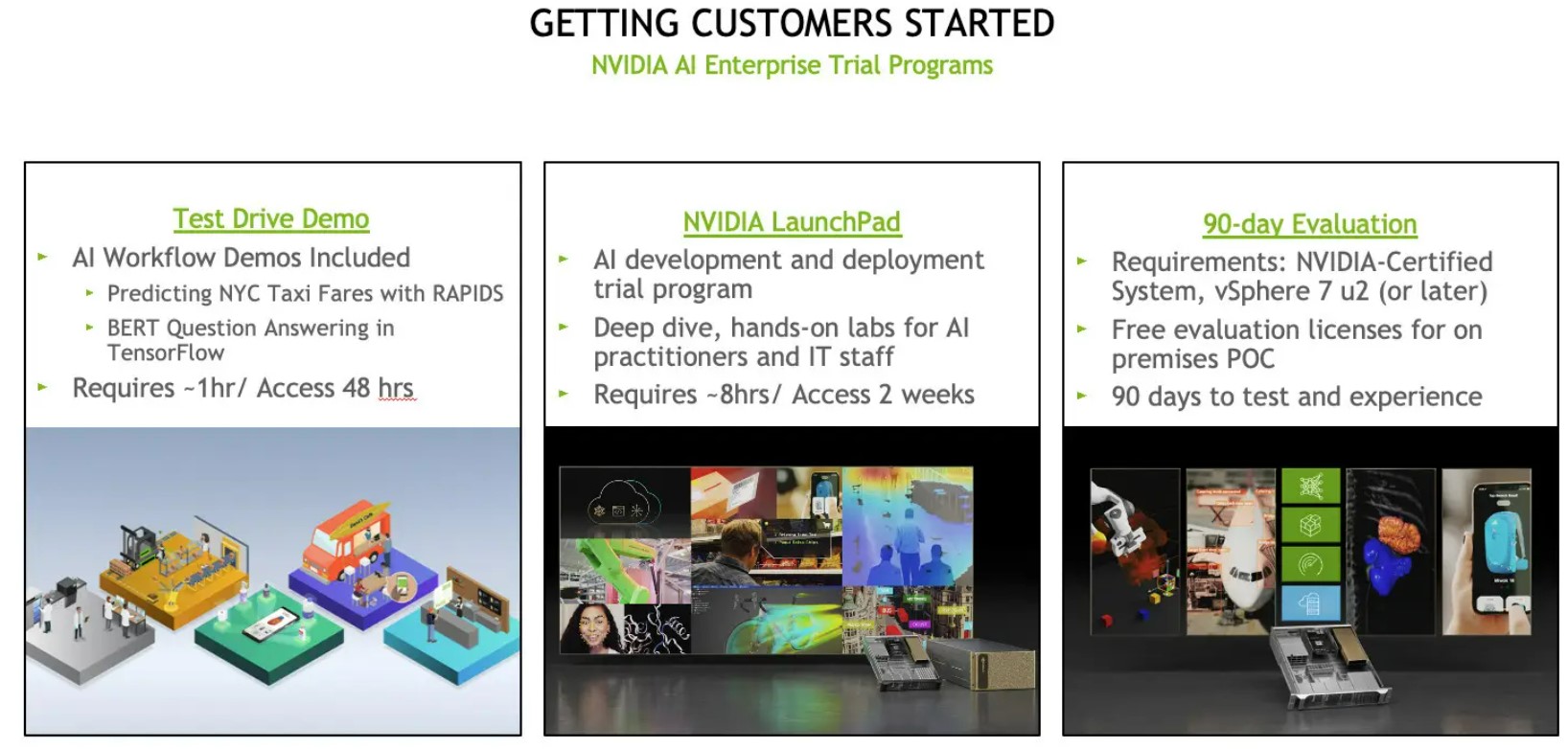

Nvidia propose trois programmes d'essai différents pour aider les clients à démarrer avec Nvidia AI Enterprise. Pour les praticiens de l'IA qui veulent juste se mouiller les pieds, il existe une démo d'essai qui comprend la prédiction des tarifs des taxis à New York et la réponse aux questions BERT dans TensorFlow. Une heure de mise en place est nécessaire pour un accès limité à 48h. L'essai standard nécessite lui 8h de mise en oeuvre. Dans ce mode LaunchPad est légèrement plus étoffé pour accompagner les praticiens de l'IA et le personnel informatique avec un accès aux systèmes pendant deux semaines avec une extension facultative à un mois.

Le troisième programme d'essai est une évaluation sur site de 90 jours, suffisante pour effectuer un PoC. Mais dans ce cas le client doit fournir (ou louer) un système certifié Nvidia avec VMware vSphere 7 u2 (ou version ultérieure), pour bénéficier de licences d'évaluation gratuites.

Il existe trois façons d'essayer Nvidia AI Enterprise dont un essai de 48h qui peut aller à 3 mois avec le programme le plus étendu. (crédit : Nvidia)

Démo de Nvidia LaunchPad pour les administrateurs informatiques

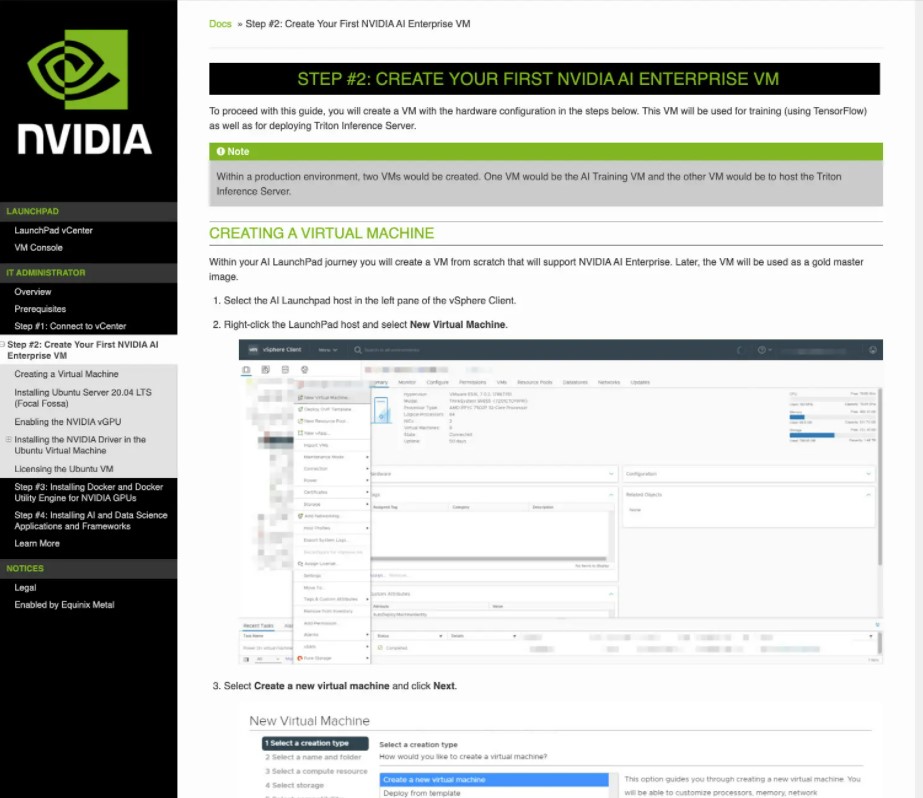

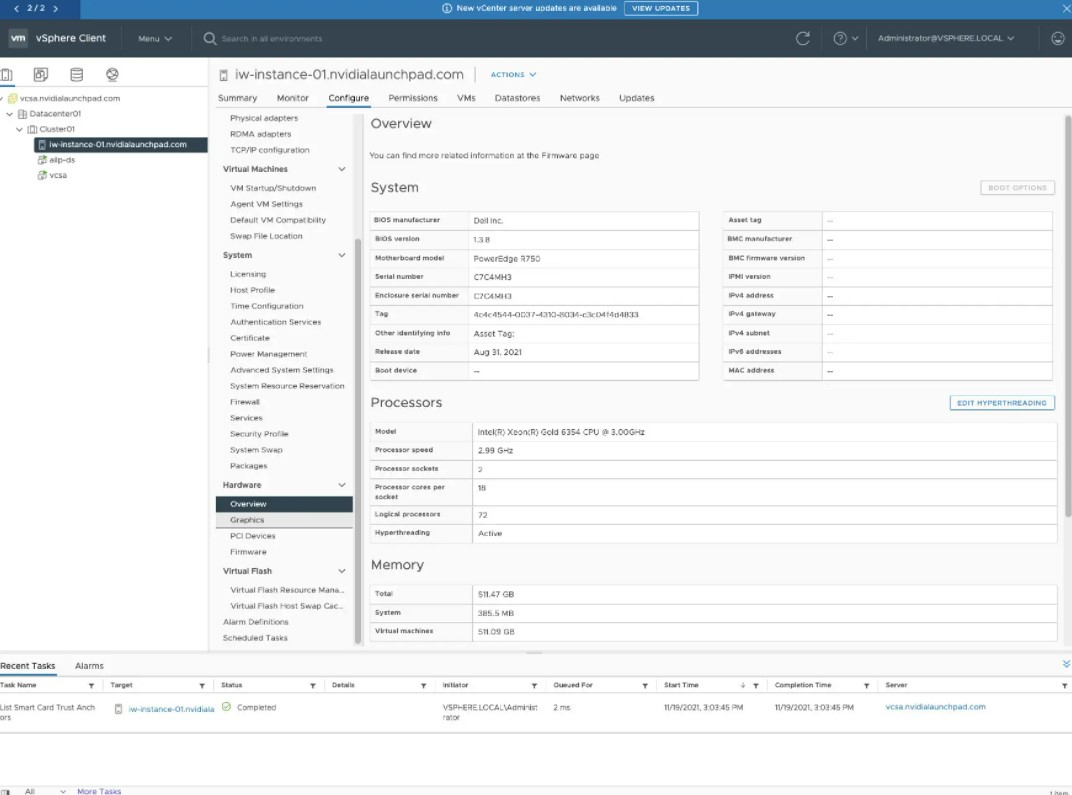

Comme je suis plus intéressé par la datascience que par l'administration informatique, j'ai d'abord simplement regardé une démo du laboratoire d'administration pratique avant ensuite de mettre les mains dedans. La première capture d'écran ci-dessous montre le début des instructions du laboratoire ; la seconde affiche une page de l'interface Web du client VMware vSphere. Selon Nvidia, la plupart des administrateurs informatiques qu'ils forment connaissent déjà vSphere et Windows, mais sont moins familiarisés avec Ubuntu Linux.

Cet écran présente les instructions pour créer une machine virtuelle Nvidia AI Enterprise à l'aide de VMware vSphere. Cela fait partie de la formation d'administrateur informatique. (crédit : Nvidia)

Cet écran affiche la présentation du matériel pour la machine virtuelle Nvidia AI Enterprise créée à des fins de didacticiel dans VMware vSphere. (crédit : Nvidia)

Launchpad pour les praticiens de l'IA

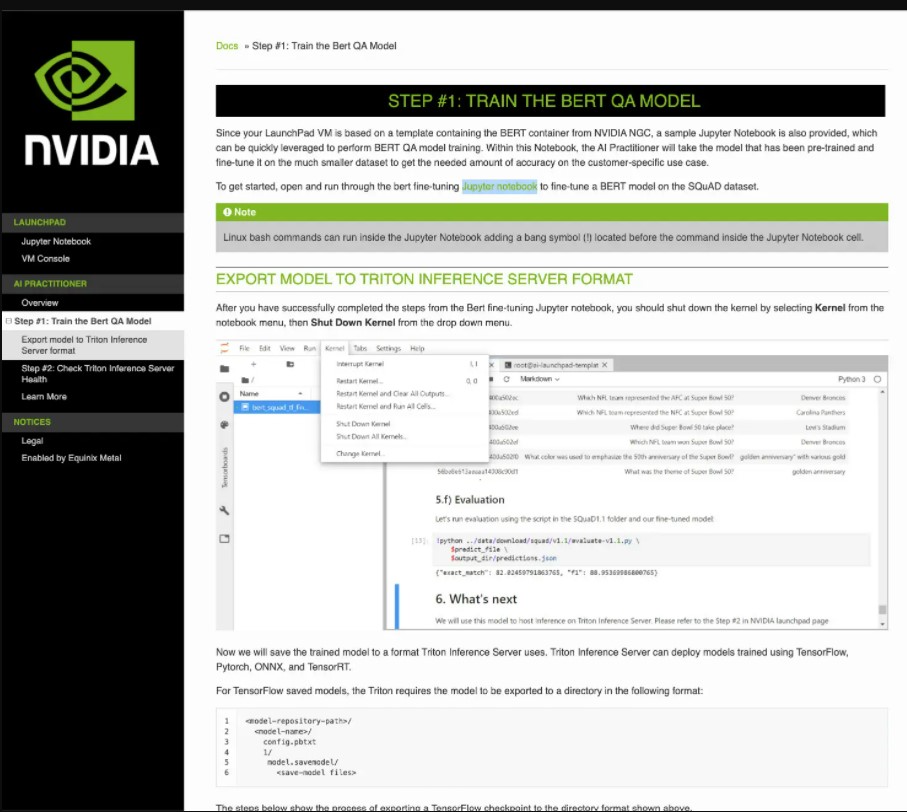

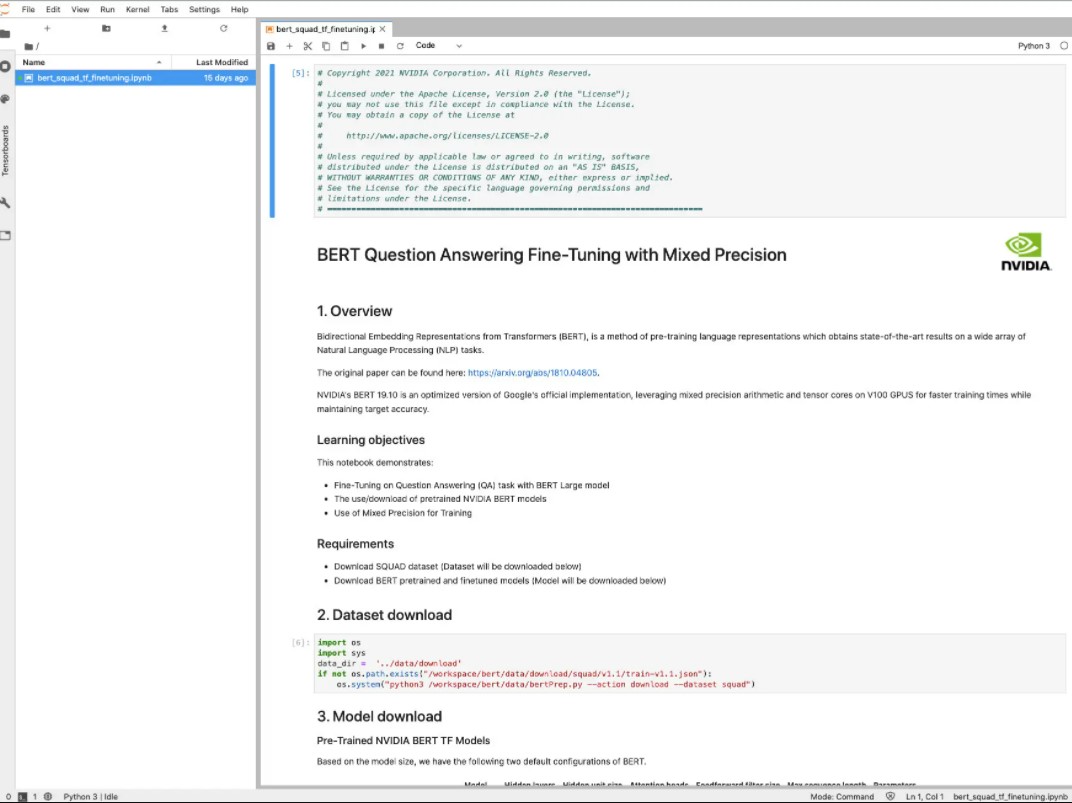

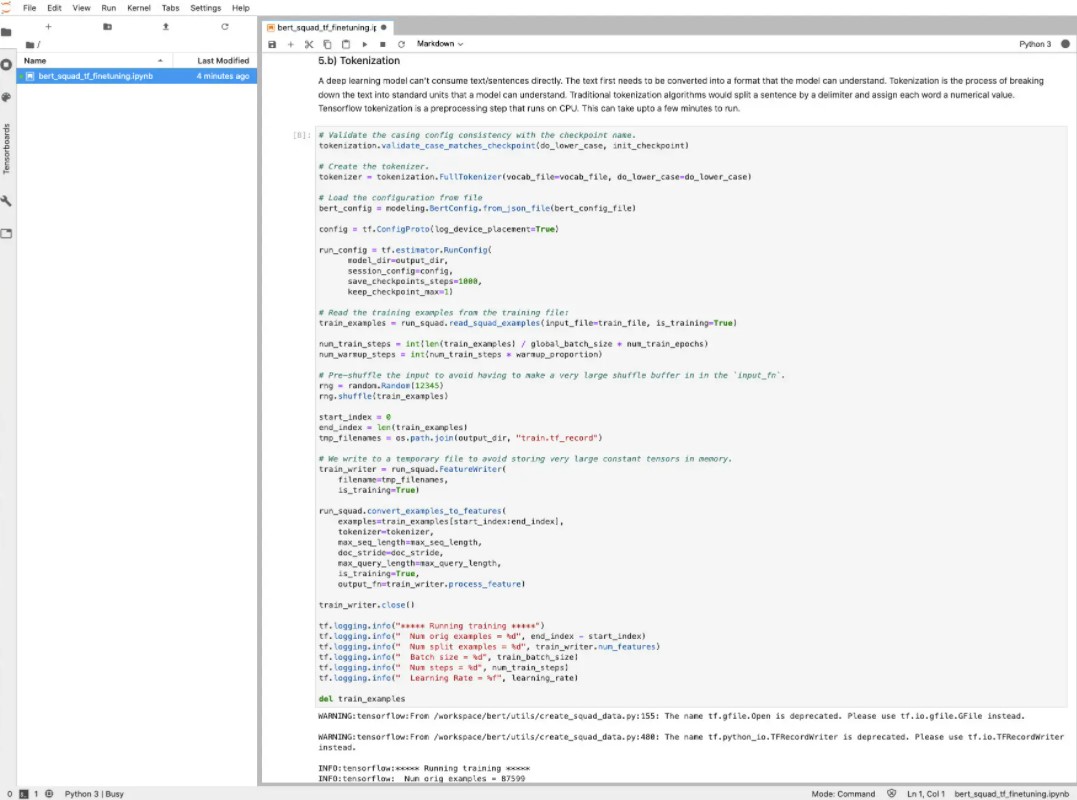

J'ai passé la majeure partie de la journée à parcourir le laboratoire LaunchPad pour les praticiens de l'IA, livré principalement sous forme de bloc-notes Jupyter. Les équipes de Nvidia m'ont dit qu'il s'agissait d'un didacticiel de niveau 400 ; cela aurait certainement été le cas si j'avais dû écrire le code moi-même. Dans l'état actuel des choses, tout le code était déjà écrit, il y avait un modèle BERT de base entraîné à affiner, et toutes les données d'entraînement et de test pour l'ajustement ont été fournies par SQuAD (Stanford Question Answering Dataset).

Le GPU A30 du serveur fourni pour le LaunchPad s'est entraîné lorsque je suis arrivé à l'étape de réglage fin, qui a pris 97 minutes. Sans le GPU, cela aurait pris beaucoup plus de temps. Former le modèle BERT à partir de zéro, par exemple, le contenu de Wikipédia, demande beaucoup d'efforts mobilisant de nombreux GPU sur une longue période (probablement des semaines).

La section supérieure de cette page envoie l'utilisateur vers un bloc-notes Jupyter qui affine un modèle BERT pour le service client. La section inférieure explique comment exporter le modèle entraîné vers le serveur d'inférence. Soit dit en passant, si vous oubliez d'arrêter le noyau après l'étape de réglage fin, l'étape d'exportation échouera avec des traces d'erreur mystérieuses. Ne me demandez pas comment je le sais. (crédit : Nvidia)

C'est le début du Jupyter Notebook qui met en œuvre la première étape du cours AI Practitioner. Il utilise un modèle BERT TensorFlow pré-entraîné, téléchargé à l'étape 3, puis l'affine pour un ensemble de données plus petit et ciblé, téléchargé à l'étape 2. (crédit : Nvidia)

Cette étape utilise TensorFlow pour convertir des exemples de phrases en forme de jeton. Il faut quelques minutes pour s'exécuter sur les processeurs. (crédit : Nvidia)

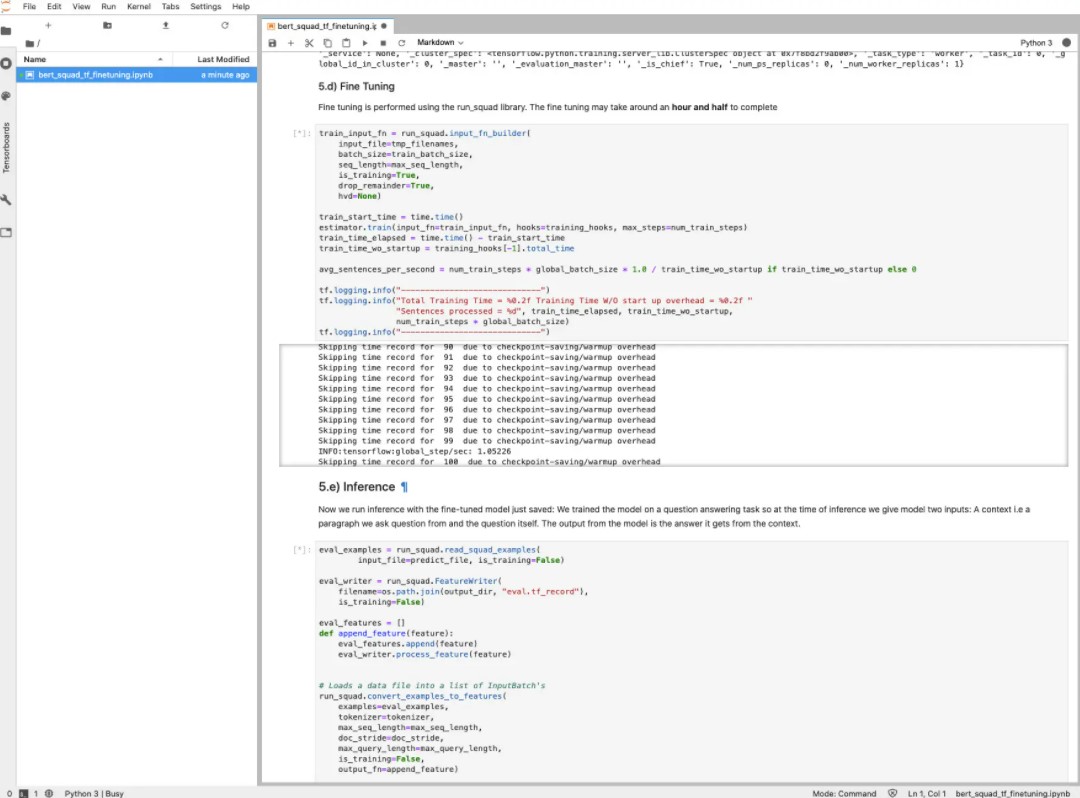

L'étape de réglage fin devrait prendre environ 90 minutes avec le GPU A30. Ici, nous commençons tout juste la formation à l'appel estimateur.train. (crédit : Nvidia)

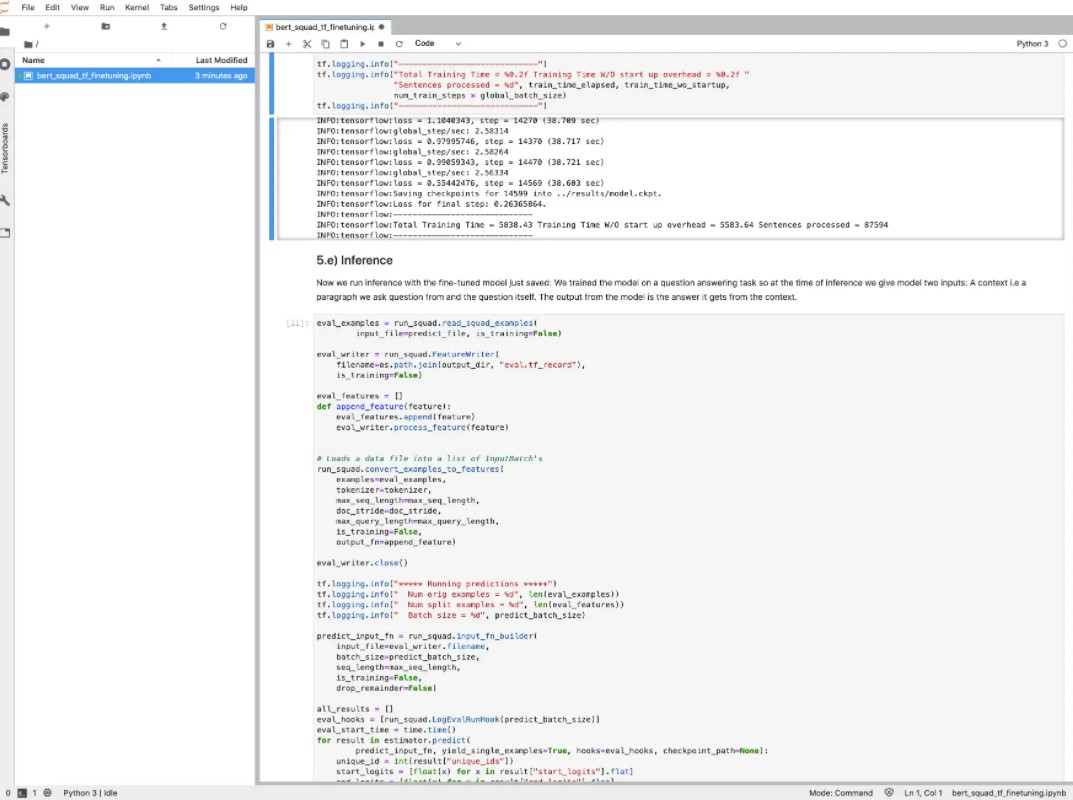

L'étape d'entraînement de réglage fin est enfin terminée, en 5838 secondes (97 minutes) au total. Environ quatre minutes ont été nécessaires pour démarrer. (crédit : Nvidia)

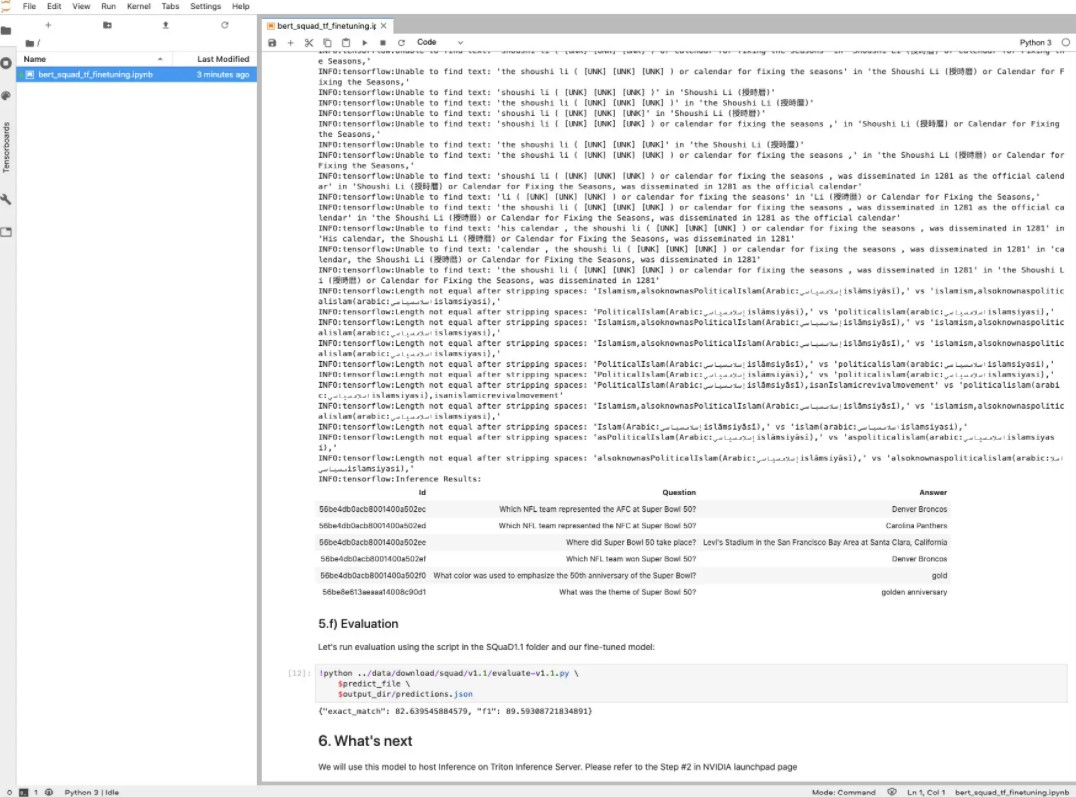

Jupyter Notebook se poursuit avec un test d'inférence et une étape d'évaluation, tous deux utilisant le modèle TensorFlow BERT affiné. Après cette étape, nous arrêtons Jupyter Notebook et démarrons le serveur d'inférence Triton dans la machine virtuelle, puis testons le serveur Triton à partir d'une console Jupyter. (crédit : Nvidia)

Le bilan

Dans l'ensemble, Nvidia AI Enterprise est un très bon package matériel/logiciel pour résoudre les problèmes d'IA, et LaunchPad est un moyen pratique de se familiariser avec Nvidia AI Enterprise. J'ai été frappé par la façon dont le logiciel d'apprentissage en profondeur tire parti des dernières innovations des GPU Ampere, telles que l'arithmétique de précision mixte et les cœurs tenseurs. J'ai remarqué à quel point l'expérience était meilleure en essayant les laboratoires pratiques de Nvidia AI Enterprise sur l'instance de serveur de Nvidia que les autres expériences que j'ai eues en exécutant des exemples TensorFlow et PyTorch sur mon propre matériel et sur des machines virtuelles cloud et des services d'IA.

Tous les principaux clouds publics offrent un accès aux GPU Nvidia, ainsi qu'aux TPU (Google), aux FPGA (Azure) et aux accélérateurs personnalisés tels que les puces Habana Gaudi pour la formation (sur les instances AWS EC2 DL1) et les puces AWS Inferentia pour l'inférence (sur les instances Amazon EC2 Inf1). Vous pouvez même accéder gratuitement aux TPU et aux GPU dans Google Colab. Les fournisseurs de cloud ont également des versions de TensorFlow, PyTorch et d'autres frameworks optimisés pour leurs clouds.

En supposant que vous puissiez accéder à Nvidia LaunchPad pour Nvidia AI Enterprise et le tester avec succès, votre prochaine étape, si vous souhaitez continuer, devrait probablement être de mettre en place une preuve de concept pour une application d'IA qui a une grande valeur pour votre entreprise, avec l'adhésion et le soutien de la direction. Vous pourrez alors louer un petit serveur certifié Nvidia avec un GPU de classe Ampere et profiter de la licence d'évaluation gratuite de 90 jours de Nvidia pour Nvidia AI Enterprise pour accomplir le POC avec un coût et un risque minimum. A vous de jouer !

Commentaire