Comme chaque année, la firme Texane a donné rendez-vous à ses partenaires et clients à Las Vegas pour son Dell Technologies World. Le CEO Michael Dell a lancé cette édition devant un parterre de plus de 7 000 participants en affichant clairement la continuité par rapport à l’édition 2024. Celle-ci avait été marquée par la présentation d’AI Factory combinant infrastructures, écosystème et services pour aider les entreprises à développer leurs stratégies IA. Un pari gagnant selon le dirigeant avec « plus de 3 000 entreprises de différents secteurs » converties (Loewe’s, Sandisk, Continental, JPMorganChase,…).

Une ouverture des serveurs IA vers AMD et Intel

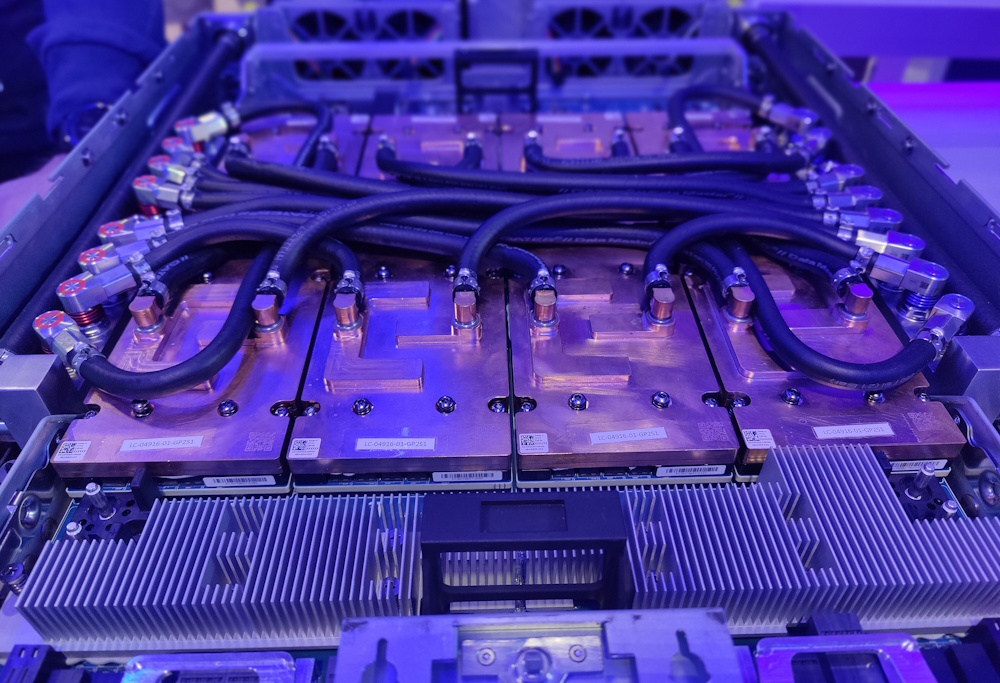

Mais comme l’explique Michael Dell, « aujourd’hui près de 80% des cas d’usages en IA fonctionnent sur site ». Une tendance que le constructeur accompagne en étoffant ses AI Factory sur le volet infrastructure. Ainsi, Dell ouvre ses serveurs PowerEdge à d’autres accélérateurs que ceux de Nvidia avec la possibilité pour les clients de choisir les GPU AMD Instinct MI350 ou Intel Gaudi 3. Il propose donc deux serveurs PowerEdge XE 9785 (refroidissement par air) et XE 9785 L (refroidissement liquide). Pour la partie logicielle, Dell a travaillé pour l’intégration de ROCm d’AMD comprenant des outils et des API pour le développement d’application IA ou l’environnement SYCL d’Intel. Ils seront disponibles au seconde semestre 2025.

Le serveur PowerEdge XE 9785 L accueille les accélérateurs MI350 d'AMD avec du refroidissement liquide. (Crédit Photo: JC)

« Par rapport à Nvidia, ces autres environnements sont complémentaires. Chacun a des avantages et des inconvénients. Si vous allez dans le détail sur la gestion de la mémoire, le niveau de performance, il y a des différences. Dans le domaine des mathématiques, en fonction des données, les courbes de performances peuvent être différentes », nous explique John Roese, CTO de Dell Technologies. Sur le choix du type de refroidissement, il observe « dans le monde de l’entreprise, nous voyons une demande pour les serveurs IA avec des refroidissement par air pour des cas d’usage réclamant 5 à 10 GPU. Mais la plus grosse part du marché aujourd’hui reste sur des gros clusters comprenant des milliers de GPU et là, le refroidissement liquide est incontournable ».

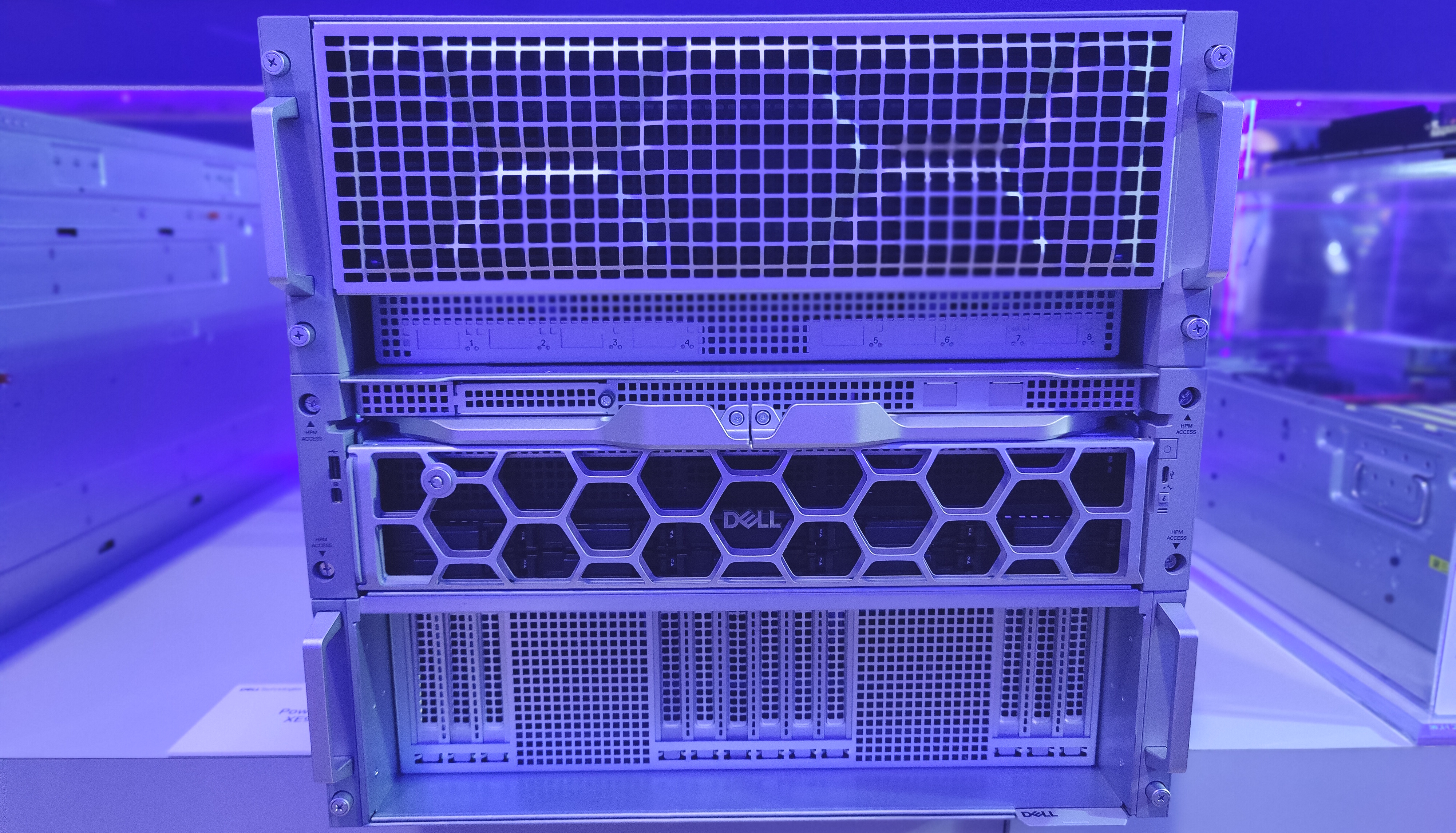

Un renforcement du partenariat avec Nvidia

Si l’ouverture est de mise, Dell parie néanmoins sur l’acteur dominant sur le marché : Nvidia. Les liens se renforcent donc entre les deux sociétés avec l’intégration des récentes annonces de Nvidia à la GTC. Côté serveurs, on retrouve les PowerEdge XE 9785 plus la déclinaison XE 9780 avec des versions air cooling (pour le marché entreprise) ou liquid cooling (pour les fournisseurs de cloud). Ils peuvent embarquer jusqu’à 192 GPU Nvidia Blackwell Ultra. Pour mémoire, l’accélérateur combine deux GPU de la taille d'un réticule, fabriqué en 3 nm chez TSMC, intègre 208 milliards de transistors avec 288 Go de mémoire HBM3e, accompagnée d'une bande passante NVLink de 130 To/s et une connectivité réseau de 14,4 To/s. Interrogé sur la demande de tels serveurs avec du refroidissement par air, Armando Acosta, product planner chez Dell Technologies explique, « pour certaines entreprises, il n’est pas possible d’aller sur refroidissement liquide au sein de leur datacenter, nous avons donc conçu des châssis 10U où vous pouvez embarquer 8 GPU B300 et du refroidissement par air ».

Le PowerEdge XE 9785 est capable d'accueillir des accélérateurs B300 de Nvidia avec du refroidissement par air. (Crédit Photo: JC)

Pour la version en rack GB300 NVL72 (comprenant 36 puces Grace sur base Arm et 72 GPU Blackwell Ultra), Dell dévoile le serveur PowerEdge XE 9712 pouvant comprendre jusqu’à 8 modules HBM4 offrant une capacité mémoire totale de 192 Go, avec une bande passante mémoire dépassant 6 To/s. Le système sera disponible à partir de juillet 2025. Pour l’inférence, Dell propose le PowerEdge XE 7745 qui embarque 8 GPU RTX Pro 6000 Blackwell (96 Go de GDDR7) dans un format 4U. Disponible en juillet prochain, il s’adresse à différentes tâches d’IA comme les modèles de raisonnement, le développement d’agents IA, … Le fournisseur Texan n’oublie pas le réseau avec les commutateurs PowerSwitch SN 5600 et SN 2201 compatibles avec la plateforme Spectrum-X Ethernet de Nvidia. Ces switchs offrent un débit allant jusqu'à 800 Gbt/s. Côté stockage, Dell se focalise sur ObjectScale en le rapprochant des DPU Bluefield-3 et Spectrum, il annonce par ailleurs le support du protocole S3 over RDMA (Remote Direct Memory Access). Concurrent du GPU Direct de Nvidia, il améliore les performances de traitement en déchargeant les CPU des serveurs et en s’appuyant sur les échanges (avec des réseaux de 400 à 800G) plus rapides entre la mémoire et les GPU.

Une porte arrière d'échangeur de chaleur et une station de travail avec un NPU Qualcomm

Pour être complet sur la partie infrastructure, Dell lance un équipement spécifique pour les racks au sein des datacenters. eRDHx est un échangeur de chaleur à porte arrière fermée. Il offre jusqu'à 80 kW de capacité de refroidissement de l'air par rack et jusqu'à 60 % de réduction du coût de l'énergie de refroidissement. Pour John Roes, « ce système s’adresse aux entreprises qui souhaitent installer des équipements à refroidissement liquide de manière incrémentale. Il n’est pas nécessaire pour elles de revoir l’ensemble de leur architecture ». A noter que cette porte est compatible avec le rack IR 7000, un design OCP (open compute project) pour les serveurs GPU Blackwell de Nvidia.

La porte arrière Erdhx promet des gains d'économie d'énergie importants selon Dell. (Crédit Photo: Dell)

Enfin, Michael Dell veut apporter « l’IA partout », y compris dans le domaine des PC et des stations de travail, activité historique de la firme. Elle dévoile donc une station de travail nomade Pro Max Plus (nouvelle appellation après la refonte des noms de la marque) équipée pour la première fois d’un NPU AI 100 de Qualcomm. Le PC portable, dont la disponibilité est prévue plus tard cette année embarque un processeur Arrow Lake HX, jusqu’à 256 Go de RAM et 16 To de stockage. « Ce système s’adresse plutôt aux développeurs qui souhaitent exécuter localement des LLM », précise le dirigeant sur scène. Il donne une capacité de gérer des modèles de plus de 100 milliards paramètres, « comme le récent Llama 4 ».

La station de travail Pro Max Plus embarque un NPU Qualcomm. (Crédit Photo : Dell)

Commentaire