Plus de 500 To de données, soit l'équivalent du contenu de 20 000 disques Blu-ray simple-couche, transitent chaque jour par les serveurs de Facebook. Jay Parikh, vice-président en charge de l'infrastructure, a présenté à la presse jeudi quelques statistiques éloquentes sur la notion de Big Data selon le réseau social.

Chaque jour, 2,5 milliards de contenus sont échangés, 2,7 milliards de boutons « J'aime » sont cliqués et 300 millions de photos sont chargées, 70 000 requêtes demandées. En conséquence, les serveurs du réseau social doivent analyser en moyenne toutes les demi-heures l'équivalent de 105 To de données avec la solution Hive. Enfin pour le stockage, Facebook dispose d'un cluster HDFS de 100 Po.

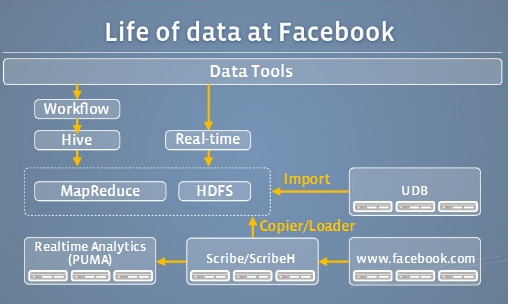

Le traitement de la donnée par Facebook

On comprend mieux alors la volonté du réseau social de s'intéresser à la construction de son propre matériel en matière de serveurs, de châssis, mais aussi de logiciels de gestion et de développement, pour optimiser ses datacenters et in fine le traitement d'un tel volume de données.

Facebook supporte 500 To de nouvelles données par jour

0

Réaction

Le responsable infrastructure du réseau social a donné quelques chiffres sur le volume de données traitées quotidiennement.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Suivre toute l'actualité

Newsletter

Recevez notre newsletter comme plus de 50 000 professionnels de l'IT!

Je m'abonne

Commentaire