L’IA était au cœur de la conférence .Next de Google et ce sujet a infusé les différentes annonces de la société. Même l’environnement Google Distributed Cloud (GDC) a évolué en conséquence. Pour rappel, cette offre s'adresse essentiellement aux clients qui ont des besoins spécifiques en matière de souveraineté des données, de latence ou de traitement local des données. Commercialisée en mars 2023, « elle comprend le matériel, les logiciels, le plan de contrôle local et les outils nécessaires pour déployer, exploiter, mettre à l'échelle et sécuriser un cloud géré complet », expliquait alors la firme.

Recherche à base d’IA et sandbox

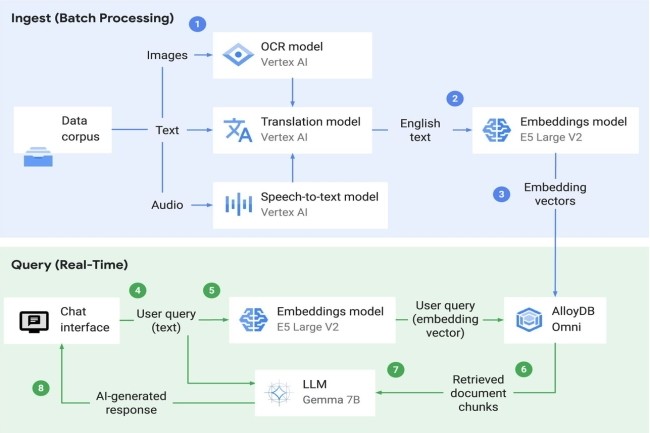

Lors de l’évènement, Google Cloud a présenté plusieurs fonctionnalités au sein de GDC dont une fonction de recherche alimentée par l’IA pour récupérer et analyser des données sur site ou en edge. Sous le capot, la recherche IA utilise le modèle Gemma 7B, Vertex AI pour le service LLM, et une API pré-entraînée (speech-to-text, traduction et reconnaissance optique de caractères) pour l'ingestion de données. « Elle prend également en charge l'extension AlloyDB Omni pgvector pour les entreprises qui déploient une base de données vectorielle au sein de GDC », a indiqué le fournisseur. La recherche IA sera disponible en avant-première au cours du deuxième trimestre de cette année.

Parmi les autres mises à jour de Distributed Cloud, on peut citer un environnement sandbox. « Le bac à sable ajouté à Google Distributed Cloud offre une expérience managée qui peut aider les développeurs d'applications à créer et à tester des services conçus pour GDC dans un environnement Google Cloud, sans avoir à naviguer dans l’isolation (air gap) et le matériel physique », a expliqué le fournisseur, ajoutant que les développeurs pouvaient utiliser les services GDC, y compris les machines virtuelles, les conteneurs, les bases de données et Vertex AI. Google a également rendu le stockage de Distributed Cloud plus flexible, de sorte que les entreprises pourront augmenter leur stockage indépendamment du calcul. « Elles pourront ainsi mieux supporter les grosses charges de travail analytiques et d'IA », a déclaré l’entreprise, en précisant qu’il y avait aussi des options pour le stockage de blocs, de fichiers et d'objets.

Une infrastructure orientée IA et intégration d'Apigee

Par ailleurs, Distributed Cloud aura désormais accès à des racks spécialement optimisés pour l'IA et les charges de travail de calcul général. « Ces infrastructures offrent plus de flexibilité dans le choix de nœuds optimisés pour le réseau ou le stockage dans le cadre d'un déploiement », a indiqué le fournisseur. De plus, grâce au partenariat entre Google et Nvidia, les entreprises pourront accéder à un nouveau serveur pour Google Distributed Cloud équipé d’un accélérateur GPU Nvidia L4 Tensor Core économe en énergie. « Il est possible de déployer un seul serveur en tant qu'appliance autonome pour les cas d’usage où la haute disponibilité n'est pas nécessaire. Cette offre vient s'ajouter à nos serveurs optimisés pour l'IA avec des GPU Nvidia H100 Tensor Core pour accélérer l’innovation en matière d'IA sur site », a précisé l'entreprise dans un communiqué.

Pour ce qui est de la capacité de résilience, les améliorations concernent le mode déconnecté avec un support de 7 jours, une suite de fonctionnalités de gestion hors ligne pour aider à assurer que les déploiements, les charges de travail sont accessibles en état de fonctionnement pendant qu'ils sont déconnectés. Enfin, Google prendra en charge Apigee, son offre de gestion des API, sur Distributed Cloud.

Commentaire