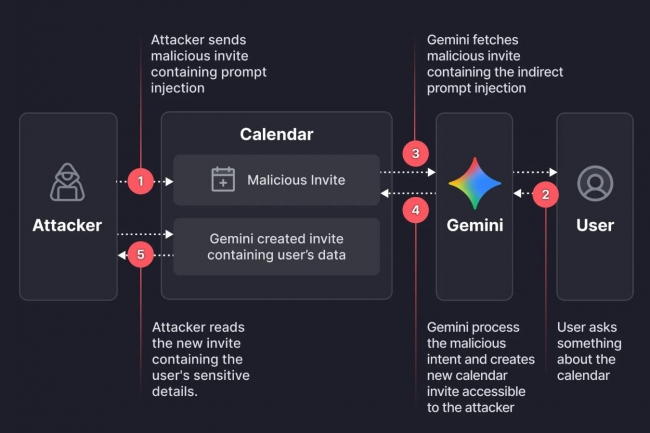

Une faille a été découverte dans l'assistant IA de Google, Gemini, montrant comment des pirates pourraient exploiter des invitations de calendrier courantes pour accéder à des informations privées de réunion. Cette situation souligne que les risques encourus par les entreprises intégrant la GenAI dans leurs processus quotidiens de productivité et de prise de décision sont loin d'être nuls. Cette vulnérabilité a été identifiée par la société spécialisée dans la protection des applications, Miggo. Dans son rapport, Liad Eliyahu, son responsable de la recherche, explique que Gemini analyse l'intégralité du contexte des événements de l'agenda d'un utilisateur, y compris les titres, les heures, les participants et les descriptions des réunions, pour répondre à des questions telles que le programme de la journée. « Le mécanisme de cette attaque exploite cette intégration », explique M. Eliyahu. « Comme Gemini ingère et interprète automatiquement les données des événements pour les rendre utiles, un attaquant capable d'influencer les champs des événements peut y insérer des instructions en langage naturel que le modèle pourra ensuite exécuter. »

Les chercheurs de Miggo ont déclaré que cette découverte mettait en évidence un problème de sécurité plus large auquel sont confrontés les systèmes reposant sur des LLM, où les attaques se concentrent sur la manipulation du sens et du contexte plutôt que sur l'exploitation de codes malveillants clairement identifiables. « Cette vulnérabilité de Gemini n'est pas un cas isolé », a déclaré M. Eliyahu. « Il s'agit plutôt d'une étude de cas illustrant la difficulté de la détection à suivre le rythme des menaces natives de l'IA. Les hypothèses traditionnelles en matière de sécurité des applications (notamment les modèles reconnaissables et la logique déterministe) ne s'appliquent pas clairement aux systèmes qui raisonnent en termes de langage et d'intention. »

Plus grave qu'une attaque traditionnelle

Le problème est important non pas parce qu'il reflète une faille logicielle classique, mais parce qu'il démontre comment les systèmes IA peuvent être manipulés de manière similaire aux attaques par ingénierie sociale. « Traditionnellement, une invitation de calendrier, un courriel ou un document sont traités uniquement comme des données », explique Sunil Varkey, analyste indépendant en cybersécurité. « L'attaquant doit briser la logique du code ou la sécurité de la mémoire pour que le système fasse quelque chose, plutôt que de se fier uniquement aux données. » Mais dans ce cas, le « bug » tient moins à un code défectueux qu'à la manière dont un LLM interprète le langage dans son contexte, combinée aux autorisations dont il dispose dans les applications connectées, explique Sakshi Grover, directeur de recherche senior chez IDC Asia Pacific Cybersecurity Services. « Cette combinaison transforme un objet métier normal, une invitation de calendrier, en une charge utile d'attaque », explique M. Grover. « Cela révèle que la sécurité des IA chez les principaux fournisseurs est encore en retard par rapport aux modèles de menaces réels des entreprises, en particulier en ce qui concerne l'injection indirecte de prompts, l'utilisation d'outils et le traitement des données entre applications. »

Keith Prabhu, fondateur et CEO de Confidis, a déclaré que bien que cette attaque soit exécutée via Google Gemini, elle s'apparente davantage à une technique de type hameçonnage. « Une fois que l'invitation malveillante est acceptée par l'utilisateur, Gemini la considère comme acceptée et fiable et l'exécute », a déclaré M. Prabhu. « Alors que le reste du monde IT s'oriente vers le zero trust, les outils IA continuent de faire implicitement confiance aux composants des ordinateurs de bureau. Cela peut constituer une faille grave, car les outils IA peuvent être détournés pour agir comme un concierge et effectuer des tâches que les malwares ne peuvent pas réaliser directement. »

Un risque pour les entreprises

Les analystes soulignent que le risque est important dans les environnements d'entreprise, car les organisations déploient rapidement des assistants IA connectés à des systèmes sensibles. « Lorsque les copilotes internes ingèrent des données provenant de courriels, de calendriers, de documents et d'outils collaboratifs, un seul compte compromis ou un seul message de phishing peut discrètement intégrer des instructions malveillantes », a déclaré Chandrasekhar Bilugu, directeur technique de SureShield. « Lorsque les employés effectuent des requêtes de routine, le modèle peut traiter ce contexte manipulé et divulguer involontairement des informations sensibles. » Mme Grover a déclaré que les menaces d'injection de prompt sont passées du stade théorique au stade opérationnel. « Dans l'étude IDC Asie/Pacifique menée en août 2025, les entreprises indiennes ont cité l'injection de prompt, la manipulation de modèles ou le jailbreaking des assistants IA comme la deuxième menace liée à l'IA la plus préoccupante, juste après l'empoisonnement des modèles ou des entrées frauduleuses pendant la formation de l'IA, a-t-elle ajouté.

Des mesures à prioriser

Keith Prabhu a déclaré que les responsables de la sécurité doivent inclure la sensibilisation à la sécurité de l'IA dans leur formation annuelle sur la cybersécurité destinée à l'ensemble du personnel. Les terminaux devront également être renforcés, en tenant compte des menaces liées à ce nouveau vecteur d'attaque. M. Grover a aussi expliqué que cela nécessite d'appliquer le principe du moindre privilège aux systèmes IA, de limiter strictement les autorisations des outils, de restreindre l'accès aux données par défaut et de valider chaque action initiée par l'IA par rapport aux règles business et aux politiques de confidentialité. « L'objectif n'est pas de rendre le modèle immunisé contre le langage, car aucun modèle ne l'est, mais de garantir que même s'il est manipulé, il ne puisse pas accéder discrètement à plus de données qu'il ne le devrait ou exfiltrer des informations par des canaux secondaires », a ajouté Mme Grover.

De son côté, Sunil Varkey a fait savoir que les responsables de la sécurité devraient également repenser la manière dont ils positionnent les assistants IA dans leurs environnements, mettant en garde contre le fait de les traiter comme de simples outils de recherche. « Appliquez les principes du zero trust avec des garde-fous solides : limitez l'accès aux données au principe du moindre privilège, veillez à ce que les contenus non fiables ne puissent pas devenir des instructions fiables et exigez des autorisations pour les actions à haut risque telles que le partage, l'envoi ou la réécriture dans les systèmes d'entreprise », a-t-il ajouté.

Commentaire