Dominée par l'annonce de l'architecture GPU Blackwell et des systèmes DGX massifs qui en sont issus, la GTC 2024 de Nvidia, organisée du 18 au 21 mars à San José, a donné lieu à de nombreux autres lancements produits autour du HPC et de l'IA.

Des plateformes réseau à grande vitesse

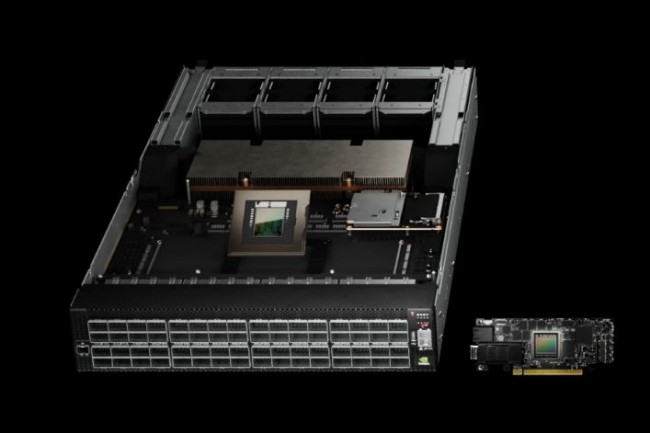

Même si elle est moins focalisée sur l'aspect réseau, Nvidia est aussi une entreprise de réseaux depuis le rachat de Mellanox. Le fournisseur de Santa Clara a en effet annoncé deux plateformes réseau à grande vitesse avec des débits allant jusqu'à 800 Go/s, destinées aux systèmes HPC. La première plateforme dénommée Quantum-X800 InfiniBand se compose de deux éléments : le commutateur Quantum 3400 et le SuperNIC ConnectX-8. Elle offre une capacité de bande passante cinq fois supérieure et une capacité de calcul en réseau neuf fois supérieure à celle de la génération précédente, soit un débit de 14,4 téraflops. La deuxième plateforme appelée Spectrum-X800 Ethernet, utilise le commutateur Spectrum SN5600 800 Gbps et le SuperNIC Nvidia BlueField-3. Elle est conçue pour les clouds d'IA générative multi-locataires et les grandes entreprises. Les fournisseurs de services cloud, notamment Microsoft Azure, Oracle Cloud Infrastructure et Coreweave, font la queue pour se doter des systèmes Quantum InfiniBand et Spectrum-X Ethernet.

Des microservices pour l’inférence

Jusqu’ici, les microservices n'avaient pas été associés à l'IA parce que ces petits programmes légers sont conçus pour exécuter une seule ou quelques fonctions. Et ils sont gourmands en ressources informatiques, ce qui est l'antithèse de l'IA. Mais Nvidia a introduit des microservices pour l'inférence sur les grands modèles de langage (LLM). Baptisé Nvidia Inference Microservices (NIM), le logiciel fait partie de la suite Enterprise AI de Nvidia. Il se compose d'un ensemble de moteurs d'inférence optimisés, d'API standards et d'un support pour les modèles d'IA, tous regroupés dans des conteneurs pour un déploiement facile. NIM fournit des modèles préconstruits et permet aux entreprises d'ajouter leurs propres données et modèles. Une chose que l'on peut dire à propos de cette technologie NIM, c'est que Nvidia n'a pas travaillé dans le vide. L'entreprise a collaboré avec de nombreux éditeurs de logiciels, dont SAP, Adobe, Cadence, CrowdStrike et ServiceNow, ainsi qu'avec des fournisseurs de plateformes de données, dont Box, Cohesity, Cloudera, Databricks, Datastax et NetApp. NIM offre un traitement d'inférence sur de nombreux modèles d'IA populaires de Google, Meta, Hugging Face, Microsoft, Mistral AI et Stability AI. Les microservices NIM seront disponibles à partir d'Amazon Web Services, de Google Kubernetes Engine et de Microsoft Azure AI.

Vers une validation du stockage HPC

Le stockage est un élément clef du traitement de l'IA, car cette dernière n'est rien sans de grandes quantités de données. C'est la raison pour laquelle Nvidia a lancé un programme de validation des partenaires de stockage destiné à aider les entreprises à trouver les bonnes solutions de stockage en offrant une certification pour les charges de travail à forte intensité graphique et d'IA. Le programme s'appelle OVX, un nom similaire à celui des serveurs de calcul DGX. Le premier groupe d'entreprises qui cherchent à obtenir la validation du stockage OVX est composé de DDN, Dell PowerScale, NetApp, Pure Storage et Weka. Les serveurs OVX associent le calcul accéléré par GPU à un accès au stockage à grande vitesse et à un réseau à faible latence pour répondre à une série de charges de travail complexes d'IA et de graphisme intensif. Le programme fournit un processus standardisé permettant aux partenaires de valider leurs appliances de stockage.

Ruée des fournisseurs de serveurs sur Blackwell

Tous les principaux fournisseurs ont annoncé des serveurs basées sur Blackwell. Dell Technologies a annoncé que les PowerEdge XE9680, son modèle phare à huit voies accéléré par GPU pour l'entraînement à la GenAI, la personnalisation des modèles et l'inférence de l'IA à grande échelle, seront mis à jour avec les accélérateurs Blackwell. Lenovo a annoncé des serveurs IA à 8 GPU - les systèmes ThinkSystem SR680a V3, SR685a V3 et SR780a V3 GPU - basés sur Blackwell pour la prise en charge de l'IA, le calcul à haute performance (HPC) et les charges de travail graphiques et de simulation dans divers secteurs d'activité.

HPE a signalé que les supercalculateurs annoncés en novembre dernier lors de la conférence SC23, (International Conference for High Performance Computing, Networking, Storage, and Analysis) sont désormais disponibles à la commande pour les entreprises à la recherche d'une solution complète préconfigurée et pré-testée pour le développement et l'entraînement de grands modèles d'IA. Ces serveurs HPC sont des solutions clés en main spécialement conçues pour aider les clients à accélérer les projets de GenAI et d'apprentissage profond, et peuvent prendre en charge jusqu'à 168 GH200 (Grace Hopper SuperChips). En plus du matériel, HPE Services propose une assistance aux entreprises pour les aider à concevoir, déployer et gérer la solution.

Lors de cette GTC 2024, Supermicro a aussi dévoilé une série de serveurs, avec des systèmes dotés de la puce GB200 (Grace Blackwell Superchip), ainsi que des GPU B200 (deux dies Blackwell) et B100 (un die Blackwell). L’entreprise a aussi déclaré que ses systèmes Nvidia HGX H100 et H200 existants étaient désormais « prêts à l'emploi » pour ces GPU, ce qui signifie que les clients peuvent échanger le matériel basé sur Hopper pour Blackwell lorsqu'il sera disponible. Supermicro affirme qu'il sera le premier fabricant de serveurs à lancer les systèmes HGX B200 8-GPU et HGX B100 8-GPU dans le courant de l'année.

Mise à niveau Blackwell pour le HPC Nvidia/AWS

Nvidia et Amazon se sont associés l'année dernière pour construire ce qui devait être l'un des superordinateurs les plus rapides au monde, appelé Project Ceiba. Avec l'annonce du GPU Blackwell, Project Ceiba bénéficiera d'une mise à niveau qui le rendra jusqu'à six fois plus rapide que prévu. Project Ceiba, tel qu'il a été décrit initialement, était une véritable fusée, avec plus de 16 000 accélérateurs H100 Hopper AI et une puissance de traitement pour l'intelligence artificielle de 65 exaflops (précision faible) une fois achevé. Nvidia et Amazon vont améliorer le projet Ceiba avec 10 386 accélérateurs GB200. Rappelons que ce dernier se compose d'un processeur Grace (sur base ARM) et de deux GPU Blackwell assemblées, ce qui correspond à un total de 20 736 GPU.

Commentaire