A la dernière GTC, du 19 au 22 septembre 2022, Nvidia a projeté sa feuille de route pour les années à venir avec une ambition renouvelée pour la simulation numérique. Traditionnellement consacrée aux solutions entreprise (HPC et modélisation), cette conférence développeurs a également accueilli les dernières cartes Geforce du fournisseur : la série RTX 4000 - « Project Beyond » - reposant sur l’architecture Ada Lovelace (pionnière de la science informatique). Elles arrivent - les modèles 4090 et 4080 pour commencer - deux ans après la série RTX 3000, exploitant la plateforme Ampere. Nous reviendrons sur ces produits dans un autre sujet. Lors de cet évènement, le CEO de Nvidia Jensen Huang a dévoilé l’une des mises à jour les plus attendues dans le monde du calcul intensif : l’arrivée de l'accélérateur H100 (architecture Hopper), attendu à l’origine au troisième trimestre de cette année. Comme le mois est déjà bien entamé, il ne sera pas livré en septembre, mais en octobre. La cadence de production s’est accélérée chez son partenaire TSMC (gravure en 4 nm) et les premiers systèmes seront disponibles le mois prochain en OEM. Le H100 vient succéder à l’A100, qui a connu un grand succès dans les datacenters.

La commercialisation des RTX 4090 est prévue le 12 octobre prochain, et celle des 4080 un peu plus tard. Jensen Huang, le CEO de Nvidia, a comme à son habitude - présenté ses derniers produits. (Crédit Nvidia)

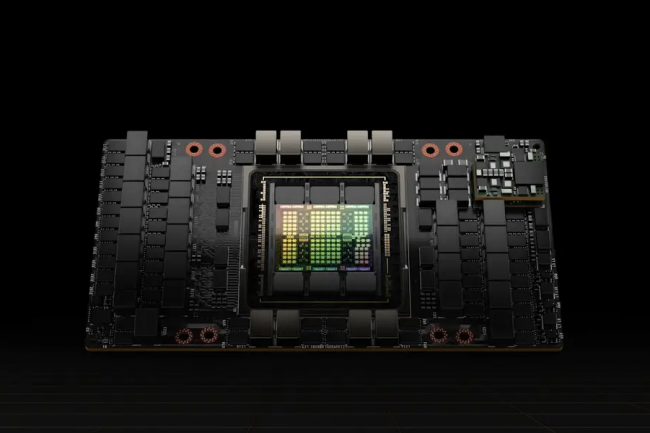

Parmi les améliorations apportées par cet accélérateur par rapport à la précédente génération Ampere introduite en 2020, signalons l’utilisation de composants mémoire HBM3, et une refonte des noyaux tensors. Sans oublier l’innovation la plus importante : le moteur Transformer. Les Transformers sont des modèles d'apprentissage profond largement utilisés et le modèle standard de choix pour le traitement du langage naturel. Nvidia affirme que le moteur Transformer H100 peut accélérer les réseaux neuronaux jusqu'à six fois par rapport à Ampere sans perdre en précision.

Hopper est également livré avec la deuxième génération de la technologie Secure Multi-Instance GPU (MIG), permettant à un seul GPU d'être partitionné en plusieurs partitions sécurisées qui fonctionnent indépendamment et de manière isolée. Une autre nouveauté est une fonction baptisée « confidential computing », qui protège les modèles d'IA et les données des clients pendant leur traitement, en plus de les protéger au repos et en transit sur le réseau. Enfin, Hopper dispose de la quatrième génération de NVLink, la technologie d'interconnexion à haut débit du fournisseur de San Clara, qui peut connecter jusqu'à 256 GPU H100 avec une bande passante neuf fois supérieure à celle de la génération précédente. Et alors que les GPU ne sont pas réputés pour leur efficacité énergétique, le H100 permet aux entreprises - selon le fournisseur - de fournir les mêmes performances en IA avec une efficacité énergétique 3,5 fois supérieure et un coût total de possession 3 fois inférieur à celui de la génération précédente, car les entreprises ont besoin de 5 fois moins de nœuds de serveurs. Doté de 80 milliards de transistors, le H100 consomme toutefois beaucoup d’énergie : le TDP annoncé culmine à 700 Watts.

Un accélérateur très attendu

« Nos clients cherchent à déployer des centres de données qui sont essentiellement des usines d'IA, produisant des IA pour des cas d'utilisation de production. Nous sommes très impatients de voir ce que le H100 va apporter à ces clients, en offrant plus de débit, plus de capacités et en continuant à démocratiser l'IA partout », a expliqué Ian Buck, vice-président en charge du HPC chez Nvidia, lors d'un point de presse. M. Buck, qui a inventé le langage CUDA utilisé pour programmer les GPU de Nvidia pour le calcul intensif et d'autres utilisations, a déclaré que les modèles de langage étendu (LLM) seront l'un des cas d'utilisation de l'IA les plus importants pour le H100.

Concernant la disponibilité des produits, les premiers accélérateurs H100 seront livrés au format PCIe, les modèles SXM pour les serveurs maison HGX – pour les traitements IA, l’analytique et la simulation - seront commercialisés un peu plus tard. Quant aux systèmes DGX H100 (calcul et stockage flash avec des partenaires comme Pure Storage ou DDN) , les livraisons sont attendues au premier trimestre 2023. Signalons en complément, que ces serveurs DGX H100 reposeront sur la plateforme Xeon Scalable (Sapphire Rapids) d’Intel supportant le très attendu protocole CXL. Gravées en 10 nm SuperFIN, ces puces préfigurant des serveurs plus facilement composables ne seront pas livrées avant la fin de l’année, voir même début 2023 selon les projections les plus pessimistes. L’utilisation des processeurs AMD Epyc Genoa (96 coeurs Zen 4 gravés en 5 nm avec DDR5 et PCIe 5) n’est – une nouvelle fois - pas exclue, mais ces puces ne sont pas attendues avant 2023. Ce qui n’accélérera donc pas la livraison des premiers systèmes DGX H100. En attendant ces derniers, les partenaires habituels de Nvidia – Atos, Cisco, Dell, Fujitsu, Gigabyte, HPE et Lenovo – proposeront des systèmes HGX en utilisant les contrôleurs x86 disponibles.

Enfin, AWS, GCP, Microsoft Azure et Oracle Cloud Infrastructure soulignent qu'ils seront parmi les premiers à déployer des instances basées sur le H100 dans le cloud dès l'année prochaine. La plateforme H100 sera disponible en test via le Launchpad de Nvidia, son service d'essai avant achat où les utilisateurs peuvent se connecter et tester le matériel

Commentaire