OpenAI s'est associé à Broadcom pour co-développer et déployer ses premiers processeurs IA maison. Cette initiative pourrait remodeler la dynamique des réseaux de centres de données et les stratégies d'approvisionnement en puces, alors que le créateur de ChatGPT s'efforce d'obtenir davantage de puissance de calcul pour ses charges de travail IA en pleine expansion. Cette collaboration pluriannuelle permettra de déployer 10 gigawatts d'accélérateurs conçus par OpenAI et de systèmes de réseau Ethernet de Broadcom à partir de 2026. Cette évolution vers des puces personnalisées et des architectures réseau ouvertes pourrait influencer la manière dont les entreprises construisent et développent leurs futurs centres de données d’IA. « En concevant ses propres puces et systèmes, OpenAI peut intégrer directement dans le matériel ce qu'elle a appris en développant des modèles et des produits de pointe, et atteindre ainsi de nouveaux niveaux de capacité et d'intelligence », ont déclaré les deux entreprises dans un communiqué. « Les racks, entièrement dimensionnés avec Ethernet et d'autres solutions de connectivité de Broadcom, répondront à la forte demande d’IA mondiale, avec des déploiements dans les installations d'OpenAI et les centres de données de ses partenaires. »

L’Ethernet plutôt que l’InfiniBand pour l’IA

La décision de s'appuyer sur la structure Ethernet de Broadcom plutôt que sur les interconnexions InfiniBand de Nvidia témoigne de la volonté d'OpenAI de mettre en place une infrastructure réseau plus ouverte et évolutive, qui pourrait créer un précédent pour les infrastructures d'IA dans les environnements hyperscale et d'entreprise. Selon les analystes, cette orientation va dans le sens de la tendance générale du secteur qui cherche à adopter des normes réseau ouvertes pour leur flexibilité et leur interopérabilité. « Le choix d'OpenAI marque un tournant vers des architectures plus ouvertes, plus rentables et plus évolutives », a expliqué Charlie Dai, vice-président et analyste principal chez Forrester. « Ethernet offre une interopérabilité plus large et évite la dépendance vis-à-vis d'un fournisseur, ce qui pourrait accélérer l'adoption de clusters d’IA désagrégés. Cette initiative vise aussi à contester la domination d'InfiniBand dans les charges de travail IA hautes performances et pourrait pousser les hyperscalers à se standardiser sur Ethernet pour la diversité de l'écosystème et la souveraineté numérique », a-t-il ajouté.

« Cette décision semble également conforter un avenir où les charges de travail IA s'exécuteront sur des infrastructures IT et réseau hétérogènes », a fait remarquer Lian Jye Su, analyste en chef chez Omdia. « Même s'il est logique que les entreprises s'appuient d'abord sur la solution complète de Nvidia pour déployer leur IA, elles intégreront généralement des solutions alternatives telles que les puces AMD et celles développées en interne pour des raisons de rentabilité, de diversité de la chaîne d'approvisionnement et de disponibilité des puces », a avancé M. Su. « Cela signifie que les fournisseurs de réseaux de centres de données devront envisager l'interopérabilité et les normes ouvertes pour répondre à la diversification de l'architecture des puces IA. » Les hyperscalers et les DSI d'entreprise cherchent de plus en plus à faire évoluer efficacement les serveurs d'IA à mesure que la charge de travail augmente. Les GPU de Nvidia restent à la base de la plupart des entrainements d'IA à grande échelle, mais les entreprises veulent aussi les intégrer à d'autres accélérateurs.

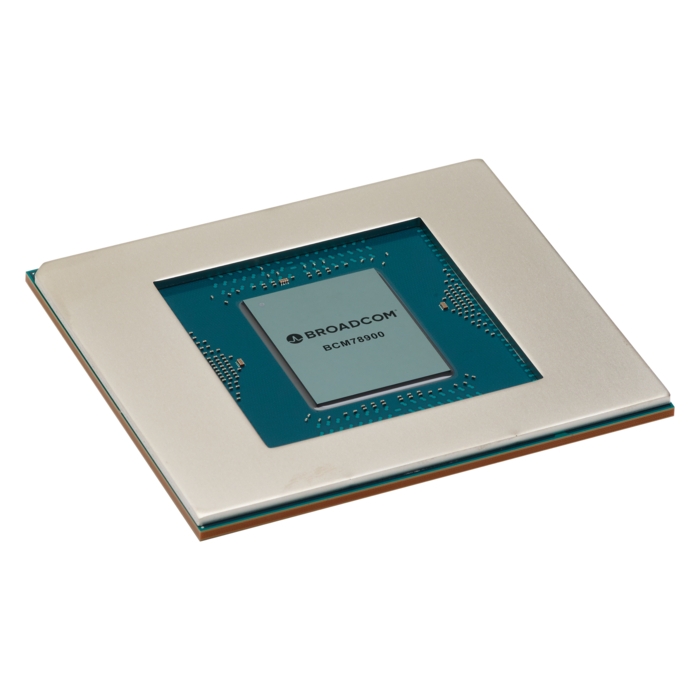

À la différence des commutateurs Ethernet classiques qui donnent la priorité au débit maximal, la puce réseau pour datacenter Tomahawk Ultra de Broadcom est optimisée pour assurer une latence ultra-faible. (Crédit Broadcom)

Selon Neil Shah, vice-président de la recherche chez Counterpoint Research, la récente décision de Nvidia d'ouvrir son interconnexion NVLink aux acteurs de l'écosystème au début de l'année donne aux hyperscalers plus de flexibilité pour associer les GPU Nvidia à des accélérateurs personnalisés de fournisseurs comme Broadcom ou Marvell. « Même si la dépendance à l'égard de Nvidia pour une solution complète s’en trouve atténuée, cette ouverture augmente le marché total accessible pour Nvidia, qui devient la solution la plus prisée pour être étroitement associée au calcul personnalisé des hyperscalers », a expliqué M. Shah. « Afin de se diversifier au-delà des processeurs Intel ou AMD basés sur x86, la plupart des hyperscalers se sont tournés vers des architectures IT personnalisées », a ajouté M. Shah. Beaucoup explorent les conceptions Arm ou Risc-V qui peuvent être adaptées à des charges de travail spécifiques pour profiter d’une plus grande efficacité énergétique et de coûts d'infrastructure réduits.

Une évolution dans les stratégies d’infrastructure IA

Cette collaboration souligne également à quel point les choix en matière de réseau deviennent aussi stratégiques que la conception des puces elle-même, ce qui suggère un changement dans la manière dont les charges de travail d’IA sont alimentées et connectées. La décision d'OpenAI souligne une évolution plus large du secteur vers la diversification des chaînes d'approvisionnement et un meilleur contrôle des performances et des coûts. « Ce partenariat met en évidence une tendance croissante à réduire la dépendance vis-à-vis des GPU et de la pile propriétaire de Nvidia », a pointé M. Dai. « Alors que l'adoption de l'IA se poursuit et que les leaders de l'IA recherchent un meilleur équilibre entre gains de performances et contrôle des coûts, l'intégration verticale via des puces personnalisées devient stratégique. Cette évolution pourrait favoriser les Asic et les structures basées sur Ethernet et encourager la concurrence entre les fabricants de puces. » Cependant, M. Su a fait remarquer que seules quelques entreprises, principalement des hyperscalers et de grands fournisseurs de GenAI, seront en mesure de concevoir leur propre matériel d'IA tout en fournissant un support logiciel interne suffisant. Selon lui, la plupart des entreprises continueront probablement à s'appuyer sur les solutions full-stack de Nvidia.

Commentaire