Tirer le meilleur parti de l'IA agentique est une priorité pour de nombreuses entreprises pour l'année à venir. En effet, tous les dirigeants d'entreprises souhaitent déployer des agents IA autonomes pour réorganiser une série d'opérations et de flux de travail. Cette technologie est naissante et, comme pour le déploiement de la GenAI, les DSI sont sous pression pour mettre rapidement en place des stratégies agentiques. Ce contexte d'expérimentation et de déploiement généralisés peut vite devenir cauchemardesque pour les RSSI chargés d'assurer la sécurité de leur entreprise, avec l'identité et l'authentification comme préoccupation majeure. Certains experts en sécurité estiment que plus de 95 % des entreprises qui déploient ou expérimentent des agents autonomes le font sans tirer parti des mécanismes de cybersécurité existants, comme l'infrastructure à clé publique (public key infrastructure, PKI), pour suivre, identifier et contrôler leurs agents. Ce problème devient encore plus dangereux en raison de la prévalence des communications entre agents, courantes dans les déploiements d'IA agentique. Pour qu'elle fonctionne, ces agents doivent communiquer ensemble de manière autonome pour transmettre des tâches, des données et du contexte. Sans une gestion suffisante des identités, une authentification et des mesures de cybersécurité appropriées, non seulement un agent pourrait être contrôlé par un cybercriminel ou un acteur étatique, mais d'autres malveillants pourraient également mener diverses attaques par injection de commandes. Si l'un d'eux communique avec les agents légitimes d'une entreprise, le détecter et retirer ses identifiants ne suffira pas à limiter les dégâts.

La probabilité de cet effet domino n'est pas négligeable. La plupart des mécanismes d'authentification robustes actuels révoquent et/ou désactivent les identifiants lorsqu'un comportement malveillant est détecté. Mais les systèmes d'analyse comportementale doivent souvent constater des actes malveillants avant de pouvoir signaler le problème et désactiver l'identifiant. Toutes les actions précédemment initiées par l'agent compromis seront déjà en cours dans toute la chaîne d'agents. L'objectif est d’avoir une trace de chaque interaction et de disposer d'un système automatisé pour contacter tous les agents légitimes ayant interagi avec celui ou ceux qui sont malveillants afin de leur demander d'ignorer ses instructions et d'émettre une alerte de sécurité portant sur le ou les agents malveillants. Mais les fournisseurs n'ont pas encore répondu à ce besoin. De plus, de nombreux experts en sécurité affirment que ce problème est trop complexe pour être facilement résolu. « Étant donné que les agents autonomes sont de plus en plus capables d'exécuter des actions réelles au sein d'une entreprise, si un acteur malveillant parvient à influencer le processus décisionnel d'un agent autonome, les dommages qui en résulteraient pourraient être exponentiellement plus importants que dans un scénario de violation traditionnel », a expliqué Nik Kale, ingénieur principal chez Cisco et membre de la Coalition for Secure AI (CoSAI) et du comité du programme AI Security (AISec) de l'ACM.

Une surface d'attaque en constante expansion

« Les agents étant programmés pour suivre des instructions, ils sont susceptibles de suivre une instruction douteuse en l'absence d'un mécanisme les obligeant à ralentir leur processus afin de valider la sécurité de la demande », a ajouté Nik Kale. « Les humains ont de l'intuition et sentent donc souvent quand quelque chose ne va pas. Les agents ne possèdent pas ce sens instinctif et suivront donc toute demande, à moins que le système ne les en empêche spécifiquement. » Gary Longsine, CEO d'IllumineX, reconnait que les risques de cybersécurité liés au déploiement incontrôlé d'agents sont sans précédent pour les RSSI. « La surface d'attaque de l'agent IA peut être considérée comme infinie, en raison de l'interface en langage naturel et de la capacité de l'agent à faire appel à un éventail potentiellement vaste d'autres systèmes agentiques », prévient M. Longsine. Jason Sabin, directeur technique de DigiCert, estime pour sa part que la situation pourrait être encore pire en raison de la relative facilité avec laquelle il est possible de détourner un agent. « Sans une authentification robuste des agents, les entreprises risquent de déployer des systèmes autonomes qui peuvent être piratés à l'aide d'une seule fausse instruction », a mis en garde M. Sabin.

Le casse-tête de la gestion des identités des agents IA

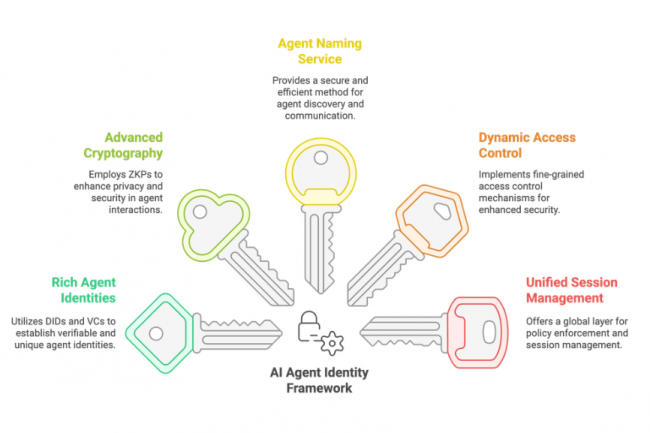

Parmi les experts en authentification et en agents IA interrogés, trois seulement estiment que moins de 5 % des entreprises expérimentant des agents autonomes ont déployé des systèmes d'identité agentique. Selon eux, ces manques dans le renforcement de la sécurité ont plusieurs raisons. Tout d'abord, bon nombre de ces efforts relèvent en fait du shadow IT, où un responsable métier a autorisé la validation du concept afin de voir ce que ces agents peuvent faire. Dans ces cas, les équipes IT ou cybersécurité n'ont probablement pas été impliquées, et la sécurité n'a donc pas été une priorité absolue. Ensuite, de nombreux dirigeants, y compris leurs partenaires business impliqués dans la supply chain logicielle des entreprises, manquent encore de recul sur les impacts sécurité liés à la mise en place de PoC, traditionnellement confinés à des sandbox isolés d'environnements réels. Mais les systèmes agentiques ne fonctionnent pas ainsi. Pour tester leurs capacités, ils doivent généralement être déployés dans l'environnement en production. La bonne façon de procéder consiste alors à suivre et à contrôler tous les agents dans cet environnement (qu'ils soient autorisés par le service IT, lancés par les applications métier ou par un tiers) à l'aide d'identités PKI fournies par des fournisseurs d'authentification des agents.

Une défense extrême consisterait à demander à tous les agents autorisés de refuser toute communication provenant d'un agent non identifié. Malheureusement, les agents autonomes, à l'instar de leurs cousins GenAI, ignorent souvent les instructions (ou les « garde-fous »). « Les communications légitimes entre agents sont en contradiction avec les principes de sécurité essentiels. Les entreprises ne peuvent pas prendre le risque que des agents se découvrent de manière autonome, établissent des canaux de communication et forment des relations transactionnelles », a déclaré Kanwar Preet Singh Sandhu, qui suit les stratégies de cybersécurité pour Tata Consultancy Services. « Lorsque le service IT conçoit un système, ses tâches et ses objectifs doivent être clairement définis et limités à ces fonctions », a-t-il ajouté. « Si les interactions entre agents sont techniquement possibles, elles posent de sérieux risques pour des principes comme le moindre privilège et la séparation des tâches. Pour une collaboration ou une intégration structurée et planifiée, les entreprises doivent suivre des protocoles stricts comme MCP (model context protocol) et A2A (agent to agent), qui ont été créés précisément à cette fin. » M. Sabin affirme quant à lui que ses interactions avec les entreprises ont révélé que « peu ou aucune » d'entre elles créaient des identités pour leurs agents autonomes. « Certainement moins de 10 %, probablement moins de 5 %. Il y a un énorme fossé en matière d'identité. »

Un retour arrière difficile

« Une fois que les expériences d'agent ont commencé sans que les identités appropriées aient été établies, il est beaucoup plus difficile d'ajouter une authentification d'identité par la suite », a souligné M. Sabin. « Comment ajouter l'identité après coup ? Ces processus ne sont pas établis. L'agent peut être et sera détourné, compromis. Il faut disposer d'un dispositif d'arrêt d'urgence », a-t-il fait remarquer. « La capacité des agents IA à vérifier qui émet une commande et si cet humain/système dispose de l'autorité nécessaire est l'un des enjeux de sécurité déterminants de l'IA agentique. » Pour résoudre ce problème, les RSSI devront probablement repenser l'identité, l'authentification et les privilèges. « Ce qui est vraiment difficile dans tout ça, c'est qu’on ne détermine plus comment un humain s'authentifie auprès d'un système. On nous demande désormais de déterminer comment un agent autonome détermine que la personne qui donne les instructions est légitime et que ces instructions correspondent au modèle d'action attendu », a expliqué M. Kale de Cisco. « Le passage à la détermination de la légitimité sur la base de l'évaluation par l'agent autonome de l'intention de l'humain, plutôt que la simple identification de l'humain, introduit toute une série de nouveaux facteurs de risque qui n'avaient jamais été anticipés par les méthodes d'authentification traditionnelles. »

Ishraq Khan, CEO du fournisseur d'outils de productivité de codage Kodezi, estime également que les RSSI sous-estiment probablement les menaces de sécurité qui existent au sein des systèmes d'IA agentiques. « Les frameworks d'authentification traditionnels supposent des identités statiques et des modèles de requêtes prévisibles. Les agents autonomes créent une nouvelle catégorie de risques, car ils initient des actions de manière indépendante, intensifient leur comportement en fonction de leur mémoire et créent eux-mêmes de nouvelles voies de communication. La surface d'attaque devient dynamique, et non plus statique », a pointé M. Khan. « Lorsque les agents mettent à jour leur propre état interne, tirent des enseignements des interactions précédentes ou modifient leur rôle au sein d'un flux de travail, leur identité du point de vue de la sécurité évolue au fil du temps. La plupart des entreprises ne sont pas préparées à faire face à des agents dont les capacités et le comportement évoluent après l'authentification. » M. Khan ajoute : « Un agent compromis peut usurper des modèles de collaboration, fabriquer de toutes pièces l'état du système ou manipuler d'autres agents pour provoquer des défaillances en cascade. Il ne s'agit pas simplement d'un logiciel malveillant. Il s'agit d'une attaque comportementale contre la prise de décision. »

Harish Peri, vice-président senior et directeur général de la sécurité IA chez Okta, le dit plus directement : « Ce n'est pas seulement un problème d’identité non humaine (Non Human Identity, NHI). C'est la recette d'un désastre. Il s'agit d'un nouveau type d'identité, d'un nouveau type d'utilisateur implacable. » Sur l'impossibilité de réparer les dégâts lorsqu'un agent piraté donne des instructions malveillantes à des agents légitimes, M. Peri affirme qu'il s'agit d'un problème difficile que personne ne semble avoir encore résolu. « Si le signal de risque est suffisamment fort, il est possible de révoquer non seulement le privilège, mais aussi le jeton d'accès », a assuré M. Peri. Mais « le chaînage en temps réel nécessite une réflexion plus approfondie ».

Démêler les interactions entre agents, une tâche ardue

L'un des problèmes est que le suivi des interactions pour le chaînage arrière (ou Backward Chaining) nécessitera la collecte d'une quantité massive de données auprès de chaque agent dans l'environnement de l'entreprise. De plus, étant donné que les agents autonomes agissent beaucoup plus rapidement que les humains, un entrepôt de données dédié à cette activité risque d'être rapidement débordé. « Au moment où l'agent effectue une action et où son identité est révoquée, tous les agents en aval ont déjà interagi avec cet agent compromis. Ils ont déjà accepté des missions et ont déjà préparé les actions suivantes », a détaillé M. Kale de Cisco. « Il n'existe aucun mécanisme permettant de propager cette révocation en amont. Les kill switches sont nécessaires, mais ils sont incomplets. » Le processus consistant à remonter à tous les agents contactés « semble facile à résoudre par simple script, jusqu'à ce que l’on essaye de le faire correctement », a-t-il souligné. « Il faut connaître toutes les instructions données par un agent, le plus difficile étant de décider ce qu'il faut annuler. » Un scénario que M. Kale compare à la fatigue des alertes. « Tout cela pourrait s'effondrer sous son propre poids. À ce stade, tout pourrait devenir du bruit et non plus de la sécurité. »

Jason Soroko, chercheur senior chez Sectigo, convient que l'alerte rétroactive des agents concernés « est loin d'être entièrement résolue à l'heure actuelle ». Mais il soutient que la cybersécurité agentique s'est involontairement mise dans une impasse. « De nombreux agents IA autonomes s'appuieront sur un simple jeton API pour s'authentifier. Nous avons involontairement créé une arme qui n'attend qu'un secret partagé à voler », a affirmé M. Soroko. « Pour remédier à cela, il faut aller au-delà des secrets partagés et passer à la preuve cryptographique de possession, en veillant à ce que l'agent vérifie l'identité de l’agent à l’origine de la commande, et ne se limite pas à une simple authentification.

Commentaire