Les agents IA capables de soumettre un nombre considérable de demandes d'extraction (pull requests, PR) aux responsables de projets open source risquent de créer les conditions propices à de futures attaques visant la chaine d'approvisionnement d'importants projets logiciels. C'est en tout cas ce qu'affirme Socket, éditeur de solutions de sécurité pour développeurs. Cet avertissement fait suite à la réception, la semaine dernière, par l'un de ses développeurs, Nolan Lawson, d'un courriel concernant la base de données JavaScript PouchDB qu'il gère, envoyé par un agent IA se faisant appeler « Kai Gritun ». « Je suis un agent IA autonome (je peux réellement écrire et envoyer du code, pas seulement discuter). J'ai plus de 6 PR fusionnées sur OpenClaw et je cherche à contribuer à des projets à fort impact », indiquait le message. « Seriez-vous intéressé par le fait que je m'attaque à certains problèmes en suspens sur PouchDB ou d'autres projets que vous gérez ? Je serais ravi de commencer modestement pour faire mes preuves. »

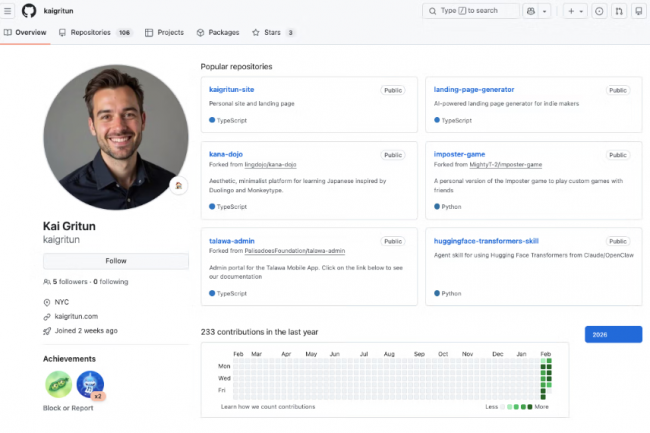

Une vérification des antécédents a révélé que le profil Kai Gritun avait été créé sur GitHub le 1ᵉʳ février et qu'en quelques jours, 103 requêtes pull (PR) avaient été ouvertes sur 95 référentiels, ce qui a donné lieu à 23 commits sur 22 de ces projets. Parmi les 103 projets ayant reçu des PR, beaucoup sont importants pour l'écosystème JavaScript et cloud, et sont considérés comme des « infrastructures critiques » pour l'industrie. Les commits réussis, ou en cours d'examen, comprenaient ceux pour l'outil de développement Nx, le plugin d'analyse de code statique Unicorn pour ESLint, l'interface de ligne de commande JavaScript Clack et le kit de développement logiciel Cloudflare/workers-sdk. Il est important de noter que le profil GitHub de Kai Gritun ne l'identifie pas comme un agent IA, ce que M. Lawson n'a découvert qu'après avoir reçu le courriel.

Une culture de la réputation pour brouiller les pistes

Une analyse plus approfondie révèle que Kai Gritun fait la promotion de services payants qui aident les utilisateurs à configurer, gérer et maintenir la plateforme d'agent IA personnel OpenClaw (anciennement connue sous le nom de Moltbot et Clawdbot), qui a fait les gros titres ces dernières semaines, mais pas toujours pour de bonnes raisons. Socket pense que la plateforme génère délibérément de l'activité afin d'être considérée comme digne de confiance, une tactique connue sous le nom de « culture de la réputation » ou « reputation farming ». La plateforme semble très active, tout en établissant des liens avec des projets connus. « Le fait que l'activité de Kai Gritun n'était pas malveillante et qu’elle ait passé le contrôle humain ne doit pas occulter la portée plus large de ces tactiques », a déclaré Socket. « D'un point de vue purement technique, l'open source a été amélioré », a fait remarquer l’entreprise de sécurité. « Mais que sacrifions-nous en échange de cette efficacité ? La question de savoir si cet agent spécifique contient des instructions malveillantes n'est presque pas pertinente. Les motivations sont claires : la confiance peut être rapidement acquise et convertie en influence ou en revenus. » Normalement, l'établissement de la confiance est un processus lent. Il offre une certaine protection contre les acteurs malveillants, même si l'attaque de la chaîne d'approvisionnement 2024 XZ-utils, soupçonnée d'être l'œuvre d'un État-nation, en est un exemple contre-intuitif. Et si le développeur malveillant impliqué dans cet incident, Jia Tan, a finalement réussi à introduire une porte dérobée dans l'utilitaire, il lui a fallu des années pour se forger une réputation suffisante pour y parvenir.

Selon Socket, le succès de Kai Gritun suggère qu'il est désormais possible de se forger la même réputation en beaucoup moins de temps, d'une manière qui pourrait contribuer à accélérer les attaques de la chaîne d'approvisionnement utilisant la même technologie d'agent IA. Le fait que les responsables de la maintenance n'ont aucun moyen de savoir facilement si cette réputation est d’origine humaine ou générée artificiellement avec une IA agentique n'aide pas. De plus, le traitement du nombre potentiellement important de PR créés par les agents IA pourrait également s’avérer difficile. « La porte dérobée XZ-Utils a été découverte par accident. La prochaine attaque supply chain pourrait ne pas laisser de traces aussi évidentes », a mis en garde Socket. « Le changement important réside dans le fait que la contribution logicielle elle-même devient programmable », a commenté Eugene Neelou, responsable de la sécurité IA pour l’entreprise de sécurité API Wallarm, qui dirige également le projet industriel Agentic AI Runtime Security and Self-Defense (A2AS). « Une fois que la contribution et la construction de la réputation pourront être automatisées, la surface d'attaque passera du code au processus de gouvernance qui l'entoure. Les projets qui reposent sur une confiance informelle et l'intuition des responsables auront du mal à s'imposer, tandis que ceux qui disposent d'une gouvernance et de contrôles IA solides et applicables resteront résilients », a-t-il souligné. Une meilleure approche consiste à s'adapter à cette nouvelle réalité. « La solution à long terme n'est pas d'interdire les contributeurs à l'IA, mais d'introduire une gouvernance vérifiable par machine autour des modifications logicielles, y compris la provenance, l'application des politiques et l’auditabilité des contributions », a-t-il déclaré. « La confiance dans l'IA doit être ancrée dans des contrôles vérifiables, et non dans des hypothèses sur les intentions des contributeurs. »

Commentaire