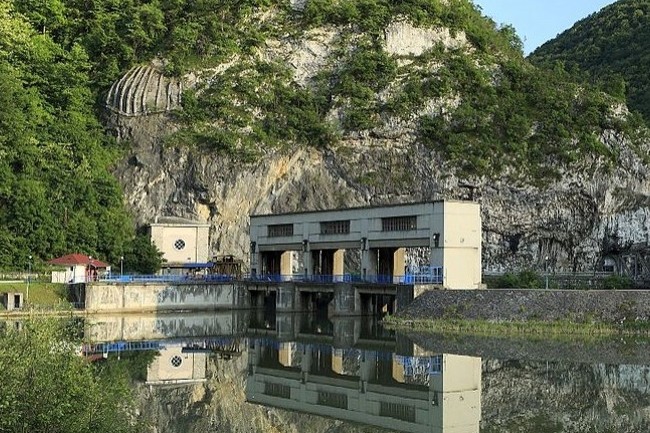

La production d'énergie renouvelable n'est paradoxalement pas exempte d'impact environnemental. Les centrales hydro-électriques n'y font pas exception, leur fonctionnement peut bloquer la circulation des poissons ou augmenter la température de l'eau, entre autres effets néfastes. Pour tenter de pallier ces effets nocifs, l'Union Européenne finance à hauteur de 4 M€ le projet Di-Hydro (Digital maintenance for sustainable and flexible operation of hydropower plant) pour la digitalisation de ces installations, comme l'évoque la publication I'MTech de l'Institut Mines-Télécoms.

Démarré en octobre 2023 pour une durée de 3 ans, Di-Hydro s'appuie sur une architecture IoT pour les centrales. Deux objectifs principaux : optimiser le fonctionnement de ces installations en améliorant leur maintenance, mais aussi suivre l'évolution de la qualité de l'eau et de la biodiversité des écosystèmes. Des fournisseurs d'énergie locaux et des équipes de recherche comme celles de Télécom SudParis fourniront ou développeront des capteurs adaptés, dont l'installation et la mise en fonction devraient durer 6 mois.

Consolidation de modèles de data locales

Les chercheurs de Di-Hydro développent aussi un outil partagé d'analyse et d'exploitation des données. Au programme, IA et jumeau numérique. Sollicitées de prime abord pour assurer la cybersécurité du système, les équipes de recherche de Télécom SudParis (Georgios Bouloukabis, professeur associé, et Joaquim Garcia Alfaro, professeur) ont en effet également pris en charge l'intégration de la plate-forme IoT dans l'écosystème des centrales. Des jumeaux numériques de ces dernières seront conçus à partir de données descriptives statiques des sites et de données dynamiques générées par les capteurs. Les équipes de Di-Hydro ont dû travailler sur la définition d'un standard commun pour ces datas d'origines et donc de formats différents. Des données souvent incompatibles entre elles.

Pour exploiter ces jumeaux numériques, les équipes de recherche développent un algorithme de prise de décision distribuée à partir de plusieurs modèles d'IA entraînés à partir de données locales pour commencer. Elles comptent ensuite travailler sur du partage sélectif et des architectures logicielles fédérées. Ce modèle d'IA s'appuierait alors sur la consolidation de plusieurs modèles entraînés sur des data locales, pour une prise de décision à plusieurs niveaux, mais aussi sur la complétion de données manquantes.

Les centrales hydroélectriques à l'heure de l'IoT, de l'IA et des jumeaux numériques

0

Réaction

L'équipement en capteurs, jumeaux numériques et IA pourrait optimiser le fonctionnement des centrales hydroélectriques, et en limiter l'impact environnemental. Un projet de recherche impliquant Télécom SudParis s'y attèle, comme le détaille I'MTech, publication de l'Institut Mines-Télécom.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire