D'après Global Data, le marché des semiconducteurs conçus pour traiter les charges de travail de l'intelligence artificielle (IA) va atteindre 53 Md$ de chiffre d'affaires en 2023, 67 Md$ en 2024, puis 119,4 Md$ en 2027. Ce boom profite largement à l'américain Nvidia qui a publié mercredi un bilan impressionnant pour le compte de son deuxième trimestre 2024. Entre mai et juillet derniers, les revenus du numéro un mondial des GPU et autres accélérateurs ont bondi de 101 % d'une année sur l'autre à 13,5 Md$. Plus étonnant encore, le résultat opérationnel de l'entreprise a enregistré une hausse de 1 263 % à 6,8 Md$, pendant que le résultat net grimpait de 843 % à 6,2 Md$.

171 % de croissance pour l'activité Data Center

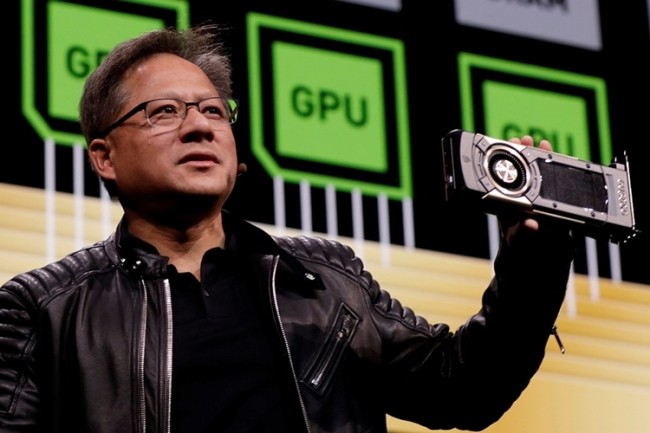

Les effets de l'adoption rapide de l'IA sur les résultats de Nvidia se font avant tout sentir sur ses ventes de produits équipant les datacenters, notamment ceux des principaux opérateurs de cloud public. En trois mois, leur valeur a progressé de 171 % à 10,3 Md$. Un résultat qui constitue une véritable transformation de l'entreprise trentenaire, dont le gros de l'activité a longtemps reposé sur les GPU à usage graphique, notamment ceux utilisés pour le rendu 3D (gaming, CAO/PLM). Or, au cours du trimestre écoulé, le chiffre d'affaires généré par ces produits ne s'est apprécié que de 11 % à 3,1 %, soit 23 % des facturations globales de Nvidia, contre 41 % un an plus tôt et 60 % deux ans auparavant. « Une nouvelle ère a commencé dans l'IT. A travers le monde, les entreprises passent d'une informatique généraliste à une informatique accélérée et à l'IA générative », s'est félicité Jensen Huang, le fondateur et CEO de Nvidia, dans un communique de presse.

Un pari sur l'IA fait il y a plusieurs années

Si le fournisseur est actuellement le leader incontesté pour le traitement des charges de travail liées à l'IA, il le doit à des investissements dans ce domaine qui ont commencé il y a plusieurs années. Par exemple, en livrant en 2017 le GPU pour PC Titan V, un produit taillé pour répondre à des besoins de traitements orientés apprentissage machine. En 2018, le californien annonçait la disponible de son accélérateur GPU Tesla V100 sur l'ensemble de sa gamme de serveurs dédiés au calcul intensif DGX. La même année, il dévoilait la plateforme HGX-2 qui entend répondre aux exigences des charges de travail d'intelligence artificielle. A l'heure actuelle, Nvidia domine le marché du traitement des charges de travail liées à l'IA notamment avec ses puces A100 and H100 AI facturées plus de 30 000$ piéce.

On peut également citer les récentes annonces produits de l'entreprises, comme le GH200 Grace Hopper Superchip qui devrait être disponible dans le courant du deuxième trimestre calendaire 2024. Sans compter les serveurs OVX, équipés des derniers accélérateurs L40S et disponibles depuis ce mois d'août.

Commentaire