Dans un contexte géopolitique très tendu au Proche-Orient avec des échanges haineux sur les réseaux sociaux, Microsoft a annoncé la disponibilité d’Azure AI Content Safety, un service adossé à des ressources IA qui vient aider les utilisateurs à détecter et à filtrer le contenu malveillant dans les applications et services. La solution inclut la détection de texte et d’images et identifie le contenu que Microsoft qualifie d’« offensant, risqué ou indésirable », notamment les grossièretés, le contenu pour adultes, le sang, la violence et certains types de discours haineux. « En nous concentrant sur la sécurité du contenu, nous pouvons créer un environnement numérique plus sûr qui favorise une utilisation responsable de l’IA et protège le bien-être des individus et de la société dans son ensemble », a écrit Louise Han, chef de produit pour Azure Anomaly Detector, dans un article de blog annonçant le lancement du service. Azure AI Content Safety a la capacité de gérer diverses catégories de contenu, langues et menaces pour modérer le contenu textuel et visuel. Il offre également des fonctionnalités d’analyse d’images qui utilisent des algorithmes d’IA pour numériser, décortiquer et modérer les contenus visuels, garantissant ainsi ce que Microsoft appelle des mesures de sécurité complètes à 360 degrés.

Texte et image, mais pas encore la vidéo et l'audio

Le service est également équipé pour modérer le contenu dans plusieurs langues et utilise une métrique de gravité qui fournit une graduation allant de 0 à 7. Le contenu noté 0-1 est considéré comme sûr et approprié pour tous les publics, tandis que le contenu qui exprime des opinions préjugées, critiques ou opiniâtres est noté 2-3, ou faible. Le contenu de gravité moyenne est classé entre 4 et 5 et contient un langage offensant, insultant, moqueur, intimidant ou des attaques explicites contre des groupes identitaires, tandis que le contenu de gravité élevée, qui contient la promotion préjudiciable et explicite d’actes préjudiciables, ou approuve ou glorifie des formes extrêmes d’actes préjudiciables envers des groupes identitaires, est classée 6-7.

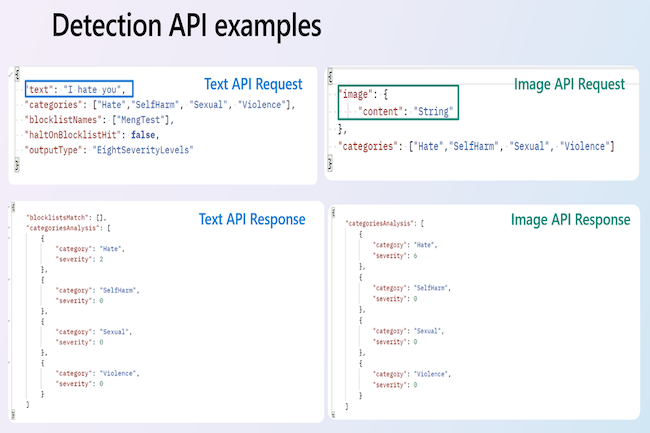

Azure AI Content Safety utilise également le filtrage multi-catégorie pour identifier et catégoriser les contenus préjudiciables dans un certain nombre de domaines critiques, notamment la haine, la violence, l’automutilation et le sexe. « [Quand il s’agit de sécurité en ligne], il est crucial de ne pas se limiter au contenu généré par l’homme, d’autant plus que le contenu généré par l’IA devient répandu », a écrit Mme Han. « Il est essentiel de garantir l’exactitude, la fiabilité et l’absence d'éléments nocifs ou inappropriés dans les résultats générés par l’IA. La sécurité du contenu protège non seulement les utilisateurs contre la désinformation et les préjudices potentiels, mais respecte également les normes éthiques et renforce la confiance dans les technologies d’IA ». Azure AI Content Safety est facturé à l’usage. Les utilisateurs intéressés peuvent consulter les options de tarification sur la page d’Azure AI Content Safety.

Commentaire