Il vous reste 71% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

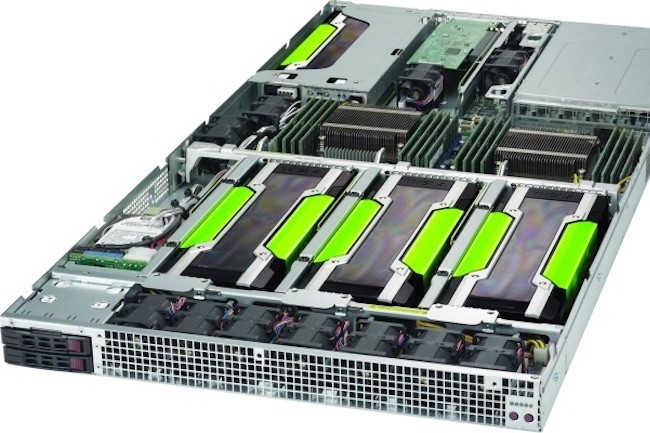

Selon Nvidia, la délivrance de prédictions à partir d'un GPU est également plus efficace qu'un CPU en terme de dépense énergétique et la latence dans les résultats est plus faible.

Il vous reste 71% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire