Lors de la conférence développeur GCT, la première grande annonce matérielle de Nvidia concernait l'unité de traitement de données (Data Processing Unit, DPU) réseau BlueField-3, destinée à décharger le CPU des tâches de traitement réseau. BlueField est une carte réseau de type SmartNIC qui résulte de l'acquisition de Mellanox par Nvidia en 2019. BlueField-3 possède deux fois plus de cœurs processeur Arm que le produit de la génération précédente, et globalement plus d'accélérateurs pour exécuter des charges de travail jusqu'à huit fois plus rapidement. BlueField-3 peut accélérer les charges de travail réseau dans le cloud et sur site pour le calcul haute performance et les charges de travail d'IA dans un environnement hybride. Selon Kevin Durling, vice-président du réseau chez Nvidia, le déchargement des opérations collectives MPI du CPU par Bluefield augmente la vitesse de près de 20 %, ce qui permet d’économiser 18 millions de dollars sur les supercalculateurs à grande échelle. Oracle est le premier fournisseur de services cloud à proposer l'accélération BlueField-3 dans son service Oracle Cloud Infrastructure (OCI) avec le serveur DGX Cloud de Nvidia. Cisco, Dell EMC, DDN, Juniper, Palo Alto Networks, Red Hat et VMware figurent parmi les principaux partenaires de BlueField-3.

Un accélérateur universel pour la vidéo ou l'IA

La carte L4 est l’un des premiers produits basés sur le GPU annoncé par Nvidia. Cette carte, qui succède à la carte Nvidia T4, utilise un refroidissement passif et ne nécessite pas de connecteur d'alimentation. D’après la description de Nvidia, la carte L4 est un accélérateur universel pour la vidéo, l'intelligence artificielle et le graphisme. En tant que carte low-profile, elle s'intègre dans n'importe quel serveur, transformant n'importe quel le plateforme en datacenter d'IA. La carte L4 est spécifiquement optimisée pour la vidéo IA avec des accélérateurs pour l'encodage et le décodage. Nvidia affirme que ce GPU est quatre fois plus rapide que la version T4 précédente, 120 fois plus rapide qu'un système CPU traditionnel, tout en consommant 99 % d'énergie en moins qu'un serveur CPU, et qu'il peut décoder 1040 flux vidéo provenant de différents terminaux mobiles. Google sera en quelque sorte le partenaire de lancement de cette carte, le L4 prenant en charge les services d'IA générative disponibles pour les clients de GCP. Le H100 NVL est un autre produit de Nvidia basé sur le GPU. Il s’agit en fait deux processeurs H100 sur une seule carte. Ces deux GPU fonctionnent comme un seul pour déployer des modèles à grand langage et des modèles d'inférence GPT avec de 5 milliards à 200 milliards de paramètres, ce qui est 12 fois plus rapide que le débit d'un processeur x86, selon Nvidia.

Plus de détails sur DGX Cloud

Nvidia a fourni un peu plus de détails sur DGX Cloud, ses systèmes d'IA hébergés par des fournisseurs de services cloud, notamment Microsoft Azure, Google Cloud et Oracle Cloud Infrastructure. Le mois dernier, le CEO de Nvidia, Jensen Huang, avait déjà annoncé ce service lors d'une conférence téléphonique sur les résultats avec les analystes, mais il n'avait pas donné beaucoup de détails à son sujet. DGX Cloud n'est pas seulement un hardware, c’est aussi une pile logicielle complète qui transforme DGX Cloud en offre d'entrainement IA clé en main en tant que service. Il suffit de pointer l'ensemble de données que l’on souhaite entrainer, d'indiquer où les résultats doivent aller, et la plateforme est opérationnelle. Les instances DGX Cloud sont proposées à partir de 36 999 dollars par instance et par mois. Il sera également possible d’acheter et de déployer DGX Cloud sur site.

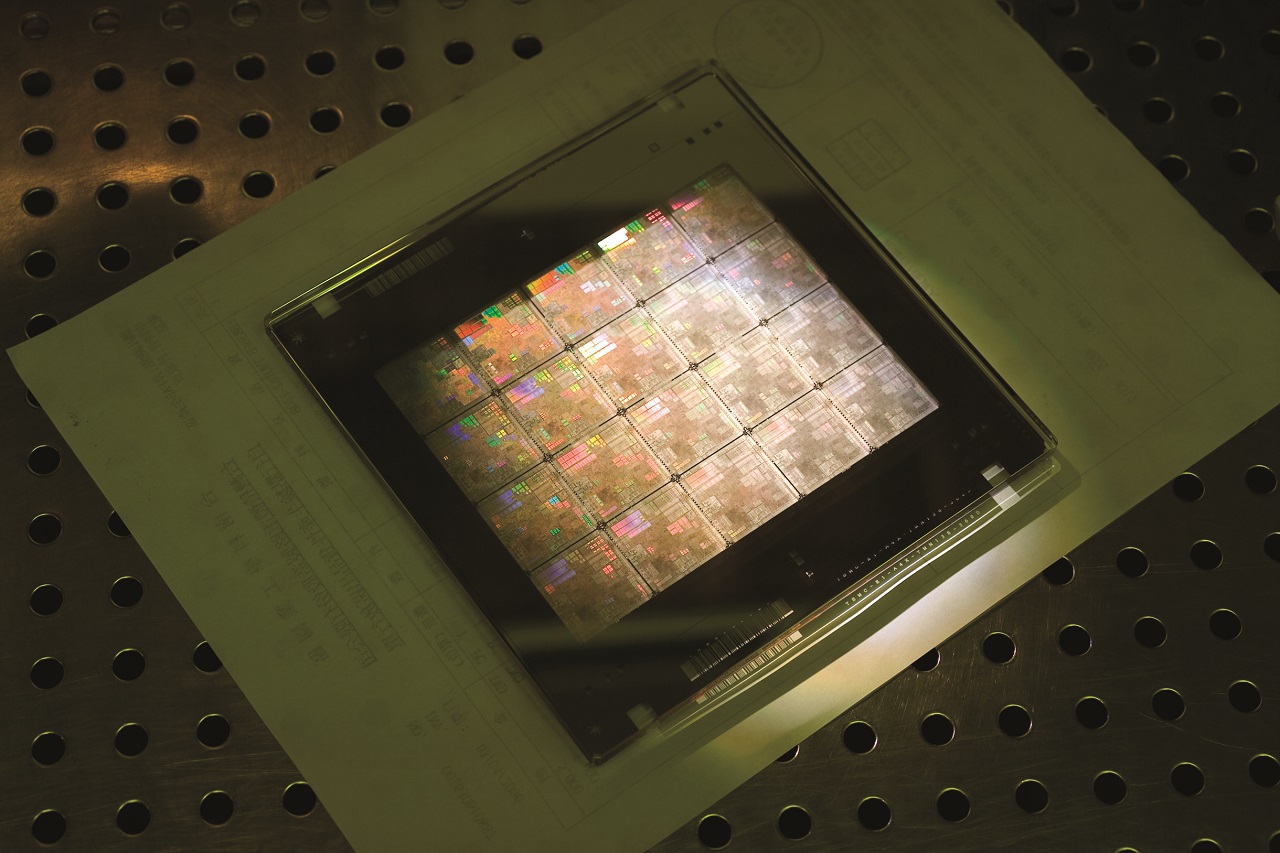

Pour accélérer les calculs en lithographie, Nvidia a développé une solution baptisée cuLitho exploitant des ressources GPU. (Crédit Nvidia)

Premiers pas dans la lithographie de puces

La fabrication de puces n'est pas un processus insignifiant quand il s’agit de produire des transistors dont la taille se mesure en nanomètres. Appelé lithographie ou photographie informatique, le processus de fabrication des puces consiste à imprimer sur un morceau de silicium les modèles de puces créés sur un ordinateur. Les puces étant de plus en plus petites, il faut davantage de traitement informatique pour créer les images. Aujourd'hui, des datacenters entiers sont dédiés au traitement de la photographie informatique. Nvidia a proposé une solution appelée cuLitho dont les algorithmes peuvent accélérer les calculs sous-jacents de la photographie informatique. Jusqu'à présent, en utilisant l'architecture Hopper, Nvidia a démontré que les calculs étaient 40 fois plus rapides. 500 systèmes Hopper (4 000 GPU) peuvent effectuer le travail de 40 000 systèmes CPU en utilisant un huitième de l'espace et un neuvième de la puissance. Un design de puce qui prendrait normalement deux semaines à traiter peut désormais l'être en une nuit. Le temps de traitement et de création des puces est donc significativement réduit. Une fabrication plus rapide signifie une offre plus importante et, il faut l’espérer, une baisse des prix. Les fabricants ASML, TSMC et Synopsys sont les premiers clients de la solution cuLitho dont la mise en production est prévue pour juin 2023.

Commentaire