Il vous reste 91% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

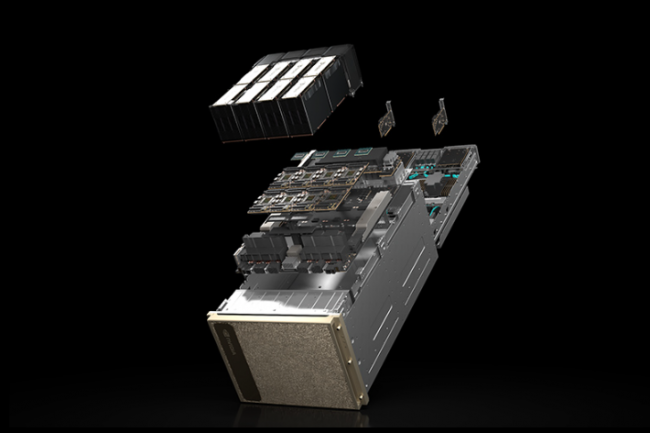

Attendues depuis plusieurs mois, les puces Intel Xeon Scalable de 4e génération arrivent dans les serveurs et baies de stockage des principaux fournisseurs. Ils apportent des accélérateurs activables et une sécurité renforcée pour les VM.

Il vous reste 91% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire