Il vous reste 92% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

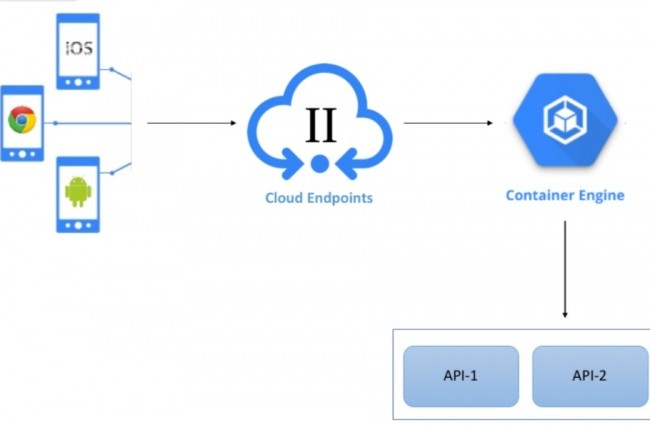

En dissociant les postes et navigateurs clients des services, les passerelles API simplifient la vie des développeurs et des utilisateurs. Il peut également apporter d'autres avantages en termes de surveillance, journalisation, sécurité et équilibrage de charge.

Il vous reste 92% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire