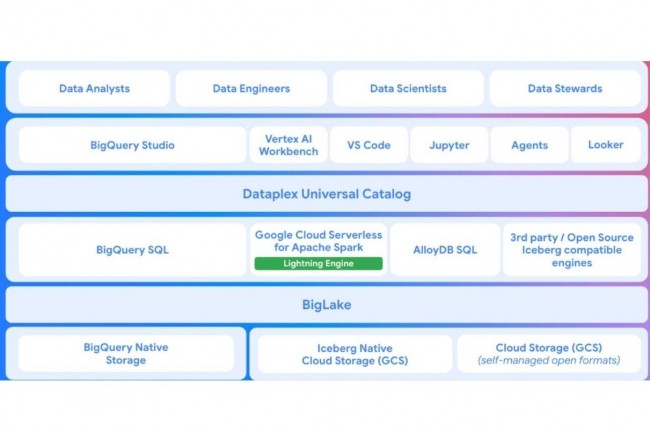

Google Cloud a présenté une salve de mises à jour de son offre data lake, conçues pour optimiser les performances et réduire les coûts. Ces améliorations concernent BigQuery, Cloud Storage, Dataplex Universal Catalog et Apache Spark. Pierre angulaire de ce portefeuille, BigLake, un service qui permet l'analyse et l'ingénierie des données structurées et non structurées, et qui se combine avec les autres offres existantes de Google Cloud pour construire un lakehouse.

Un catalogue API REST tout neuf

La première mise à jour a pris la forme d'un nouveau catalogue d'API REST pour metastore de BigLake - un service de métadonnées managé et unifié qui garde des informations sur les données stockées dans le data lake d'une entreprise et les rend disponibles pour l'analyse sans redondance. Michael Ni, analyste principal chez Constellation Research, a déclaré que le nouveau Rest API Catalog offrira aux développeurs un moyen programmable et neutre d'interagir avec les services de métadonnées, ce qui facilitera l'intégration de BigLake avec des flux de travail personnalisés, des pipelines CI/CD et des moteurs d'analyse autres que ceux de Google. Selon Sanjeev Mohan, analyste en chef chez SanjMo, REST API Catalog pourrait aider les entreprises à réduire leurs coûts. « Par exemple, si une entreprise souhaite utiliser les données de Snowflake pour l'analyse, elle doit utiliser le moteur de calcul de Snowflake. Mais désormais, un développeur peut utiliser DuckDB en open source pour analyser les données Snowflake à l'aide du catalogue d'API REST d'Iceberg et réduire les coûts », a déclaré M. Mohan. Le catalogue d'API REST est actuellement en avant-première.

Des performances SQL revues en hausse

La deuxième série de mises à jour, qui se concentre sur l'amélioration des performances analytiques SQL, a été ajoutée à BigQuery, une offre d'entrepôt de données géré de Google. Ces mises à jour, qui sont toutes des améliorations presque automatiques du moteur SQL, comprennent le moteur d'exécution avancé BigQuery, une API de requête à faible latence, l'indexation des métadonnées des colonnes et une accélération d'un ordre de grandeur pour les mises à jour et les suppressions à grain fin en avant-première. Le moteur d'exécution avancé BigQuery, qui est actuellement en bêta, peut automatiquement accélérer les charges de travail analytiques, en utilisant une vectorisation améliorée et un mode optimisé pour les requêtes courtes, sans nécessiter d'action de la part de l'utilisateur ou de modification du code, a écrit Google dans un billet de blog. Afin d'améliorer encore l'efficacité des requêtes, le fournisseur a ajouté l'index de métadonnées de colonnes BigQuery (CMETA), qui a été mis à la disposition de tous, et qui aide à traiter les requêtes sur les grandes tables grâce à un élagage des données géré par le système et plus efficace.

Toutefois, M. Mohan a souligné que Microsoft et AWS proposaient déjà des offres similaires. Alors que le premier utilise dans Fabric des technologies propriétaires appelées VertiPaq et VertiParquet qui utilisent une version colonne en mémoire des données OneLake pour accélérer les requêtes interactives Direct Lake à l'aide des clients PowerBI, le second a continué à introduire des améliorations telles que les balayages vectorisés, l'encodage de dictionnaire pour les colonnes de chaîne et l'optimisation automatique des tables dans Redshift, a déclaré M. Mohan. La firme de Redmond a également introduit récemment la mise en miroir des métadonnées dans OneLake via Fabric pour accélérer les requêtes Databricks. De son côté, la société de Mountain View a également ajouté un nouveau Lightning Engine pour améliorer les performances de son module Apache Spark - il est actuellement en avant-première. « Le Lightning Engine accélère les performances d'Apache Spark grâce à des connecteurs de données hautement optimisés pour le stockage Cloud Storage et BigQuery, à des opérations efficaces de mélange de colonnes et à des mécanismes intelligents de mise en cache intégrés », indique Google dans son billet de blog. Le fournisseur prévoit que son Lightning Engine procure des performances Apache Spark 3,6 fois supérieures à celles de son prédécesseur.

L'analyste en chef d'Amalgam Insights, Hyoun Park, a souligné que les améliorations de performance apportées aux composants Lakehouse sont le moyen pour Google de résoudre un problème fondamental lié à l'utilisation d'Apache Iceberg comme format de table ou à l'exécution de Spark dans un Lakehouse, en particulier à l'ère de l'IA. « L'IA nécessite fondamentalement un accès plus rapide à des sources de données plus distribuées et à un contexte approprié. Bien qu'Iceberg soit considéré comme un standard de lac de données, il a souvent du mal à gérer les petites modifications, les mises à jour de métadonnées et les volumes transactionnels nécessaires pour être une solution hautement performante », a déclaré M. Park. « Les mesures prises par Google vont dans le sens de ce qu'il pense être important pour les entreprises lorsqu'il s'agit d'améliorer les performances. »

Les capacités de Gemini intégrées au catalogue de données universel de Dataplex

Google intègre également les fonctionnalités de Gemini dans le catalogue de données universel Dataplex. Selon le fournisseur, les dernières capacités du catalogue basées sur l'IA aideront les entreprises à préparer leurs données sans travail manuel en découvrant et en organisant automatiquement les métadonnées. L'automatisation de la découverte et de la gestion des métadonnées aidera les entreprises à accroître la précision des applications d'IA et d'agentique, a déclaré M. Mohan. « Les modèles ont besoin de données en temps réel et d'un catalogue pour rechercher la sémantique afin de réduire les hallucinations. Le catalogue universel de Dataplex intégré au lakehouse remplit efficacement cette fonction », a ajouté M. Mohan.

Commentaire