Il vous reste 90% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

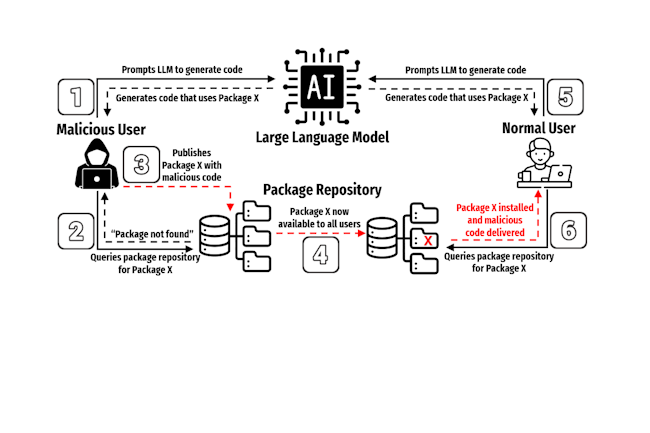

Des chercheurs ont découvert une technique où des attaquants peuvent utiliser et distribuer des paquets recommandés mais surtout inventés par des modèles IA.

Il vous reste 90% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire