Le cloud est un mode de déploiement qui autorise le droit à l’erreur et permet de facilement tester la viabilité d’un projet.

Choisir les bon cas d’usage

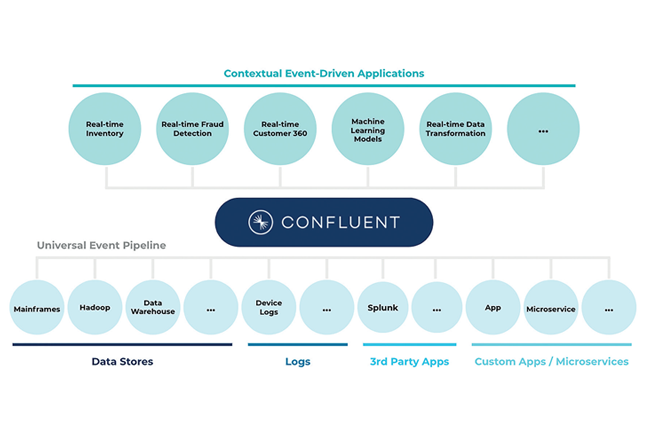

Prédiction des ruptures de stock via l’analyse des tickets de caisse dans la grande distribution, exploitation des données à des fins de lutte contre la fraude dans le secteur bancaire, recommandations de produits en temps réel, ultra-personnalisation des contenus et enrichissement de l’expérience utilisateur grâce à l’analyse de son parcours dans le ecommerce… Chaque secteur d’activité recèle de nombreuses opportunités en matière d’exploitation des données. Le premier enjeu est de savoir identifier les meilleurs cas d’usage dans votre contexte métier. « L’event streaming est un sujet tendance » prévient Rémi Forest. « Il peut être tentant de se lancer dans ce type de projet mais il est essentiel d’avoir préalablement fait le point sur les compétences internes et évalué le ROI ».

Localiser les données

Provenant de multiples sources dans de nombreux formats, dispersée dans différents systèmes, la donnée est à la fois omniprésente et insaisissable. « La localisation des données à valeur et la faculté à y accéder efficacement est un point crucial lors du démarrage d’un projet data » explique Rémi Forest. On doit être en mesure d’identifier et de rassembler les données les plus pertinentes pour alimenter les cas d’usage préalablement définis, en poussant l’investigation au-delà des données immédiatement accessibles, quitte à explorer des données externes présentes chez les partenaires ou fournisseurs.

Maintenance prédictive, prédiction de fraudes, amélioration de l’expérience utilisateur… De plus en plus d’entreprises utilisent la plateforme Confluent pour tirer parti de grandes quantité de données en provenance de sources hétérogènes.

Choisir les bons partenaires pour son projet cloud

Après avoir identifié clairement les objectifs se pose la question de l’implémentation. Au-delà de ses bénéfices en termes de time to market, de coût et d’agilité, « le cloud est un mode de déploiement qui autorise le droit à l’erreur et permet de facilement tester la viabilité d’un projet » note le consultant. Les phases itératives étant accélérées, on peut cerner facilement ce qui apporte de la valeur et décider par la suite de passer à l’échelle.

Intégrer les contraintes règlementaires et opérationnelles

Après avoir cerné les bénéfices des technologies telles qu’Apache Kafka, les opérationnels ne tardent généralement pas à avoir des idées. Se pose cependant la question de leur faisablité en termes techniques, mais également d’un point de vue de la gouvernance d’entreprise. « A l’heure du RGPD, il faut bien faire la part des choses entre ce que l’on veut faire, ce que l’on a le droit de faire et ce que l’on a intérêt à faire » résume Rémi Forest. Là encore, le recours à une plateforme « as a service » accélère et simplifie les projets en confiant la charge de l’exploitation au prestataire cloud.

Ne pas sous-estimer le maintien en condition opérationnelle

Communication entre les stacks de technologies, monitoring des solutions, mécanismes de trouble shooting… Si la construction d’une solution event-driven basée le cloud ou les services managés évite d’avoir à se soucier du fonctionnement de chaque brique technologique, l’entreprise doit tout de même conserver sa part de responsabilité en s’équipant des bons outils, des bons process et en s’assurant d’avoir les compétences pour délivrer correctement les cas d’usage.