La plateforme de streaming d'événements complète pour Apache Kafka®

Confluent, fondée par les créateurs de l'open source Apache Kafka®, fournit la seule streaming platform qui permet aux entreprises de maximiser la valeur des données.

Confluent Enterprise permet aux leaders d'industries, telles que la vente au détail, la logistique, la fabrication, les services financiers, la technologie et les médias, de déplacer des données de systèmes isolés vers un pipeline de données en temps réel où ils peuvent immédiatement agir.

A LA UNE

Ebook : Faire de la gestion des données en temps réel un avantage concurrentiel

Le streaming événementiel permet de déployer de nouveaux cas d’usage. Quels sont les bénéfices de cette technologie sur le terrain ?

Cet ebook présente les apports du streaming événementiel, ses grands cas d’usage et sa traduction opérationnelle à travers trois retours d’expérience.

Simplifier l'intégration d'Apache Kafka dans votre environnement : enjeux et mise en oeuvre

L'intégration d'Apache Kafka avec d'autres systèmes est un élément clé d'une plateforme de streaming événementielle. Comment faire entrer et sortir des flux de données au sein de la plateforme de streaming Kafka ?

Zoom sur les méthodes et outils existants pour simplifier l'intégration d'Apache Kafka avec d'autres systèmes.

Projets d'event streaming avec Kafka streams : de la théorie à la pratique

Dans un contexte de compétitivité accrue, les entreprises sont tiraillées entre des exigences difficilement conciliables : accélérer le déploiement des applications, tout en maîtrisant les coûts et en répondant à des standards de qualité toujours plus élevés.

Cet article propose une série de conseil pour repenser son SI et s'engager dans une démarche cloud native

Comment les entreprises du manufacturing tirent profit du streaming de données pour se moderniser ?

Le secteur industriel ne cesse d’évoluer en adoptant des technologies avancées favorisant l’amélioration du contrôle de la qualité, permettant de réaliser d'énormes gains d'efficacité, le tout avec des coûts réduits et des contrôles environnementaux supérieurs.

Mais l’IIoT, la 5G, les capteurs et les plateformes IoT, l'edge computing, l'IA et la robotique, les blockchains ou encore la réalité virtuelle ou augmentée, transforment radicalement ce secteur.

10 mn pour découvrir une fonctionnalité de Confluent

WEBCAST À LA DEMANDE

Les bénéfices du Streaming de données: Cas d'usage autour d'Apache Kafka

Découvrez comment les entreprises utilisent les architectures événementielles pour transformer leurs activités et comment Apache Kafka sert de base aux applications de données en continu.

Apprenez comment les principaux acteurs du marché utilisent Kafka dans un large éventail de cas d'usage tels que les microservices et l'IoT, les activités bancaires de base et la détection des fraudes, la collecte et la diffusion de données en ligne, le remplacement des ESB, la mise en pipeline des données, le commerce électronique, le déchargement des serveurs centraux, etc..

L'architecture d'Apache Kafka et ses principes fondamentaux expliqués

Cette session décrit la conception interne et l'architecture d'Apache Kafka. Des entreprises telles que LinkedIn envoient aujourd'hui plus d'un trillion de messages par jour via Apache Kafka. Découvrez la conception sous-jacente de Kafka qui permet d'obtenir un débit si élevé.

Comment fonctionne Apache Kafka ?

Découvrez les meilleures pratiques pour développer des applications avec Apache Kafka, à partir d'un aperçu du code de haut niveau pour un producteur et un consommateur de base. Nous aborderons ensuite les stratégies de création de puissantes applications de traitement des flux, notamment la haute disponibilité par réplication, la conservation des données, la conception des producers et leurs garanties.

Intégrer Apache Kafka dans votre environnement

L'intégration d'Apache Kafka avec d'autres systèmes de manière fiable et évolutive est un élément clé d'une plate-forme de streaming événementielle. Cette session vous montrera comment faire entrer et sortir des flux de données de Kafka avec Kafka Connect et REST Proxy, maintenir les formats de données et assurer la compatibilité avec Schema Registry et Avro, et construire des applications de traitement de flux en temps réel avec Confluent KSQL et Kafka Streams.

Kafka streaming appliqué à l’information voyageur en temps réel de la RATP

La RATP a lancé un programme de modernisation des systèmes d’information des voyageurs en temps réel avec un socle devant alimenter l’ensemble des médias du groupe.

Aymeric Aufray, responsable d’entité chez RATP et Vang Ngu Vo, chief technical officer à l’Usine Digitale de la RATP expliquent l’usage de Kafka au sein de la RAPT pour répondre aux besoins de l’information des voyageurs.

Découvrez notamment les enjeux du groupe, l’usage de la solution Kafka au sein de leur SI ainsi que les perspectives du streaming de données pour la RATP.

Event-driven architecture et systèmes intelligents chez Michelin

Aujourd’hui plus que jamais, les entreprises doivent être digitales et réactives face à un environnement incertain et évolutif. Des systèmes d’information réactifs, adaptatifs et smart, comme Kafka, permettent de combiner l’approche orientée événements avec des systèmes d’information exponentiels.

Dans cette vidéo, Yves Caseau, CIO chez Michelin nous explique les ambitions du groupe en termes de data driven et l’importance de l’event-driven architecture, donc Kafka, pour Michelin, et enfin, en quoi cette approche par événement permet de créer des systèmes adaptatifs.

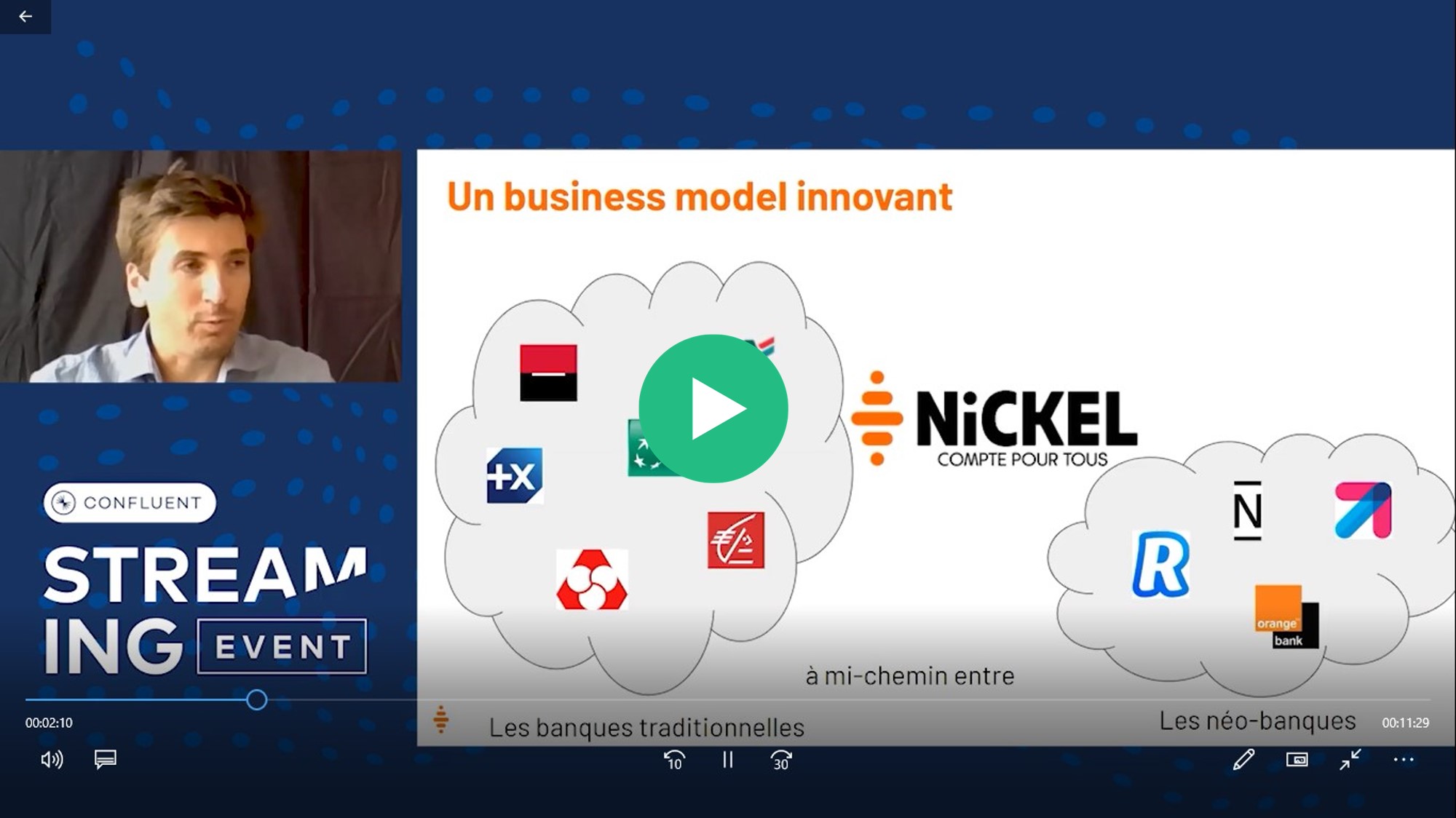

Usage de Kafka dans une néo banque

A mi-chemin entre les banques traditionnelles et les néo-banques, Nickel fait face à de nombreux challenges : instantanéité des actions et des notifications, disponibilité d’information pour les tiers et l’entreprises, intégration de solutions tierces et partenaires…

Découvrez dans cette vidéo l’usage de la solution Kafka et de la plateforme Confluent par Nickel. Guillaume Leclerc & Martial Renaud, tous deux chez Nickel nous expliquent leur entreprise et les transformations en cours et à venir de leurs systèmes d’informations.

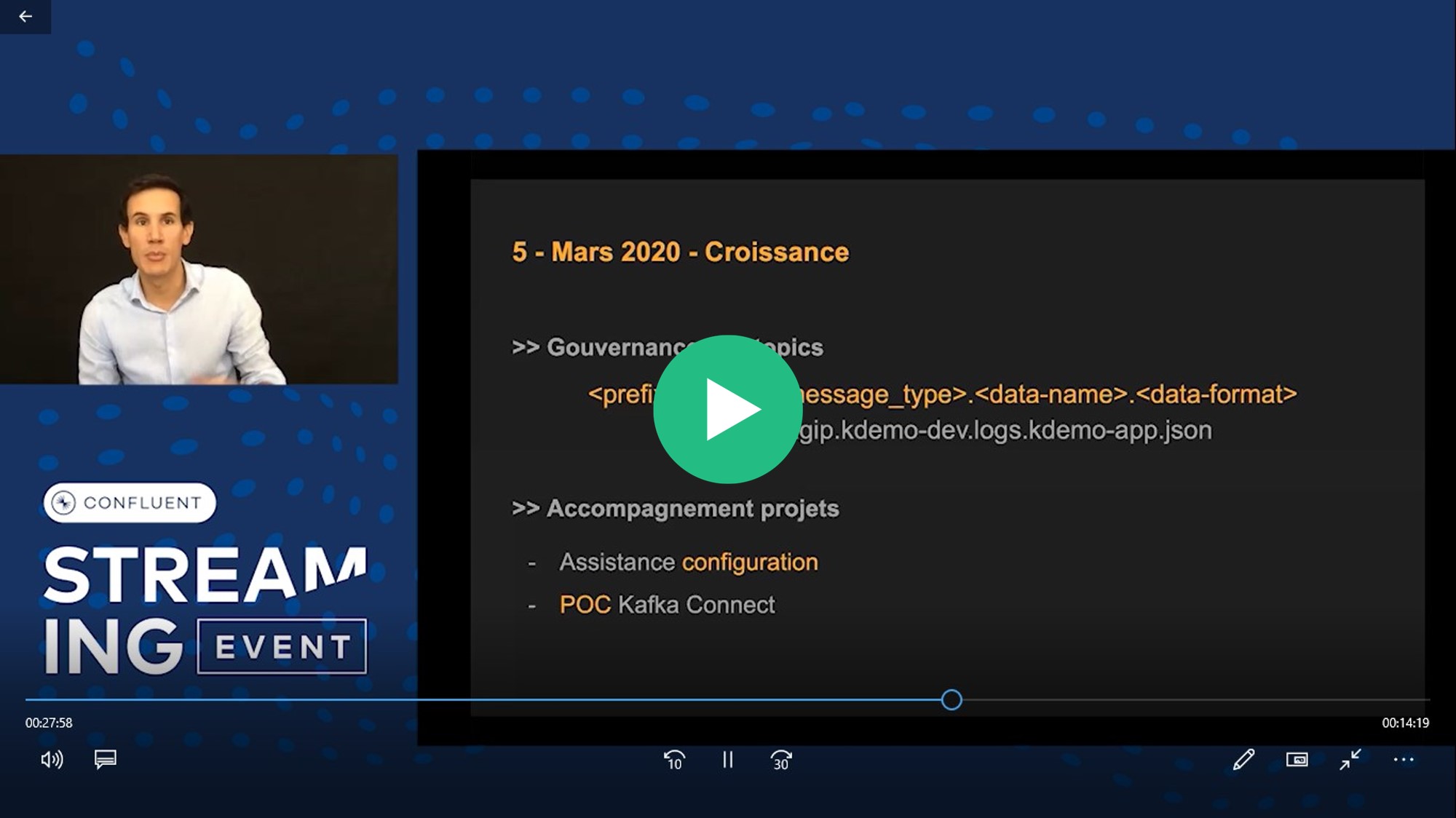

L’offre topic-as-a-service au Crédit Agricole

Aujourd’hui, il est important de profiter des technologies pour créer de la valeur pour les entreprises. Dans cette vidéo, Julien Legrand, tech lead, Squad Fast Data et Florian Courouge, consultant chez Squad Fast Data & devOps, tous deux en mission au Crédit Agricole nous font découvrir l’offre topic -as-a-service, 60 brokers répartis sur 14 clusters différents, mise en place au Crédit Agricole.

Découvrez, Kafka une offre utile pour les besoins techniques et métiers, stable en production et scalable

Topic as a Service : Gouvernance & Industrialisation

Dans un environnement distribué, organisé en Squads spécialisées.

Comment améliorer l’expérience du développeur, tout en garantissant une gouvernance commune?

Dans ce Webinar, venez découvrir comment on essaye de répondre à ce besoin, sur notre plateforme Topic as a Service au sein d'Adeo.

4 cas d’usage concrets pour comprendre le streaming de données

Avec l'avènement des systèmes de traitement des flux, la façon dont nous traitons les données a complètement évolué devant la nécessité de répondre aux exigences modernes.

Aujourd’hui, les plateformes de streaming de données en temps réel telles que Confluent sont utilisées dans de nombreux domaines : gaming, détection de la fraude en temps réel, réseaux sociaux, plateformes boursières, suivi GPS, etc.

Comment représenter graphiquement vos pipelines streaming de données ?

Les approches traditionnelles d’intégration de données possèdent leurs limites car les données doivent être téléchargées par paquets avant de pouvoir être exploitées. À l'inverse, le data streaming permettent un traitement, un stockage et une analyse simultanés et en temps réel. Les entreprises se tournent donc de plus en plus vers le streaming de données leur permettant ainsi d’accélérer l’utilisation et l’analyse de leurs données.

Créer l'infrastructure de données de demain grâce aux streaming de données

Avec le big data, le traitement de la donnée est devenu l’un des défis majeurs des entreprises ; entre besoin de données en temps réel et gestion d’un large volume de données.

Au vu de ces défis, comment les flux de données peuvent être traités, stockés, analysés et exploités, en temps rééel au fur et à mesure qu’ils sont générés? Pour quelle valeur ajoutée ?