Flux RSS

HPC

138 documents trouvés, affichage des résultats 121 à 130.

| < Les 10 documents précédents | Les 10 documents suivants > |

(19/08/2009 15:14:25)

Nvidia entre plus encore dans le HPC avec le calcul algébrique

EM Photonics vient d'optimiser une bibliothèque de fonctions de calcul algébrique (Lapack) pour les cartes graphiques de Nvidia utilisant la technologie Cuda (Compute Unified Device Archictecture) de ce dernier. Ce système de parallélisation des traitements a permis au constructeur de transformer ses processeurs graphiques en outils de calcul scientifique. Il en a fait une gamme à part entière, appelée Tesla et réservée au HPC (calcul haute performance) le mettant ainsi à portée du plus grand nombre. La bibliothèque de fonctions portée par EM Photonics ajoute une pierre à cet édifice puisqu'elle est couramment utilisée dans la mécanique de structure, la physique du calcul ou l'electronic design automation (CAO électronique). Autant de disciplines utilisées davantage dans l'univers professionnel que le grand public auquel est habitué Nvidia. Selon le constructeur, Cula utilisé avec ses cartes Tesla devrait voir ses performances de calcul multipliées par 10 par rapport à une utilisation d'un seul quadricoeus classique, sans coprocesseur de calcul dédié. (...)

(31/07/2009 17:01:07)Les images 3D directement calculées sur un supercalculateur Blue Gene

Et si on pouvait se passer des processeurs graphiques pour obtenir la visualisation en 3D de larges volumes de données ? Des chercheurs de l'Argonne National Laboratory, un centre de recherches du ministère américain de l'Energie, se sont posés cette question et ont réussi à trouver un moyen de le faire, grâce à une technique logicielle de parallélisation.

Le but, expliquent-ils, était de supprimer un goulet d'étranglement traditionnel : en règle générale, une fois que le supercalculateur a compilé les données, celles-ci sont transmises à une ferme de calculateurs graphiques, qui se chargent de l'aspect visualisation. Dans ce processus, disent-ils, du temps et de l'espace disque sont gâchés.

A la place, les scientifiques ont exploité en parallèle les 160 000 coeurs de leur Blue Gene/P, un supercalculateur IBM de 557 Tflops (557 000 milliards d'opérations par seconde). « Nous avons été capables d'aller jusqu'à des volumes de 80 milliards de voxels », explique un des chercheurs (un voxel est l'équivalent dans un espace à trois dimensions du pixel pour la 2D ; il s'agit d'un mot-valise, formé par la concaténation de l'apocope de 'volume' et de l'aphérèse de 'pixel').

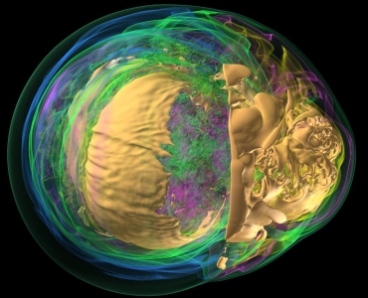

Pour démontrer leur savoir faire, les chercheurs ont ainsi calculé le rendu graphique en 3D de l'effondrement d'une supernova, créant ce qu'ils appellent « l'image la plus cool jamais créée sur un supercalculateur à l'Argonne National Laboratory » (cf. photo). (...)

Et si on pouvait se passer des processeurs graphiques pour obtenir la visualisation en 3D de larges volumes de données ? Des chercheurs de l'Argonne National Laboratory, un centre de recherches du ministère américain de l'Energie, se sont posés cette question et ont réussi à trouver un moyen de le faire, grâce à une technique logicielle de parallélisation.

Le but, expliquent-ils, était de supprimer un goulet d'étranglement traditionnel : en règle générale, une fois que le supercalculateur a compilé les données, celles-ci sont transmises à une ferme de calculateurs graphiques, qui se chargent de l'aspect visualisation. Dans ce processus, disent-ils, du temps et de l'espace disque sont gâchés.

A la place, les scientifiques ont exploité en parallèle les 160 000 coeurs de leur Blue Gene/P, un supercalculateur IBM de 557 Tflops (557 000 milliards d'opérations par seconde). « Nous avons été capables d'aller jusqu'à des volumes de 80 milliards de voxels », explique un des chercheurs (un voxel est l'équivalent dans un espace à trois dimensions du pixel pour la 2D ; il s'agit d'un mot-valise, formé par la concaténation de l'apocope de 'volume' et de l'aphérèse de 'pixel').

Pour démontrer leur savoir faire, les chercheurs ont ainsi calculé le rendu graphique en 3D de l'effondrement d'une supernova, créant ce qu'ils appellent « l'image la plus cool jamais créée sur un supercalculateur à l'Argonne National Laboratory » (cf. photo). (...)

Le système spécialisé de HPC Project met le calcul scientifique à portée des PME

La jeune société française HPC Project met sur le marché ses systèmes intégrés Wild Systems spécialisés dans le calcul haute performance. Cette offre est destinée à rendre les environnements de simulation accessibles aux PME. Pour atteindre cet objectif, la start up a misé à la fois sur un matériel couplant processeur et accélérateur graphique haut de gamme et sur un middleware Open Source de parallélisation des traitements sur de très grandes quantités de données. Ces systèmes « s'adressent plutôt à des entreprises qui n'ont pas d'équipes IT », précise Pierre Fiorini, PDG fondateur de HPC Project, et ne devraient coûter que quelques dizaines de milliers d'euros. Côté logiciel, la jeune entreprise se focalise sur la parallélisation de traitements identiques appliqués à des ensembles de données différents. Cette méthode est plus simple que la parallélisation de calculs différents qui, par ailleurs, convient particulièrement au traitement de très grandes quantité de données. Il s'agit par exemple de la simulation de phénomènes physiques, courante dans l'industrie, mais aussi d'applications comme le datamining qui applique des calculs statistiques à d'importants flots de données. Comme le rappelle Pierre Fiorini, ces environnements concernent « la finance, la médecine, les modèles statistiques, les biotechnologies (pour la représentation de phénomènes chimiques), les sciences de l'ingénieur (aéronautique, automobile, etc.) et même l'audiovisuel ». Un projet Open Source issu des travaux de l'Ecole des Mines pour la parallélisation HPC Project a choisi de s'appuyer sur un projet Open Source issu des travaux que mène l'Ecole des Mines depuis près de 20 ans. La jeune pousse a donc lancé une plateforme idoine avec le Centre de recherche informatique (CRI) de l'Ecole. Celle-ci analyse le code, identifie les parties qui peuvent être parallélisées et... les parallélise. HPC Project livrera des versions stabilisées et packagées de cet outil dont il assurera aussi le support. Le middleware sera utilisable aussi bien pour les OS que pour les applications. Pour alimenter son offre en logiciel de simulations, l'entreprise compte nouer des partenariats avec certains éditeurs du monde du HPC, à qui il proposera un accès privilégié à ses technologies. Certains sont déjà intéressés comme les canadiens Presagis (simulation multi-agents pour le secteur de la défense) et Parallel Geometry (modélisation), ainsi qu'un Français, spécialiste de la finance et du calcul scientifique, dont HPC Project ne dévoile pas encore le nom. Presagis proposera aussi l'offre de la jeune pousse française au travers de son propre réseau de distribution. Afin de ne pas voir les prix des ses systèmes flamber, HPC Project fait en sorte d'obtenir des accords de licence adaptés avec ces éditeurs. Un accélérateur graphique Tesla couplé avec deux Xeon 5500 Du côté matériel, la start up française a aussi misé sur l'originalité en concevant des systèmes composés de deux quadri-coeurs Xeon 5500 (Nehalem) d'Intel d'une part et un GPU Tesla de Nvidia d'autre part. Toute la stratégie matérielle de la jeune entreprise s'appuie sur ce couplage entre des puces standards et un processeur spécialisé sur lequel sont déportés les calculs intensifs. C'est justement pour assurer ce type de fonctions que le spécialiste du traitement graphique Nvidia a mis au point les Tesla, processeurs multi-coeurs (240 coeurs par processeur avec une architecture parallèle Cuda). A noter qu'avec de telles machines, HPC Project a dû intégrer la notion d'économie d'énergie Des ventilateurs spécifiques et un mode d'organisation des flux d'air limitent ainsi la dissipation de chaleur et la consommation électrique. Enfin, la jeune firme est à l'initiative d'un rassemblement d'acteurs de la simulation depuis la représentation d'images de synthèse jusqu'à la simulation de phénomènes aérodynamiques, par exemple. HPC Project Simbiosis a pour but de promouvoir l'usage de la simulation. Aujourd'hui, les membres sont plutôt des acteurs de petites tailles comme Optis (Toulon, représentation de la lumière), Presagis, Bionetics (simulation de comportement des plantes jusqu'à la représentation de grands espaces naturels), Realfusio (Représentation photoréaliste aéronautique), etc. Mais Intel, Nvidia et Microsoft font aussi partie de l'initiative. Pierre Fiorini assure par ailleurs être en discussion avec les entreprises françaises du secteur, comme Dassault Systèmes ou ESI. (...)

(16/06/2009 19:26:21)Bull propose un système HPC conçu pour la simulation

Le système HPC bullx annoncé aujourd'hui par Bull s'adresse à la clientèle bien particulière des entreprises friandes de simulation numérique. Ce type d'applications particulièrement complexe simule la réalité pour mieux la comprendre et est insatiable en ce qui concerne la puissance machine. Les utilisateurs potentiels sont aussi bien les industries automobile, l'aéronautique, l'exploration pétrolière, les finances, le nucléaire, les laboratoires scientifiques, la médecine, la climatologie, la défense, etc. La clientèle ne manque pas et son besoin en puissance est toujours croissant. « Un supercalculateur qui n'est pas utilisé aujourd'hui, ça n'existe pas, » insiste Fabio Gallo, responsable HPC de Bull. Après avoir examiné de près les besoins de ses clients, le constructeur français a opté pour des clusters Xeon 5500 qu'il a poussés dans leurs derniers retranchements. « Aucun compromis », selon Bull. Tous les moyens ont aussi été utilisés pour donner au système une performance énergétique optimale.

Bull a veillé aux exigences de ses clients HPC

Pour concevoir bullx en allant au-delà de la seule puissance, Bull a identifié une série de besoins auprès de ses clients. Pour commencer, ceux-ci veulent que le système soit capable d'une performance soutenue tout au long de l'exécution d'une application et pas uniquement d'une performance de crête, obtenue uniquement dans certaines conditions. Les entreprises sont aussi attachées à l'efficacité énergétique. Inutile de préciser que l'enveloppe énergétique d'un supercalculateur n'échappe pas à la forte croissance qui frappe toutes les infrastructures serveurs. De fait, pas question de gâcher le moindre watt.

Autre exigence des clients Bull dans le HPC, la protection de leur investissement. De telles infrastructures de supercalcul ne se changent pas tous les deux ans. Les technologies mises en place doivent donc être les plus avancées du moment. Les industriels et les laboratoires ont aussi interpellé le constructeur sur l'utilisation de technologies spécialisées pour l'accélération du calcul technico-scientifique. La performance des processeurs graphiques est ainsi désormais considérée comme intéressante d'autant qu'elle n'augmente que très peu la consommation électrique de l'ensemble du système. « Mais la facilité d'utilisation dans ces systèmes HPC n'était pas leur point fort, et nous devions travailler sur le sujet », précise Fabio Gallo. Enfin, tous les clients concernés ont exigé de Bull pour leur supercalculateur, la facilité d'installation, d'utilisation et de gestion, ainsi que la fiabilité.

Des lames purement Xeon 5500 et des lames avec GPU

« Nous avons donc tout simplement développé une nouvelle architecture, raconte Fabio Gallo. Elle est exclusivement conçue pour la simulation numérique, et de ce fait, elle est sans compromis. » Bull n'a pas souhaité faire de concession au supercalcul et à l'optimisation de la puissance pour garder une configuration qui pourrait servir à d'autres utilisations que la simulation. « Si on se frotte à l'optimisation de la performance, il faut une architecture idoine du système de mémoire, il faut utiliser le chipset le plus performant. A tout moment de la conception du système, nous avons gardé en tête la performance applicative et l'élimination de tous les goulets d'étranglement qu'elle implique. »

Les lames de bullx s'appuient sur l'architecture de processeur Xeon 5500 d'Intel (ex Nehalem). Mais Bull a donc choisi les puces les plus rapides de la gamme produites par Intel. « Nous avons aussi opté pour l'architecture mémoire la plus performante possible pour les noeuds, détaille Fabio Gallo. Nous installons des Xeon 5500 avec le nombre maximum de canaux de mémoire, c'est à dire 3 par processeur, et avec 2 barrettes par canal. » Mais l'innovation principale du système réside dans le mélange, dans les mêmes armoires, de lames traditionnelles contenant uniquement des Xeon 5500 avec des lames spécialisées intégrant à la fois le processeur d'Intel et un GPU (Graphical processor unit) Nvidia. « L'intégration des deux parties peut être le point qualifiant du système », insiste Fabio Gallo. Il s'agit en effet pour l'entreprise utilisatrice du système de trouver le bon point d'équilibre en fonction de ses applications. Les processeurs graphiques sont connectés via une interface PCI Express et l'architecture des lames est conçue pour que la bande passante entre les deux puces, standard et graphique, soit maximale. « Normalement, il n'y a qu'un chipset pour le serveur, et les deux processeurs bisockets utilisent le même, détaille Fabio Gallo. Pour nos lames spécialisées, nous utilisons deux chipsets pour que chaque processeur ait un accès dédié vers l'accélérateur. »

Le commutateur Infiniband directement dans le fond de panier

Comme toute médaille a son revers, ce type d'architecture totalement nouvelle implique pour être utilisé au mieux la mise au point de nouvelles applications spécifiques ou le portage des anciennes. « Sur les lames accélérées, nous travaillons depuis un an au portage et à l'optimisation des applications avec nos clients, confirme Fabio Gallo. Pour certaines applications bien structurées, nous pouvons obtenir un facteur d'accélération de 10. Il faut identifier les parties de code qui se prêtent à ce type d'accélération, ensuite il faut procéder à leur portage et à leur compilation avec des méthodes légèrement différentes sur l'accélérateur. »

[[page]]

Bull propose un système HPC conçu pour la simulation

Page précédente : 1/2

Le choix des processeurs n'est pas la seule amélioration du système. Ainsi, le commutateur Infiniband est-il intégré directement dans le fond de panier et non pas installé en tant qu'élément isolé. Un moyen évident d'économiser de l'espace et de limiter le câblage, mais pas seulement. Les performances devraient là encore être au rendez-vous, et également améliorées. Pour commencer, la distance entre le commutateur et les serveurs est réduite. « Les réseaux très haut débit sont aussi très sensibles au rayon de courbure des câbles, rappelle Fabio Gallo. Si une intervention doit avoir lieu sur le système, leur manipulation peut avoir un impact sur la fiabilité. » Le réseau Infiniband est utilisé en mode QDR (Quad Data Rate), le plus performant actuellement disponible.

La suite d'administration s'appuie sur des briques libres

Enfin, avec un système aussi complexe, une suite d'administration s'imposait. Bull en a mis une au point qui s'appuie en majorité sur des composants libres. Cet outil réduit la complexité du cluster en proposant un point de contrôle unique pour le matériel. La base d'inventaire Cluster DB recense tous les composants du cluster et identifie précisément, en cas de problème, quel câble ou quelle barrette mémoire sont concernés.

Au final, chaque châssis (7U) contenant 18 lames bullx peut atteindre près de 1,7 Tflops. Dans chaque châssis, on compte une rangée de 8 lames et une rangée de 10 dont les commutateurs, les écrans, les ventilateurs. « Le nombre de 18 n'a pas été choisi au hasard, précise d'ailleurs Fabrice Gallo. Le commutateur Infiniband QDR dispose de 36 ports, soit 18 entrées et 18 sorties. » Là encore, il s'git d'optimiser. Chaque armoire (42U) peut accueillir jusqu'à 6 châssis et représentera une puissance totale d'environ 10 Tflops.

Une porte de refroidissement à l'eau

Economie et écologie obligent, de telles configurations, aussi puissantes, ne se conçoivent plus sans optimiser la consommation électrique et la gestion thermique. Pour limiter à la fois la dissipation de chaleur et éviter les systèmes de climatisation chers et consommateurs d'énergie, Bull, comme IBM l'a déjà fait, remet au goût du jour les systèmes de refroidissement à eau. Il installe des portes à eau à l'arrière des armoires (qui consomment jusqu'à 40 kW). La chaleur est absorbée par ces portes et est transmise par un fluide. Ces cloisons intègrent par ailleurs des capteurs et des systèmes de contrôle qui permettent aux ventilateurs de marcher ou pas. Ce sont eux qui renvoient l'air dans la salle à la même température que lorsqu'il est entré. Les ventilateurs servent à garantir que le flux d'air ne soit pas interrompu. Selon le constructeur français, ces éléments installés directement sur les systèmes sont, par essence, bien plus ciblés que le refroidissement complet de la salle qui héberge l'infrastructure. Un ciblage qui se traduirait par une efficacité accrue de près de 75% et une économie d'énergie augmentée d'autant. Par ailleurs, le système devrait pouvoir supporter une température de ... 35°C. L'absence de panne reste à prouver, dans ce cas.

Survivre à des 'burn out'

Des dispositifs intégrés permettent aussi aux lames de survivre à des 'burn out' ce qui évite de faire appel à des onduleurs, appareils qui introduisent selon Bull entre 10 et 20% de perte de la puissance électrique. Les 'burn out' sont des interruptions d'alimentation de quelques fractions de secondes qui sont à l'origine des pannes non prévues les plus fréquentes des systèmes. Le dispositif qui pallie ce problème est un condensateur avec un système de contrôle qui intervient en cas de microcoupure. Les noeuds de calcul qui représentent 90% de la puissance électrique consommée par la configuration continuent de fonctionner, même sans onduleur. Seuls les noeuds destinés à l'administration restent équipés d'onduleurs, mais leur consommation représente un faible pourcentage.

Pour ce qui est du prix, les estimations sont toujours particulièrement difficiles avec ce style de configurations modulaires et haut de gamme. « Sur des systèmes départementaux, modestes, on peut démarrer en dessous de 100 000 euros, et pour les plus grands systèmes, on atteindra plusieurs dizaines de millions d'euros », précise néanmoins Fabio Gallo... Le premier client bullx est l'Université de Cologne en Allemagne. (...)

Les grandes infrastructures de recherche au service d'une science pluridisciplinaire

« Parfois, on fait avancer la recherche pure et on trouve des applications sociétales évidentes », a réaffirmé Catherine Cesarsky, haut-commissaire à l'énergie atomique, en clôture du salon européen de la recherche et de l'innovation (Seri) qui s'est tenu à Paris du 3 au 5 juin dernier. A ses côtés, pour illustrer la façon dont « les grandes infrastructures de recherche sont à l'écoute des enjeux d'aujourd'hui pour répondre aux besoins de demain », Jean Audouze, président du comité d'organisation scientifique du Seri, avait également réuni Dany Vandromme, directeur du GIP Renater, et Robert Aymar, conseiller de l'administrateur général du CEA et ancien directeur général du Cern. Rendre les données accessibles aux chercheurs du monde entier Question concrète, les intervenants se sont interrogés sur la meilleure façon de rendre accessibles aux chercheurs, les données recueillies dans ces grandes infrastructures. Le réseau national de communication Renater permet à un millier d'établissements de communiquer entre eux et d'accéder aux centres de recherche du monde entier. Le réseau Geant de son côté, assure la même fonction au niveau européen. Directeur de Renater, Dany Vandromme est également responsable des grandes infrastructures à la direction de la recherche et de l'innovation du ministère de la recherche. A ce titre, il s'intéresse à leur mise en réseau. Dans le cadre du projet LHC, par exemple, « le Cern ne pouvait pas être le lieu pour stocker les données recueillies, beaucoup trop volumineuses ». Cela aurait été trop coûteux pour le centre de recherche installé dans la région de Genève. [cf « L'informatique monumentale derrière l'accélérateur de particules du CERN » : pour gérer les 15 millions de milliards d'octets qui sortiront chaque année des essais du LHC, l'infrastructure serveur compte trois niveaux : le premier se situe au Cern, le deuxième s'appuie sur onze centres informatiques dans le monde et le troisième sur une centaine d'autres centres distribués.] « Ces informations sont diffusées dans les centres de physique distribués dans le monde entier, indique Dany Vandromme. Un autre système consiste à organiser une prise de données distribuées vers un point central corrélateur puis de redistribuer les données, mais cela ne tient plus la route car la concentration est trop forte. On pense maintenant à des centre de corrélation eux-mêmes distribués dans le monde entier. » Dany Vandromme rappelle que les infrastructures de recherche ne sont plus aujourd'hui ciblées sur quelques disciplines historiques. La science est de plus en plus pluridisciplinaire. « Toutes les communautés scientifiques ont besoin de cette mise en commun des moyens. Ces infrastructures distribuées, c'est un vrai progrès que l'on est en train de réaliser. » Et Robert Aymar de conclure que ces infrastructures ne pourront plus êtres limitées à des périmètres nationaux : « Ces réseaux amènent à un concept d'ouverture en matière de nationalités et de disciplines. » Il faut que les jugements de la société deviennent plus scientifiques [[page]] « Les logiciels utilisés pour l'astronomie ont des applications dans la médecine », a par exemple cité Catherine Cesarsky en soulignant que le CEA travaillait depuis 30 ans sur l'imagerie cérébrale. « Il faut repousser à l'extrême les limites de l'imagerie, augmenter le champ magnétique de l'imageur... ». D'où l'intérêt dans ces domaines d'échanger des techniques avec des grands laboratoires de recherche comme le Ganil en Basse-Normandie, ou le Cern en Suisse, qui disposent d'accélérateurs de particules, en particulier à Genève, le LHC (Large Hadron Collider). Les participants à la table ronde de clôture du Seri ont également évoqué la façon dont la société est impliquée dans ces grandes infrastructures de recherche « où l'on trouve une variété d'instruments tous plus futuristes les uns que les autres », a rappelé Jean Audouze. Pour Robert Aymar, qui dirigea le projet ITER, réacteur thermonucléaire expérimental international, « les implications des grandes infrastructures de recherche dépassent la science car elles deviennent politiques. Nos gouvernements ont décrété que l'économie européenne serait basée sur la connaissance. Cela réjouit les scientifiques qui peuvent suivre des stratégies répondant aux besoins de la société, avec par exemple de nouvelles sources d'énergie de type ITER. » Ces scientifiques ont une responsabilité vis-à-vis de leurs égaux, estime l'ancien directeur du Cern. « Il faut que la société et ses jugements deviennent plus scientifiques. Il faut expliciter pourquoi des grandes infrastructures sont nécessaires à la science ». Il rappelle que les retombées de ces recherches ont pour objectif d'améliorer la compétitivité des économies. Robert Aymar juge aussi que ces infrastructures ont un rôle dans la cohésion européenne : « Les pays qui rejoignent l'Union européenne ont toujours fait un séjour au Cern pour comprendre les enjeux. Ces grandes infrastructures sont aussi un lien avec la connaissance mondiale. » Des choix politiques pour préparer l'avenir De son côté, Dany Vandromme, directeur du réseau Renater, tient à remettre en mémoire que la mise en place et les programmes menés dans ces infrastructures se déroulent sur des échelles temps très longues. Pour ITER, il renvoie d'ici quinze à vingt ans. Pour le système énergétique basé sur la fusion nucléaire, il s'agit plutôt d'une petite centaine d'années. « Il y a néanmoins des choix politiques à faire aujourd'hui pour préparer l'avenir », reconnaît-il. Ce que confirme Robert Aymar : « Pour un accélérateur comme le LHC, le délai est très long entre les discussions, la décision d'engager les dépenses et l'exploitation elle-même. C'est pourquoi ces grands investissements posent un problème fondamental : comment limiter le risque pour que ce soit un succès. » (...)

(27/05/2009 18:02:06)Un supercalculateur européen devient le 3e plus puissant du monde

Le haut du Top 500 des plus puissants super calculateurs est traditionnellement occupé par des monstres américains. Pourtant, Jugene, installé au centre de recherche allemand Forschungszentrum Jülich devrait se hisser de la 11e place jusque sur la 3e marche du podium à l'occasion du prochain classement fin juin. La machine vient d'être mise à jour par IBM et est désormais animée par un total de près de 295 000 processeurs PowerPC 450 à 850 MHz installés par quatre sur des Blue Gene/P. Il devient ainsi également le troisième supercalculateur au monde à atteindre le Petaflop (un million de milliards d'opérations en virgule flottante à la seconde). Le centre de recherche de Jülich spécialisé dans la physique et le supercalcul s'appuie sur cette ressource de taille pour ces travaux dans les domaines de la santé, de l'énergie et de l'environnement. Ce beau bébé nécessite d'ailleurs qu'on l'alimente avec une puissance électrique de 2,2 Mwatts. Jugene est installé aux côtés de deux autres supercalculateurs, dont JuRoPa (Jülich Research on Petaflops Architectures) constitué de serveurs Bull et Sun à base de Xeon 5570. (...)

(22/04/2009 12:52:02)Sun-Oracle : les technologies convoitées, les abandons possibles

Java et Solaris sont les deux principales raisons pour lesquelles Oracle a racheté Sun, de l'aveu même de son PDG Larry Ellison. Dans ces conditions, on peut s'interroger sur le devenir des processeurs Sparc, des serveurs, du stockage ou de la gestion des identités. On peut aussi se demander comment OpenSolaris et Java mobile évolueront. Et quid de la cohabitation entre les SGBD Oracle et MySQL ? Solaris et OpenSolaris Oracle supporte Solaris depuis de nombreuses années. Pour Larry Ellison, ce système d'exploitation est « de loin la meilleure technologie Unix du marché ». Et même si l'offre matérielle de Sun n'a pas le poids de celle d'IBM, Oracle va pouvoir constituer un modèle matériel/logiciel qui se rapproche de celui de Big Blue, son concurrent sur le marché des bases de données. « Nous allons intégrer étroitement Oracle Database avec les fonctions haut de gamme spécifiques à Solaris », a promis Larry Ellison qui parle de livrer des solutions complètes, « de la base de données jusqu'aux disques ». Une méthode en vogue si l'on observe les annonces récentes de datacenters intégrés de Cisco et HP. Oracle est un fervent partisan de Linux et les analystes se demandent s'il n'envisage pas une harmonisation avec OpenSolaris, la version libre et gratuite de Solaris. Il y a deux semaines, Edward Screven, architecte en chef et spécialiste de Linux chez Oracle, déclarait qu'Oracle aimerait que Linux devienne l'OS par défaut des datacenters, pour que la question ne se pose plus. Pour David Mitchell, analyste chez Ovum, il est pourtant tout à fait improbable, qu'Oracle lâche la version commerciale de Solaris pour Linux, en raison notamment des revenus de maintenance et de services qu'elle génère. « C'est une activité extrêmement profitable, précise-t-il ». Il prédit qu'Oracle continuera à faire évoluer Solaris, plus adapté aux applications critiques, notamment dans le secteur des télécommunications. Toutefois, selon David Mitchell, l'apport de certaines fonctions d'OpenSolaris à Linux est une option sur laquelle les développeurs ont déjà travaillé. Pour l'instant, les licences des deux OS restent incompatibles, comme le note Stephen O'Grady, analyste chez RedMonk (CDDL pour l'un, GPL pour l'autre), mais Oracle pourrait modifier celle d'OpenSolaris pour permettre un transfert de fonctions entre les deux. Java mobile Parlant de Java, le patron d'Oracle considère qu'il s'agit de « l'actif le plus important » jamais racheté par sa société. Ni plus, ni moins. Il a déclaré que, désormais, l'activité Oracle Fusion middleware basée sur Java, déjà renforcée par l'acquisition de Bea, est sur les rails pour devenir aussi importante pour Oracle que son activité base de données. Mais c'est l'utilisation de Java en entreprise qui l'intéresse le plus. A l'inverse, la plateforme Java mobile ne sera sans doute pas une priorité, comme le subodore l'analyste Jack Gold, de J.Gold Associates, en ajoutant qu'elle ne l'était déjà pas pour Sun. Le rôle de Java dans les téléphones portables pourrait décliner à mesure que baisseront les prix des Smartphones qui les remplaceront, même si cela prend plusieurs années. La vague suivante arrivera avec la prochaine plateforme Java FX conçue pour les smartphones. Sparc Autre interrogation lourde, à la suite du rachat de Sun, le support de serveurs à base des processeurs Sparc du constructeur. Solaris étant disponible à la fois pour ces systèmes et ceux à base de x86. Jim McGregor, analyste chez In-Stat, rappelle que les parts de marché des systèmes Sparc se sont réduites au profit des serveurs sous Unix de HP et IBM. Le nouveau propriétaire de ces architectures pourraient ainsi arrêter le développement autour de ces processeurs spécifiques ou vendre l'activité. « Un certain nombre de ce type d'offres Unix se sont concentrées sur des marchés de plus en plus petits, tels que l'informatique haute performance, et cela n'a pas beaucoup de sens que trop d'acteurs s'investissent encore longtemps sur ces architectures », juge Jim McGregor. Et de citer Silicon Graphics et Cray qui sont passés sur des technologies x86, Intel ou AMD. Larry Ellison a d'ailleurs sous-entendu lundi que l'offre Solaris était plus importante que le Sparc. MySQL [[page]] MySQL Conséquence de taille de l'opération Oracle/Sun, la base de données Open Source la plus populaire du marché, MySQL, cohabitera avec Oracle Database, la base relationnelle qui génère le plus de revenus dans le monde. Cette dernière a rapporté 22 Md$ à son éditeur entre 2005 et 2007, soit plus du double des ventes de base de données DB2 du principal rival, IBM. De son côté, MySQL a été téléchargé plus de 100 millions de fois, selon Sun. Le constructeur avance 70 000 téléchargements quotidiens et 12 millions de bases en production, notamment chez Google, YouTube, Yahoo... Cette juxtaposition entraîne-t-elle une situation anti-concurrentielle ? Certes pas. Si Oracle Database joue bien un rôle de locomotive, « elle est loin de constituer un monopole », rappelle Curt Monash, de Monash Research Today. En 2007, Oracle s'octroyait 44,3% du marché des bases de données, mais IBM en détenait 21% et Microsoft 18,5%. Quant aux 38 M$ de revenus générés par MySQL en 2007, ils plaçaient l'acteur au 19e rang selon IDC, derrière des vendeurs comme Siemens, Unisys, Hitachi et même Apple avec Filemaker. Le risque d'un monopole aurait été autrement plus important, si IBM avait racheté Sun, sur le marché des serveurs sous Unix, leurs ventes combinées dans ce domaine atteignant 11,2 Md$. Kenneth Chin, analyste chez Gartner, rappelle que ce sont d'abord les revenus financiers que les autorités de régulation surveillent de près : « l'Open Source apparaît moins dans leur radar ». A propos de MySQL, Kenneth Chin pense que les clients les plus prompts à réagir pourraient donner de la voix si Oracle vient à hausser les tarifs de support. Mais il note aussi qu'Oracle ne s'est pas mêlé des processus de vente/marketing autour des bases Open Source qu'il a déjà rachetées, BerkeleyDB et InnoDB. Si Sun fonctionne comme une entité séparée, MySQL pourrait rester suffisamment loin d'Oracle pour ne pas être touché par d'éventuelles augmentations. Stockage Depuis septembre 2008, Oracle propose en collaboration avec HP la Database Machine, une solution matérielle conçue pour les applications de datawarehouse qui embarque des serveurs de stockage Exadata. Avec l'absorption de Sun, le voilà à même de réaliser d'autres systèmes de ce type. « La plateforme Open Storage de Sun est très similaire à la plateforme Exadata », a déclaré le président d'Oracle, Charles Phillips. Toutes deux utilisent des serveurs standards, des disques et des connexions InfiniBand ». Jim McGregor, du cabinet In-Stat, estime qu'Oracle a suffisamment d'envergure pour se permettre de débarquer ainsi sur le segment du matériel. Mais il reconnaît aussi que « ce n'est probablement pas la meilleure opportunité » pour la société de Larry Ellison. Gestion des identités Sun et Oracle font partie du Top 5 des solutions de gestion des identités avec IBM, CA et Novell. Ils ont tous deux procédé à des rachats qui entrainent aujourd'hui des recouvrements. Thor, Bridgesteam, Phaos, OctetString pour Oracle, Waveset et Vaau pour Sun, notamment. Ils ont aussi tous deux développé des produits dans le domaine (Sun Access Manager, Federation Manager, Role Manager...) « Oracle va devoir faire des choix délicats », entrevoit Jamie Lewis, président du Burton Group. Selon lui, le chevauchement le plus évident se situe sur les produits de gestion des accès et de réservation des ressources (provisioning). Andre Duran, PDG de l'éditeur Ping Identity, ne se prive pas d'un pronostic : « Déterminer ce qui doit rester [dans les deux catalogues], ce qui doit être abandonné et intégrer les éléments conservées va constituer une tâche énorme qui va immanquablement entraîner des conséquences pour les bases installées ». Pour compliquer les choses, sur les solutions d'annuaire Sun s'est résolument impliqué dans l'Open Source, lâchant du lest sur son offre Directory Enterprise Edition en faveur de la plateforme OpenDS. « Les produits se concurrencent, ils ne pourront pas tout garder, affirme sur ce point Don Bowen, qui a quitté Sun il y a à peine un an pour participer au lancement de UnboundID, une solution basée sur OpenDS. Cela dit, les produits de gestion des identités sont loin d'être stratégiques dans le rachat de Sun. (...)

(15/04/2009 11:23:30)Les serveurs Sun à base de Xeon 5500 intègrent le réseau

Faisant fi du capotage des négociations avec IBM, Sun continue son bonhomme de chemin en annonçant, à son tour, des serveurs Galaxy à base de processeurs Intel Xeon 5500 (Nehalem). Le constructeur tente de se démarquer en soulignant deux points de différenciation. Le premier concerne l'intégration de la dimension réseau dans les configurations et, le second, celle du stockage flash dans toutes ses machines. Quatre servers en rack et deux lames Six modèles de serveurs bi-Xeon sont présentés, quatre racks et deux lames. Les modèles lames acceptent tous les modèles de Xeon 5500 à l'exception du plus rapide, le W5580 (3,2 GHZ) en raison de la consommation de 130 watts de cette puce. Le Sun Blade X6270 est destinée aux environnements virtualisés. L'autre, le Sun Blade X6275, dopé par un port Infiniband Quad Data Rate (40 Gbis/s), s'adresse aux environnements HPC (High performance computing). Elle se compose de deux serveurs bi-Xeon 5500, chacun avec 96 Go de mémoire, soit la moitié de la capacité maximale des autres modèles annoncés par Sun. Sun a adapté Solaris aux Xeon 5500 et ZFS aux SSD Sun propose donc également quatre serveurs en rack dont deux sont au format 1U (X2270 et X4170) et deux autres au format 2U (X4270 et X4275). L'une des machines 2U est un module de stockage avec 12 baies 3,5 pouces pour des disques SATA ou SAS, soit une capacité maximale de 12 Go. Sun propose tous ces modèles avec des disques flash, de 24 Go pour les lames et 32 Go pour les racks. Sun précise qu'il a optimisé Solaris pour tirer profit de l'architecture des nouveaux processeurs d'Intel. Le gestionnaire de fichiers ZFS a aussi été adapté pour prendre en compte les disques électroniques. Côté réseau, Sun annonce deux lames, le Blade 6000 Virtual Network Express Module (NEM) en 10 Gigabit Ethernet (GbE) et le Sun Blade 6048 InfiniBand (IB) Quad Data Rate NEM (QNEM). Innovation intéressante, le Californien utilise les ports PCI-Express pour les interfaces réseau de ses serveurs et emploie une puce réseau maison. Au final, cela lui permet d'affirmer qu'il réduit de façon notable les besoins en câblage de ses serveurs. Sun souligne aussi le haut niveau d'intégration entre ses serveurs et ses composants réseau. S'il le compare à celui atteint par Cisco dans son offre UCS (Unified Computing System), il dit s'en démarquer par l'ouverture de son produit. Un discours qu'aucun élément matériel ne permet de justifier, les châssis et les lames des deux constructeurs étant tout aussi fermés les uns que les autres. (...)

(02/04/2009 17:02:30)Rackable Systems devrait acheter SGI, placé sous chapitre 11

A l'heure où le monde informatique piaffe d'impatience en attendant une probable vente de Sun à IBM, c'est un autre dinosaure du monde Unix qui disparaît. Achevé par la crise, SGI a été mis en faillite hier, 1er avril. Dans la foulée, le bien nommé Rackable Systems a offert de l'acheter pour 49 petits millions de dollars. SGI avait déjà été placé sous le chapitre 11, version américaine de la faillite, en mai 2006, mais s'en était alors sorti. Cette fois, la situation économique a eu raison du spécialiste du calcul haute performance avec affichage graphique 3D haut de gamme, déjà sur une courbe dangereusement descendante depuis des années. Le CA 2008 de SGI, un exercice fiscal clos en juin dernier, avait chuté de 24%. La perte opérationnelle se montait alors à 127,2 M$ (elle était de plus de 100 M$ en 2007). Pour son deuxième trimestre 2009, SGI avait encore perdu 49,2 M$. Le constructeur s'est perdu en chemin. Silicon Graphics, de son nom complet, est né en 1982, à l'heure bénie où les génies de l'informatique bâtissaient le futur tranquillement installés dans des garages. Il a petit à petit perfectionné ses solutions serveurs, OS et logiciels à destination de clients exigeants dans des industries très spécifiques comme le film ou le pétrole. Ces secteurs ont des besoins très pointus, à la fois en calcul et en affichage 3D de très haute qualité. L'inventeur d'OpenGL Puis, en 1992, SGI s'est distingué avec OpenGL. Cette API d'affichage graphique 3D est devenue un standard et reste au coeur de la plupart des applicatifs de ce type aujourd'hui. Pour preuve, les travaux engagés il y a quelques jours autour d'un standard pour le web 3D s'inspirent d'OpenGL. Par la suite, à la fin des années 90, SGI a pris la décision d'abandonner ses machines à base de processeurs Mips (processeurs de type Risc, par opposition aux architectures x86) qui tournaient sous son propre Unix, Irix. L'entreprise entreprend alors une difficile transition vers le couple Intel/Windows NT, nettement moins différenciateur. On peut imaginer que l'acquisition de SGI par Rackable Systems, spécialiste du datacenter (serveur et stockage en rack), devrait rassurer les clients de SGI. Les deux constructeurs ont des gammes tout à fait complémentaires. Comme le déclare Mark Barrenechea, président et CEO de Rackable Systems, dans le communiqué de l'annonce : "Ensemble, nous pensons que nous pouvons devenir une entité bien plus forte avec des produits et des gens formidables qui offriront une réponse plus efficace à au sein de nos marchés respectifs et de façon transversale. » La transaction annoncée hier doit encore être validée par la Bankruptcy Court américaine, et devrait être confirmée d'ici 60 jours. Gageons toutefois que la disparition de SGI, présent sur le marché depuis 27 ans, laissera à beaucoup un léger goût de nostalgie. (...)

| < Les 10 documents précédents | Les 10 documents suivants > |