Créée en 2007 et commercialisant depuis 2008 ses solutions de recommandations ciblant les e-commerçants - dont en France 3Suisses, Darty ou encore Priceminister -, RichRelevance a depuis le début misé sur des technologies big data, en particulier Hadoop. Il faut dire que la masse des données conservées, à savoir l'ensemble des événements concernant tous les produits vus, sur lesquels les internautes ont cliqué ou qu'ils ont achetés et que la société utilise pour générer des recommandations, atteint 2 pétaoctets. Et encore, en mode compressé, ce qui donne en décompressé un volume vertigineux de 13 pétaoctets de données.

Toutes ces données sont traitées dans les deux plus grands datacenters de RichRelevance (sur un total de 12 répartis aux Etats-Unis, en Asie et en Europe) qui font appel à d'immenses clusters Hadoop permettant d'exécuter les modèles de recommandations qui seront affichés sur les sites de ses clients, 500 au total, pour inciter leurs internautes à l'achat. « A la base, nous stockons nos données sur Hadoop HDFS, ensuite on utilise également Hive et HBase et aussi beaucoup de MapReduce pour analyser les données et créer des modèles de statistiques de recommandations », nous a précisé Marc Hayem, vice-président de la plateforme RichRelevance. Des briques big data indispensables quand on sait que les datacenters de l'éditeur sont amenés à traiter lors d'événements commerciaux particuliers comme le CyberMonday, pas moins de 17 000 requêtes par seconde. Sachant que pour chacune de ces requêtes, des recommandations sont proposées.

20% de temps économisé sur la génération de scripts

Les données traitées par RichRelevance sont de nature variée. Elles peuvent aussi bien provenir du online que du offline, comme des extraits de caisse enregistreuse de points de ventes. « Toutes ces données sont traitées en batch et 7 à 10 fois par jour, nous recevons des catalogues de contenus ou de produits envoyés par de grands retailers », explique Marc Hayem. Problème : tous ces catalogues sont loin d'utiliser le même standard de présentation, certains s'appuyant sur la norme Google XML, d'autres sur CSV... Pour palier cette situation, RichRelevance est donc contraint de nettoyer les données et de les mettre dans un format commun JSON. « JSON dispose d'un certain nombre de champs de données et des attributs produits, ce qui est très important pour les recommandations pour des tailles ou bien, par exemple, pour la classification des vins par année », précise Marc Hayem. « Le gros problème est que l'on devait mobiliser un ingénieur pour créer un script de transformation pour chaque catalogue client ainsi que pour les données remontées des points de ventes afin de transformer les données pour pouvoir les ingérer dans notre système de recommandation ».

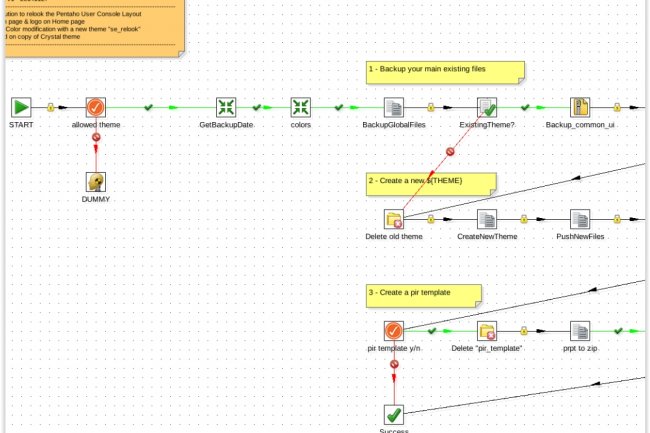

Non seulement les ingénieurs de RichRelevance étaient obligés d'écrire pour chaque catalogue de nouveaux scripts, en utilisant Pig ou Crunch, mais en plus cela posait des problèmes de maintenance. L'éditeur s'est donc mis en quête d'un outil graphique permettant d'automatiser la création de scripts, dits de transformation. « Nous nous sommes tournés vers Pentaho Data Integration qui est facile à utiliser, scalable et fonctionne nativement sur Yarn ce qui est beaucoup plus facile pour nous », raconte Marc Hayem. Les bénéfices découlant de la mise en place de cette solution ne se sont pas fait attendre : RichRelevance annonce en effet avoir réduit de 20% le temps d'écriture des scripts, ce qui a permis de réallouer le temps gagné à l'optimisation du moteur de recommandation et à la plateforme.

Un nouvel outil de reporting fin 2015 ou début 2016

Parmi les prochains projets dans le viseur de la société : la refonte du reporting permettant d'identifier facilement la performance et les types de recommandations les plus efficaces. « Nous avons créé nos propres bases de données de reporting et utilisons Pig pour préparer les données avec par dessus des librairies graphiques, mais aujourd'hui, nous regardons l'outil de reporting Report Builder de Pentaho dont la mise en oeuvre devrait intervenir fin 2015 ou début 2016 », conclut Marc Hayem.

super article

Signaler un abus