Apple a annoncé vendredi que les trois fonctionnalités dévoilées pour stopper la propagation de contenu d'abus sexuel sur enfant (CSAM) ne seront pas disponibles lors de la sortie à l'automne d'iOS 15, iPadOS 15, watchOS 8 et macOS 12 Monterey. L'entreprise rendra les fonctionnalités CSAM disponibles « plus tard cette année dans des mises à jour ». Dans un communiqué de presse, Apple a déclaré que « ce programme est ambitieux, et la protection des enfants est une responsabilité importante. Ces efforts évolueront et s'étendront au fil du temps ».

Apple a révélé les fonctionnalités CSAM au début du mois d'août, et si de nombreux membres de la communauté IT ont applaudi les efforts d'Apple pour protéger les enfants, beaucoup ont également exprimé des inquiétudes sur la façon dont la technologie derrière les fonctionnalités CSAM pourrait être utilisée à d'autres fins de surveillance. Plus de 90 groupes politiques et de défense des droits ont publié une lettre ouverte demandant instamment à Apple d'annuler ses fonctions.

Utilisateurs et vie privée, difficiles à concilier

La principale fonction qui a suscité la controverse est celle de détection de CSAM, qui consiste à rechercher des hachages dans les images de votre appareil, puis à vérifier ces hachages dans une liste de hachages CSAM connus. L'argument avancé contre cette fonction est qu'elle pourrait être utilisée à d'autres fins. Par exemple, un gouvernement pourrait demander à Apple de créer un processus similaire pour vérifier les images jugées intéressantes pour lui. La firme a déclaré que, dans de telles situations, elle rejetterait une telle demande, mais cette déclaration n'a pas emporté la confiance des personnes concernées. Les gouvernements pourraient notamment demander à vérifier la présence - ou non - de contenu politique présents sur les appareils d'opposants, ce qui pourrait amener Apple à changer sa politique.

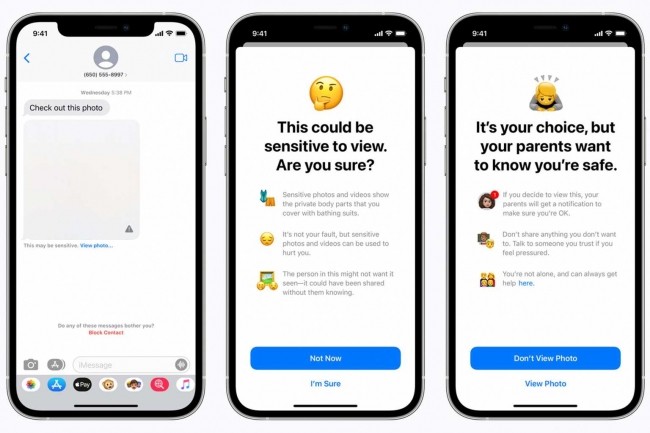

Il est également possible que le groupe décide d'utiliser cette technologie à des fins autres que le CSAM, mais cela affaiblirait l'image d'Apple en tant qu'entreprise soucieuse de la vie privée des utilisateurs. La firme a par ailleurs retardé deux autres fonctionnalités de CSAM, à savoir, la sécurité de la communication des messages - l'application « iMessages » utilisera l'apprentissage automatique sur l'appareil pour avertir les enfants et les parents des contenus sensibles et le mode « Siri et recherche » : ces fonctions devraient fournir des ressources supplémentaires pour aider les enfants et les parents à rester en sécurité en ligne et à obtenir de l'aide dans les situations à risque.

Commentaire