Après Meta, c’est au tour de Google de faire une démonstration de son programme d’IA capable de créer des vidéos à partir de texte. Des chercheurs de Google Brain, le laboratoire d'IA de Google, ont ainsi dévoilé cette semaine Imagen Video, un programme capable de créer des vidéos HD à partir de texte, et très similaire à ce que Meta a annoncé la semaine dernière. La maison-mère de Facebook a en effet fait parler d’elle lorsqu’elle a présenté Make-A-Video, un programme qui combine l'IA et l'interpolation pour créer des GIF vidéo courts et en boucle.

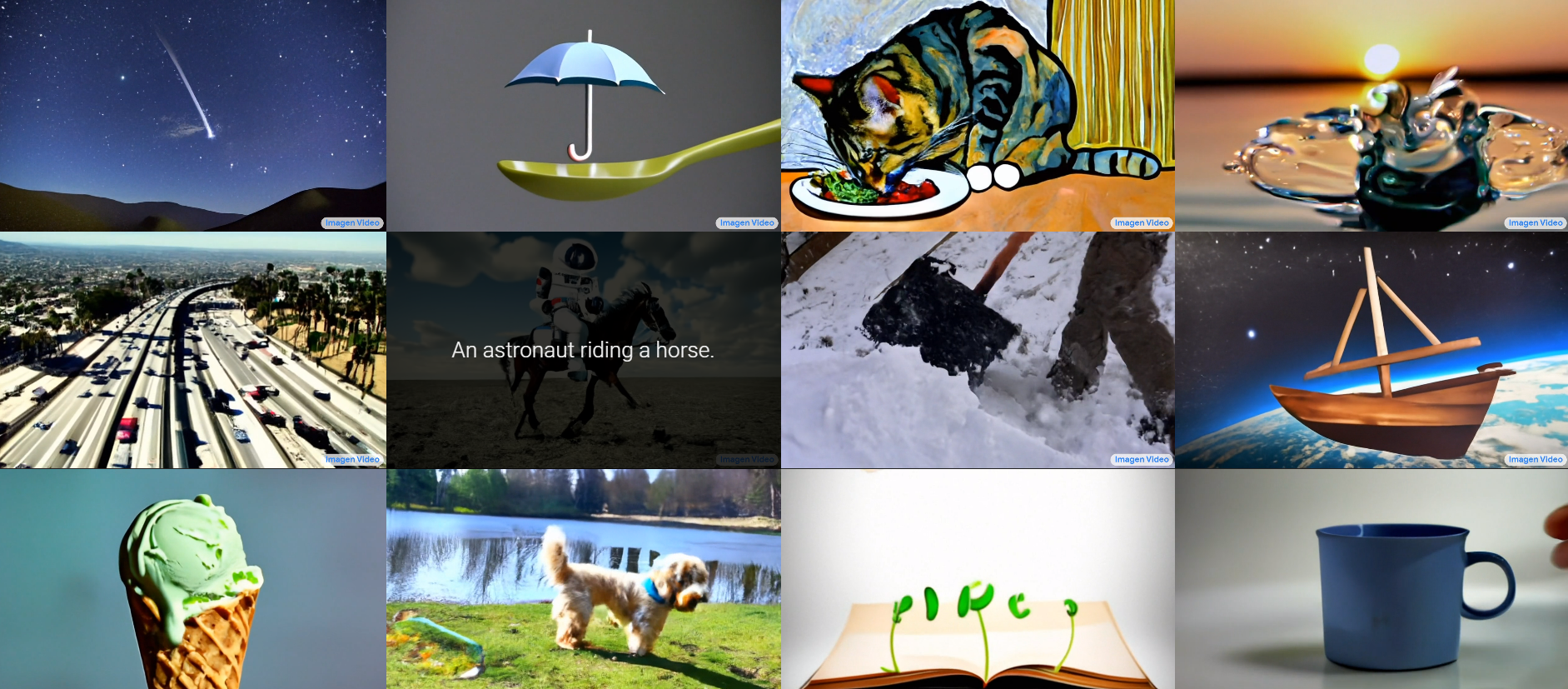

Pour la firme de Mountain View, Imagen Video est un « système de génération de vidéos conditionnées par le texte, basé sur une cascade de modèles de diffusion vidéo ». Les chercheurs de l’équipe Brain expliquent ainsi qu’ « à partir d'une invite textuelle, Imagen Video génère des vidéos haute définition en utilisant un modèle de génération vidéo de base et une séquence de modèles de super-résolution vidéo spatiaux et temporels entrelacés ». Le constat est le suivant : « Imagen Video est non seulement capable de générer des vidéos de haute-fidélité, mais il possède également un haut degré de contrôlabilité et de connaissance du monde, y compris la capacité de générer diverses vidéos et animations textuelles dans différents styles artistiques et avec une compréhension des objets en 3D ».

Les possibilités qui s’offrent aux utilisateurs avec Imagen Video sont immenses à partir de simples invites textuelles. Ci-dessus des exemples issus de imagen.research.google/video. (Crédit : Google)

Une IA qui donne vie à l’imaginaire

Le générateur peut produire des vidéos HD 1280×768 à 24 images par seconde. Il est actuellement en phase de développement, mais représente déjà une avancée considérable par rapport au modèle de génération de texte-image DALL-E de Google, présenté plus tôt cette année. Parmi les exemples les plus extravagants, on trouve la vidéo d’un astronaute chevauchant un cheval dans l’espace, un panda qui conduit une voiture ou encore un ours en peluche qui court dans les rues de New-York. La frontière entre le réel et l’imagination s’amenuise petit à petit avec de telles découvertes.

Google précise que pour programmer le générateur de vidéos, un large éventail de vidéos et d'images fixes ont été analysées, chacune étant accompagnée d'un texte. Ainsi, lorsqu'un texte est saisi ultérieurement, le générateur reproduit les vidéos et les images qu'il a vues dans le passé comme une synthèse des données. L’IA est ainsi entraînée sur un jeu de pas moins de 14 millions de vidéos et 60 millions d'images fixes, ainsi que 400 millions d'images dans le jeu LAION-400M.

Quand deux images ne font plus qu’une seule animée

Dans le même temps, des chercheurs ont présenté leurs dernières découvertes sur l'interpolation de trames. Ce processus, qui consiste à synthétiser des images intermédiaires à partir d'un ensemble d'images donné, est souvent utilisé pour le sur-échantillonnage temporel afin d'augmenter le taux de rafraîchissement des vidéos ou de créer des effets de ralenti. Les recherches se basent sur la capacité de certains appareils photo numériques et smartphones à capturer plusieurs photos en quelques secondes pour offrir la meilleure image possible à son utilisateur. L'interpolation entre ces photos « quasi-dupliquées » peut donner lieu à des vidéos attrayantes qui révèlent le mouvement de la scène, offrant même une sensation du moment encore plus agréable que les photos originales. A la différence des vidéos, l'espacement temporel entre des photos quasi-doublées peut être de plusieurs secondes, avec un mouvement intermédiaire proportionnellement important, ce qui constitue un point différenciant avec les méthodes d'interpolation d'images existantes.

Les techniques récentes tentent de gérer les mouvements importants en s'entraînant sur des ensembles de données avec des mouvements extrêmes, mais avec une efficacité limitée sur les mouvements plus petits. Google a donc travaillé sur une méthode permettant de créer des vidéos au ralenti de haute qualité à partir de photos quasi-doublées baptisée FILM (Frame Interpolation for Large Motion).

FILM interpolant entre deux photos quasi-dupliquées pour créer une vidéo au ralenti. (Crédit : Google)

Bien sûr, la firme n’est pas la seule à avoir travaillé sur cette technique, puisque le programme Make-A-Video de Meta peut produire sensiblement les mêmes résultats. Si l’on remonte à plus loin encore, Apple est l’un des premiers à avoir expérimenté cette animation d’images. Son mode Live, permet à l’iPhone d’enregistrer ce qui se passe 1,5 seconde avant et après une prise de vue. Une Live Photo se prend exactement comme une photo traditionnelle mais le résultat diffère. Lorsque l’on clique sur la photo « Live », l’image s’anime et montre ce qui s’est passé durant ces quelques secondes capturées. Il est également possible d’y ajouter des effets comme Rebond ou Boucle, mais aussi réduire la durée ou couper le son.

Les dérives de l’IA planent toujours

La modélisation générative a fait d'énormes progrès, notamment dans les récents modèles de conversion texte-image. Imagen Video n’est qu’une des nombreuses possibilités des systèmes d'IA texte-vidéo. Ces modèles génératifs vidéo peuvent être utilisés pour avoir un impact positif sur la société, par exemple en amplifiant et en augmentant la créativité humaine mais le risque d’un usage détourné et à mauvais escient reste présent. Par exemple, ces programmes peuvent être utilisés pour générer des contenus faux (notamment les deep fake), haineux, explicite ou nuisible. Google assure avoir pris de nombreuses mesures pour minimiser ces problèmes, « dans les essais internes, nous appliquons un filtrage du texte d'entrée et un filtrage du contenu vidéo de sortie ».

Cependant, il reste plusieurs défis en matière de sécurité et d'éthique, même si une grande partie du contenu explicite et violent peut être filtrée. Des préjugés sociaux et des stéréotypes persistent et sont difficiles à détecter et à filtrer. En ce sens, Google a pris la décision de ne pas publier le modèle d'Imagen Video ou son code source avant que ces préoccupations soient atténuées.

Commentaire