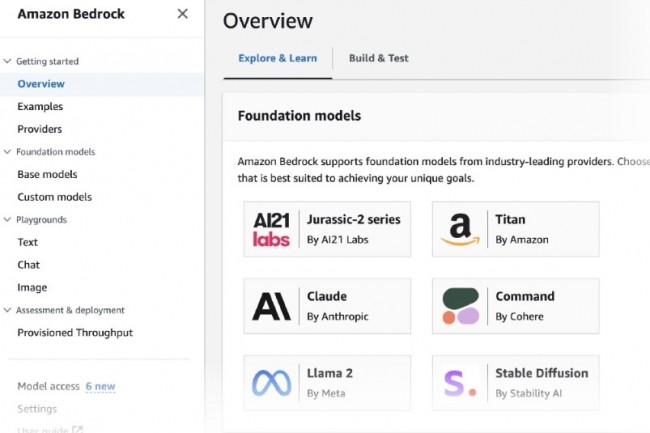

La plateforme Bedrock d'AWS pour créer des systèmes à partir de modèles de langage pré-entraînés se renforce. Le groupe a annoncé que Mistral 7B et Mixtral 8x7B de la start-up française Mistral AI, seront - sans plus de précision - bientôt disponibles sur cet environnement. Ces modèles s'ajouteront à d'autres déjà proposés à savoir AI21 Labs, Anthropic, Cohere, Meta, Stability AI, et Amazon. « Avec ces deux modèles Mistral AI, vous aurez la flexibilité de choisir le LLM optimal et performant pour votre cas d'utilisation afin de construire et de mettre à l'échelle des applications d'IA générative à l'aide de Bedrock », indique AWS.

Mistral 7B est le premier modèle de base de Mistral AI, qui prend en charge les tâches de génération de texte et les capacités de code. Il est optimisé pour une faible latence avec un besoin en mémoire réduit et un débit élevé pour sa taille. « Ce modèle est puissant et prend en charge divers cas d'utilisation, du résumé de texte à la classification, en passant par la complétion de texte et la complétion de code », rappelle AWS. Quant à Mixtral 8x7B, il s'agit d'un modèle de mélange d'experts (MoE) épars taillé pour le résumé de texte, les questions et réponses, la classification et la complétion de texte ainsi que la génération de code.

Commentaire