Jusqu’à présent, Cortana de Microsoft était surtout considéré comme une IA orientée utilisateur et travaillait essentiellement sous Windows. Mais les temps ont changé : désormais, Cortana n’est plus uniquement un service à la personne, mais une technologie qui alimente des centaines de bots automatisés, conçus par les clients de Microsoft eux-mêmes. Ce qui signifie que l’on pourra être confronté à une ressource de type Cortana dans des situations très différentes. En amont de sa conférence Build Developer Conference qui se tiendra du 6 au 8 mai à Seattle, l’éditeur a annoncé des services cognitifs dans le cloud pour les professionnels. C’est le cas par exemple de la transcription en temps réel des réunions ou encore de l'extraction de texte des formulaires. Cette annonce rappelle fortement la démo sur la « Salle de conférence du futur » présentée lors de la Build précédente : un appareil alimenté par Cortana (il ressemblait à un assistant vocal Alexa d’Amazon ou à un Assistant Google) a reconnu, assisté et enregistré une réunion. Pour y arriver, Cortana (ou un autre agent) doit être capable de comprendre le monde qui l'entoure.

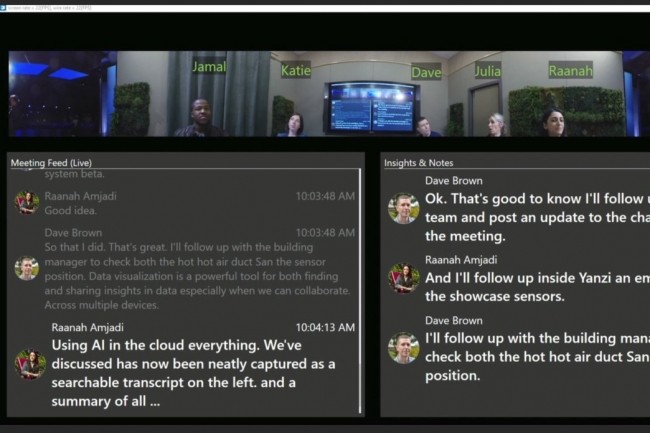

Le dispositif d'écoute basé sur Cortana présenté lors de la Build 2018 par Microsoft pouvait reconnaître les participants par l’image ou la voix, gérer et enregistrer les réunions. (Crédit : Microsoft)

Pour la Build 2019, certaines de ces capacités seront mises la disposition d'agents tiers via les Cognitive Services. Plus précisément, pour l’occasion, Microsoft va implémenter la transcription de la conversation, c’est à dire qu’un bot pourra « entendre » et transcrire une conversation en temps réel et assigner le texte à un orateur particulier. La firme va aussi améliorer les capacités de « vision », notamment la capacité de reconnaître l'encre numérique, et ce que l’entreprise appelle « Forms Recognizer », c’est à dire la capacité de supprimer les données inscrites par un utilisateur dans un formulaire. Microsoft a également entrepris d'intégrer un générateur de questions/réponses - Q&A Maker - pour orienter les utilisateurs dans des arborescences de dialogue prédéfinies.

Pour ce qui est de l'intelligence artificielle, les services de Microsoft ne se limiteront pas à l'enregistrement des données, mais analyseront aussi ces données et proposeront de l'aide. Une composante de ces services cognitifs, appelée Decision, sera capable de prendre en compte les commentaires et de décider d’une action. Un service connexe, appelé Personalizer, essayera d’interpréter ces résultats dans le cadre d’une relation avec un utilisateur particulier. Pour faire fonctionner tout cela, Microsoft veut utiliser son service cloud Azure, l’idée étant d’en faire le « cloud de l'intelligence artificielle ». Selon l’éditeurt, plus de 1,3 million de développeurs utilisent Azure Cognitive Services, et 3 000 bots sont créés chaque semaine. Le fournisseur estime à près de 400 000 le nombre total d’agents numériques.

Des circuits FPGA pour accélérer les traitements

Pour accélérer l’apprentissage de ses modèles d'IA, Microsoft s’appuie sur le machine learning (ML). C’est en 2016 que l'entreprise a évoqué l’usage de circuits logiques programmables (FPGA) dans ses serveurs pour améliorer les performances. Si des processeurs universels comme l’Intel Xeon sont capables d’exécuter un seul algorithme, un ASIC (un circuit intégré propre à une application) dédié à une fonction donnée offre généralement l’implementation la plus rapide. Mais ces ASIC ne permettent pas d'améliorer de manière significative le design sous-jacent. Le FPGA fait la part des choses entre performance et flexibilité, et Microsoft a annoncé la disponibilité générale de ses modèles d'apprentissage machine Azure accélérés, tournant sur des puces FPGA.

Commentaire