L'absence d’évaluations indépendantes quant aux protections de base des technologies d’IA inquiète de nombreux professionnels. Dans une lettre ouverte, plus de 150 éminents chercheurs en intelligence artificielle, éthiciens, juristes et autres appellent les entreprises commercialisant des solutions de GenAI à se soumettre à des audits de leurs systèmes. La lettre, rédigée par des chercheurs du MIT, de Princeton et de l'université de Stanford, demande des protections juridiques et techniques pour la recherche de bonne foi sur les modèles d'IA générative, qui, selon eux, entrave les mesures de sécurité qui pourraient contribuer à protéger le public. La lettre, et l'étude qui la sous-tend, ont été rédigées avec l'aide d’une vingtaine de professeurs et de chercheurs qui ont demandé « un cadre légal de sécurité » pour l'évaluation indépendante des produits de GenIA.

Militer pour des red teams

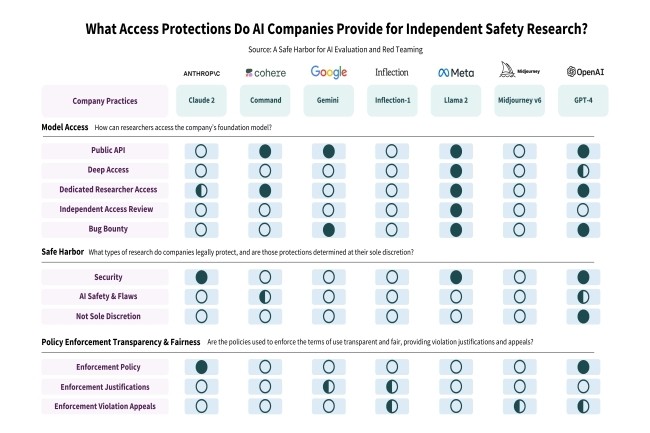

Ce document, envoyé à des entreprises comme OpenAI, Anthropic, Google, Meta et Midjourney, demande un droit d’accès des chercheurs aux produits afin de s'assurer que les consommateurs sont protégés contre les préjugés, les violations présumées des droits d'auteur et les images intimes non consensuelles. « Nombreux sont ceux qui estiment que l'évaluation indépendante des modèles d'IA déjà déployés est essentielle pour garantir la sûreté, la sécurité et la confiance », ont écrit deux des chercheurs dans un billet de blog. « Des recherches indépendantes sur les modèles d'IA ont permis de découvrir des vulnérabilités liées aux langages à faibles ressources, au contournement des mesures de sécurité et à un large éventail de jailbreaks. « Ces évaluations portent sur des défauts très divers souvent imprévus que l’on peut trouver dans les modèles, liés soit à une mauvaise utilisation, à des préjugés, à des droits d'auteur et à d'autres problèmes », ont-ils ajouté.

Parmi les signataires figurent des professeurs des écoles de l'Ivy League et d'autres universités réputées, dont le MIT, ainsi que des dirigeants d'entreprises comme Hugging Face et Mozilla. La liste comprend également des chercheurs et des éthiciens comme Dhanaraj Thakur, directeur de recherche au Center for Democracy and Technology (Centre pour la démocratie et la technologie), et Subhabrata Majumdar, président de l'AI Risk and Vulnerability Alliance.

Plus d’ouverture et de transparence souhaitées

Si la lettre reconnaît et se réjouit du fait que certains fabricants de genAI disposent de programmes spéciaux pour permettre aux chercheurs d'accéder à leurs systèmes, elle leur reproche aussi d’être trop restrictifs quant aux personnes qui peuvent ou ne peuvent pas voir leur technologie. Les chercheurs ont notamment cité les entreprises d'IA Cohere et OpenAI comme des exceptions à la règle, « même si une certaine ambiguïté subsiste quant à la portée des activités protégées ». Cohere autorise les « tests de résistance intentionnels de l'API et les attaques adverses » à condition que les vulnérabilités soient divulguées de manière appropriée (sans promesse légale explicite). Et OpenAI a élargi sa sphère de sécurité pour inclure la « recherche sur la vulnérabilité des modèles » et la « recherche universitaire sur la sécurité des modèles » en réponse à une première version de notre proposition.

Mais, dans d'autres cas, les entreprises de genAI ont suspendu les comptes des chercheurs et même modifié leurs conditions de service pour décourager certains types d'évaluation. Or, selon les chercheurs, « priver les chercheurs indépendants de leur pouvoir n'est pas dans l'intérêt des entreprises d'IA ». Les évaluateurs indépendants qui étudient les produits d'IA générique craignent la suspension de leur compte (sans possibilité d'appel) et les risques juridiques, « qui peuvent tous deux avoir un effet dissuasif sur la recherche », selon la lettre ouverte.

Pour protéger les utilisateurs, les signataires souhaitent que les entreprises d'IA offrent deux niveaux de protection à la recherche :

- Une protection juridique pour garantir une recherche indépendante de bonne foi sur la sûreté, la sécurité et la fiabilité de l'IA, le tout dans le cadre d'une divulgation bien établie des vulnérabilités.

- Un engagement de l'entreprise en faveur d'un accès plus équitable en faisant appel à des évaluateurs indépendants pour modérer les demandes d'évaluation des chercheurs.

Dans l'immédiat, les deux entreprises OpenAI et Google n'ont pas répondu à une demande de commentaire.

Commentaire