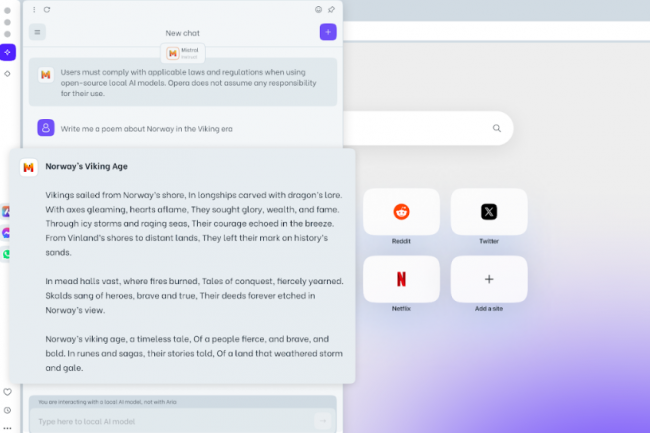

Opera embrasse les LLM. Le navigateur, en version One Developer dans le cadre de son programme AI Feature Drops, donne la possibilité de tester un grand modèle de langage à télécharger en local sur son poste. Il s'agit là d'une fonction expérimentale, avec donc tous les éventuels soucis qui peuvent survenir (stabilité, bugs...). "C'est la première fois qu'il est possible d'accéder et de gérer facilement les LLM locaux à partir d'un grand navigateur grâce à une fonction intégrée", annonce fièrement Opera. Parmi eux, on trouve Llama de Meta, Vicuna Gemma de Google, Phi-2 de Microsoft, et Mixtral de Mistral AI. Ces modèles sont disponibles dans le flux des développeurs d'Opera One.

L'utilisation de grands modèles de langage en local signifie que les données des utilisateurs sont conservées sur leur terminal sans nécessité d'envoyer des informations à un serveur distant ce qui s'avère un bon point à des fins de test et de garantie de confidentialité. Le revers est cependant de ne pas pouvoir profiter de l'incrémentation des données dans les LLM grand public du marché à des fins d'entrainement et donc d'amélioration continue de la pertinence des résultats fournis. Sur ce point, Opera ne précise pas si des mises à jour des LLM en local sont prévues dans les prochaines semaines/mois, bien qu'il faut garder en tête qu'il s'agit bien là d'une fonction expérimentale, à considérer davantage pour des fins de test qu'autre chose.

Un temps de traitement plus long que dans le cloud

"En choisissant un LLM local, vous le téléchargerez sur votre machine. Veuillez noter que chacun d'entre eux nécessite entre 2 et 10 Go d'espace de stockage local et qu'un LLM local est susceptible d'être considérablement plus lent à fournir des résultats qu'un LLM basé sur un serveur, car cela dépend des capacités de calcul de votre matériel", précise en outre Opera. "Le LLM local sera utilisé à la place d'Aria, le navigateur natif d'Opera AI, jusqu'à ce que vous démarriez un nouveau chat avec Aria ou que vous réactiviez simplement Aria".

Certains LLM proposés au téléchargement incluent par ailleurs Code Llama pour générer du code, disponible en trois versions : 7, 13 et 34 milliards de paramètres. Celui-ci prend en charge de nombreux langages de programmation dont Python, C++, Java, PHP, Typescript (JavaScript), C#, et Bash. Signalons que Nvidia propose aussi de tester des LLM en local (35 Go de téléchargement) en exploitant ses cartes RTX 30 et 40.

Commentaire