Cela fait de longs mois que les fabricants de puces se bousculent pour acquérir des capacités logicielles avancées afin de remporter la guerre des accélérateurs IA. Un terrain sur lequel Nvidia a pris une longueur d'avance depuis 2007 avec Cuda, un kit de développement pour aider les développeurs à porter leurs applications sur ses GPU pour accélérer certains traitements (compression, finance, simulation de fluides, modélisation du climat, cassage de codes ou encore calculs de structures). Mais AMD est loin dans ce domaine de faire de la figuration : après Silo AI, Mipsology ou encore Nod.ai, c'est au tour de la start-up Brium de rentrer dans son escarcelle. Avec un but recherché : tenter de contester la domination de Nvidia dans le domaine des logiciels d'IA et de renforcer la prise en charge des charges de travail d'apprentissage automatique sur le matériel AMD. « Brium apporte des capacités logicielles avancées qui renforcent notre capacité à fournir des solutions d'IA hautement optimisées sur l'ensemble de la pile », a déclaré AMD dans un communiqué. « Leur travail dans la technologie des compilateurs, les cadres d'exécution de modèles et l'optimisation de l'inférence de l'IA de bout en bout jouera un rôle clé dans l'amélioration de l'efficacité et de la flexibilité de notre plateforme d'IA. »

L'équipe Brium contribuera immédiatement à des projets tels que OpenAI Triton, Wave DSL et Shark/Iree afin d'améliorer l'exécution des modèles d'IA sur les GPU Instinct d'AMD a ajouté l'entreprise. Cela inclut la prise en charge de nouveaux formats de précision, tels que MX FP4 et FP6, conçus pour améliorer les performances et l'efficacité des charges de travail émergentes en matière d'entraînement et d'inférence. Cet accord est le dernier d'une série d'investissements ciblés par AMD, qui, selon l'entreprise, visent à renforcer le soutien à l'écosystème des logiciels open-source et à améliorer les performances de son matériel. Les acquisitions précédentes comprennent Silo AI, Nod.ai et Mipsology.

Cibler la dépendance à l'égard de Cuda

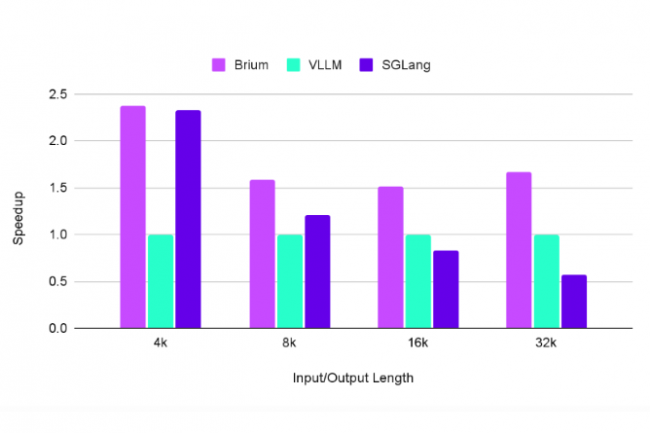

Ce rachat marque un mouvement calculé visant à réduire la dépendance à l'égard de la pile logicielle d'IA étroitement intégrée de Nvidia. Selon Greyhound Research, près de 67 % des DSI du monde entier considèrent que la maturité des logiciels, en particulier dans le domaine des intergiciels et de l'optimisation des temps d'exécution, est le principal obstacle à l'adoption de solutions alternatives à Nvidia. L'approche de l'inférence de l'IA de Brium, basée sur un compilateur, pourrait atténuer cette dépendance. Si Nvidia reste en tête des développeurs, la pile open source en expansion d'AMD, désormais soutenue par Brium, vise à améliorer les performances et la portabilité dans un plus grand nombre d'environnements d'IA.

« Brium comble l'une des lacunes les plus persistantes dans le déploiement de l'IA en entreprise : la dépendance à l'égard des chaînes d'outils optimisées par Cuda », indique Sanchit Vir Gogia, analyste en chef et CEO de Greyhound Research. « En se concentrant sur l'optimisation de l'inférence et la compatibilité matérielle, Brium permet aux modèles pré-entraînés de s'exécuter sur une plus large gamme d'accélérateurs avec des compromis de performance minimaux. » Bien que cela ne permette pas d'égaliser immédiatement les règles du jeu, cela donne à AMD un point d'appui plus solide pour construire une alternative cohérente et ouverte à la pile étroitement intégrée de Nvidia.

Un impact sur l'outillage IA des entreprises

L'acquisition signe également un changement dans la stratégie d'AMD, qui passe d'une focalisation sur le matériel à une poussée plus large en faveur de la compétitivité des plateformes d'IA complètes. « Cette vague d'acquisitions axées sur les logiciels montre qu'AMD est prêt à rivaliser dans le domaine le plus décisif de l'IA d'entreprise : la confiance », a déclaré M. Gogia. « Le travail de compilateur de Nod.ai, le pont FPGA de Mipsology, les capacités MLOps de Silo AI, et maintenant l'optimisation du temps d'exécution de Brium représentent un effort délibéré pour servir chaque phase du cycle de vie du modèle d'IA. » Les entreprises qui cherchent à migrer les charges de travail d'IA du matériel Nvidia au matériel AMD sont confrontées à trois obstacles majeurs. « Premièrement, l'incompatibilité logicielle est un obstacle majeur car de nombreux modèles et pipelines d'IA sont optimisés par Cuda pour Nvidia et ne fonctionnent pas nativement sur le matériel AMD, ce qui nécessite une conversion complexe avec des frameworks », a déclaré Manish Rawat, analyste des semi-conducteurs chez TechInsights. « Deuxièmement, l'obtention de performances comparables sur les GPU AMD exige une expertise approfondie en matière de gestion de la mémoire spécifique à AMD, de réglage du noyau et d'optimisation du temps d'exécution. Troisièmement, l'écosystème est centré sur Nvidia, et de nombreux outils et bibliothèques ne prennent pas en charge AMD, ce qui complique l'adoption.»

La technologie de Brium peut relever ces défis en rationalisant la conteneurisation, le déploiement de modèles et l'orchestration d'inférences sur les plateformes AMD. En faisant abstraction des complexités de déploiement et en optimisant les performances d'exécution, elle abaisse la barrière à l'adoption des GPU AMD par les entreprises. Cependant, les analystes notent que le succès dépendra de la manière dont Brium évoluera et s'intégrera à la pile logicielle ROCm et à l'écosystème de compilateurs existants d'AMD. « Combiné aux acquisitions précédentes, AMD est en train d'assembler une réponse complète à la domination de bout en bout de Nvidia », a fait savoir Abhivyakti Sengar, directeur de pratique chez Everest Group. « Si ces pièces s'assemblent efficacement, nous pourrions assister à un véritable changement dans les modèles d'adoption des entreprises au cours des 12 à 18 prochains mois, en particulier dans les secteurs sensibles aux coûts ou dans les efforts d'IA souveraine qui cherchent à diversifier la dépendance à l'égard du matériel. » Mais la clé sera l'expérience des développeurs, a ajouté M. Sengar. Si AMD ne parvient pas à rendre le déploiement transparent entre les cadres et les chaînes d'outils, la performance seule ne fera pas gagner les entreprises.

Commentaire