Pour pouvoir soutenir la croissance de son trafic au sein de ses datacenters, Facebook a choisi de modifier son architecture réseau. Le fabric qu'il met en place ne s'appuie pas sur un nouveau type de lien pour accélérer la vitesse de transfert. L'opérateur de réseau social a préféré transformer l'ensemble de son infrastructure en installant une série de modules, moins coûteux et plus faciles à acquérir que ceux qu'il utilisait jusque-là. Ces équipements sont aussi plus faciles à déployer et à gérer, selon Najam Ahmad, vice-président, responsable de l'ingénierie réseaux chez Facebook.

La société a inauguré sur son site d'Altoona, situé dans l'Iowa, cette conception modulaire qui fournit de façon constante des liens rapides entre les serveurs. Le datacenter de 44 000 m2 a été mis en route la semaine dernière et Facebook compte procéder de la même façon sur tous ses prochains datacenters. Il prévoit aussi de réaménager ses autres implantations dans le cadre de son cycle de mise à jour régulière.

Moins d'échanges avec Internet, davantage de trafic interne

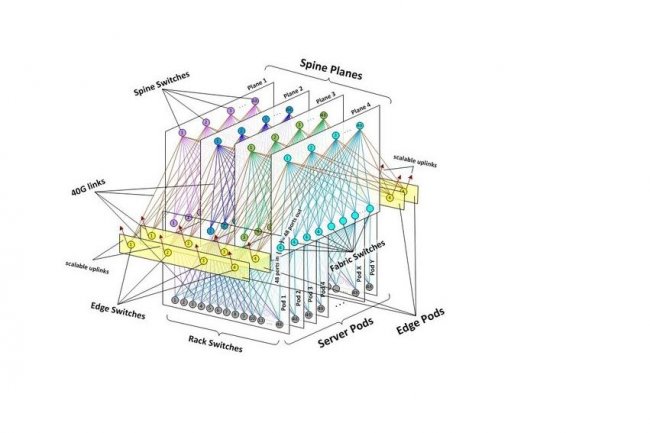

A l'instar d'autres opérateurs de datacenters tentaculaires, Facebook a décidé de se tourner vers des équipements réseaux assemblés en interne ou basiques, comme il le fait déjà pour les serveurs. Il les complète de ses propres logiciels, ce qui ne l'oblige plus à acquérir des produits dédiés auprès de spécialistes réseaux comme Cisco. L'actuelle infrastructure réseau des datacenters de Facebook est basée sur des clusters de centaines de racks de serveurs reliés entre eux à travers un imposant commutateur avec des liens montants à haut débit pour gérer l'ensemble du trafic généré par les serveurs.

Cette conception hiérarchique traditionnelle a son intérêt lorsque la majorité du trafic provient des échanges Internet. Or, actuellement, les échanges au sein du datacenter résultent principalement des communications internes à l'activité de Facebook. Les applications qui organisent les contenus partagés, les mises à jour de statuts et les publicités insérées dans les flux d'activités sont hautement distribuées. Et ce trafic « machine-to-machine », ainsi que le qualifie l'opérateur de réseau social, se développe beaucoup plus vite que le trafic qui part vers Internet. Gérer des centaines de racks par cluster implique des centaines de ports sur le commutateur auquel ils sont reliés et cela ne peut que se compliquer. « Nous achetons déjà les équipements les plus importants de l'industrie et il nous faut encore plus de ports », fait remarquer Najam Ahmad. Sans compter que le trafic entre serveurs doit souvent passer d'un cluster à l'autre ce qui implique de constamment vérifier que les liens entres ces énormes clusters sont suffisamment dimensionnés.

Des liens Ethernet 40 Gigabits

Ce dont Facebook avait besoin, c'était d'un réseau capable de gérer l'ensemble de ce trafic en interne quels que soient la nature et le nombre de serveurs impliqués. A la place de ces clusters, il a donc installé des pods constitués de petits groupes de serveurs de 48 racks. Les commutateurs nécessaires se limitent donc à 48 ports pour raccorder les racks au pod et 48 de plus pour se connecter aux autres commutateurs communiquant avec les autres pods. Il s'agit dès lors d'équipements plus faciles à acheter et que Facebook peut même construire, souligne Najam Ahmad.

Avec cette nouvelle architecture, l'opérateur de réseau social peut mettre en place des liens Ethernet 40 Gigabits entre n'importe quels racks du datacenter. Plutôt que de surenchérir sur le lien montant entre deux commutateurs et, en considérant que tous les racks ne vont pas constamment envoyer un maximum de données, Facebook installe une architecture non bloquante pour gérer en permanence un trafic élevé. Les pods sont identiques et les commutateurs standards, ce qui facilite l'extension des capacités serveurs et réseaux. Cette architecture permet d'ajouter des pods jusqu'à ce qu'il n'y ait plus de place pour le faire ou que l'on atteigne les limites des capacités d'alimentation électriques, selon Najam Ahmad.

The Wedge, un équipement « top of the rack »

Facebook a par ailleurs développé un logiciel qui repère et configure de nouveaux composants et automatise de nombreuses tâches d'administration. Les commutateurs utilisés étant basiques, la plupart des fonctions réseaux sont gérées par ce logiciel. La société créée par Mark Zuckerberg a conçu son propre commutateur « top of the rack » auquel les serveurs se raccordent via une liaison Ethernet 10 Gigabits. Cet équipement, baptisé The Wedge, n'était pas encore prêt pour être mis en place dans le datacenter d'Altoona dont Facebook a entièrement conçu l'architecture. L'opérateur a déployé la fibre sur le site, installé au centre le coeur de l'équipement réseau et placé des liens en ligne droite, aussi courts et directs que possibles. Lorsqu'il le faudra, le fabric réseau pourra être porté de 40 Gbits à 100 Gbits, et au-delà, selon Najam Ahmad.

Facebook, qui partage déjà avec d'autres entreprises les principaux concepts de son fabric réseau, a indiqué qu'il pourrait aussi en communiquer les designs, ainsi que le code qu'il a développé. Depuis 2011, son projet Open Compute donne accès à certaines des technologies qu'il utilise dans ses datacenters.

Facebook ouvre un datacenter modulaire qui peut s'étendre sans limite

Dans son datacenter d'Altoona, dans l'Iowa, Facebook a déployé des équipements réseaux basiques dont il a développé le logiciel. Il a laissé tomber les clusters constitués de centaines de racks serveurs pour miser sur de petits pods de 48 serveurs qui ne l'obligent pas à recourir à des commutateurs démesurés et lui permettent d'augmenter ses capacités presque indéfiniment.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Suivre toute l'actualité

Newsletter

Recevez notre newsletter comme plus de 50 000 professionnels de l'IT!

Je m'abonne

Commentaire