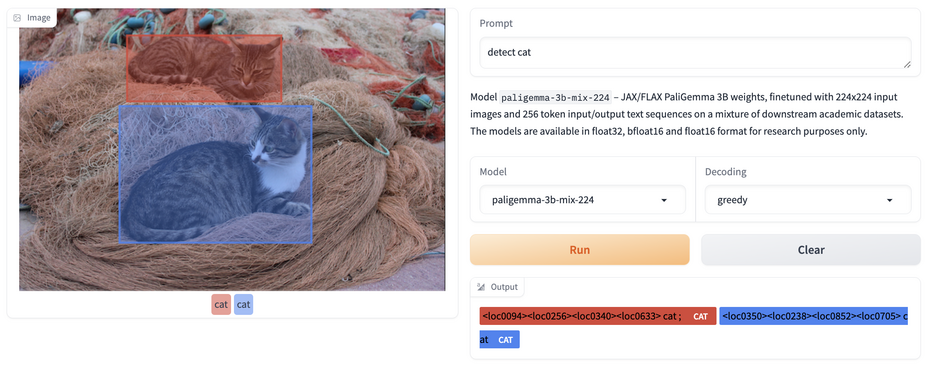

Encore un peu plus d’IA pour Google. La firme a profité de sa conférence I/O pour enrichir la gamme de LLM Gemma. En effet, elle a dévoilé le modèle de vision-langage Paligemma. Open source, il a été inspiré par le modèle Pali-3, mais en étant plus petit et plus rapide. Construit sur des composants du modèle de vision SigLIP, PaliGemma est destiné à des tâches de langage-vision comme le sous-titrage d'images et de vidéos, la réponse à des questions visuelles, la compréhension de texte dans des images, la détection et la segmentation d'objets. PaliGemma est disponible sur GitHub, Hugging Face, Kaggle et Vertex AI.

Paligemma améliore les performances des modèles de langage-vision actuels. (Crédit Photo: Google)

L’autre annonce concerne une deuxième version de Gemma comprenant 27 milliards de paramètres. Son lancement est prévu dans les prochaines semaines. « Avec ses 27 milliards de paramètres, Gemma 2 offre des performances comparables à celles de Llama 3B pour une taille inférieure de moitié », a affirmé Google. Ce design efficace réduit les dépenses de déploiement, puisque, pour des modèles comparables, Gemma 2 requiert moins de la moitié du calcul. Pour l’affinement, Gemma 2 peut fonctionner avec des solutions comme Google Cloud, jusqu’à des outils comme Axolotl.

Parmi les autres présentations sur les LLM, Google améliore son outil Responsible Generative AI en publiant le service LLM Comparator en open source. Cette solution interactive de visualisation des données propose aux développeurs d’évaluer les modèles et notamment d’effectuer des contrôles côte à côte des réponses des modèles afin d'en apprécier la qualité et la sécurité.

Avec LLM Comparator, un développeur peut comparer les résultats avec différents modèles. (Crédit Photo : Google)

Commentaire