Après avoir reconnu que son agent de navigation Chrome alimenté par Gemini pouvait être amené à effectuer des actions non autorisées via des attaques par injection de prompts, Google déploie un second agent pour le surveiller. « Nous introduisons User Alignment Critic où les actions de l'agent sont vérifiées par un modèle distinct, isolé des contenus non fiables », a déclaré l’entreprise dans un article de blog consacré à cette annonce. « Si le modèle critique détermine qu'une action ne correspond pas à ce que l'utilisateur a demandé, il la bloque », a expliqué Google. « L'injection indirecte de messages est la principale menace à laquelle sont confrontés tous les navigateurs agentiques », a écrit Nathan Parker, ingénieur en sécurité chez Chrome, dans cet article où il décrit une situation dans laquelle un agent est invité à traiter des informations qui cherchent ensuite à modifier le message initial.

Lancé en septembre et actuellement en phase de test, l'agent de navigation alimenté par Gemini peut aller sur des sites web, cliquer sur des boutons et remplir des formulaires pendant que les utilisateurs sont connectés à leurs systèmes de messagerie électronique, bancaires et d'entreprise. Des instructions malveillantes cachées dans des pages web, des iframes ou du contenu généré par les utilisateurs pourraient « amener l'agent à effectuer des actions indésirables, comme lancer des transactions financières ou exfiltrer des données sensibles », a écrit M. Parker. C'est là qu'intervient l’agent « User Alignment Critic » : il examine chaque action proposée avant que Chrome ne l'exécute. Il agit comme ce que M. Parker a appelé « une couche de défense supplémentaire puissante contre le détournement d'objectifs et l'exfiltration de données. »

L'injection de prompt, une attaque difficile à arrêter

L'injection de prompt est apparue comme la principale vulnérabilité des systèmes IA au cours de l'année dernière. L'Open Web Application Security Project (OWASP), un organisme internationale à but non lucratif qui se consacre à la sécurité des applications web, l'a détecté dans 73 % des déploiements IA en production qu'elle a évalués en 2024, classant l'injection de prompt comme le risque numéro un dans sa liste des menaces pesant sur les applications de grands modèles de langage. Le Centre national de cybersécurité (National Cyber Security Centre) du Royaume-Uni a averti dimanche que les attaques par injection de prompt pourraient ne jamais être totalement supprimées, car les LLM ne peuvent pas distinguer de manière fiable les instructions des données. L'agence a qualifié cette vulnérabilité de « deputy confused » (adjoint confus), dans laquelle un système de confiance est amené à effectuer des actions pour le compte d'une partie non fiable.

Des chercheurs ont déjà démontré cette menace. En janvier, des pirates ont intégré des instructions dans un document qui ont conduit un système IA d'entreprise à divulguer des informations commerciales et à désactiver ses propres filtres de sécurité. La société de sécurité AppOmni a révélé le mois dernier que les agents IA de ServiceNow pouvaient être manipulés à l'aide d'instructions cachées dans des champs de formulaire, un agent recrutant d'autres agents pour effectuer des actions non autorisées. Pour Chrome, les enjeux sont particulièrement importants. Un agent de navigation compromis disposerait de tous les privilèges de l'utilisateur sur n'importe quel site connecté, contournant potentiellement les protections d'isolation des sites du navigateur qui empêchent normalement les sites web d'accéder aux données les uns des autres.

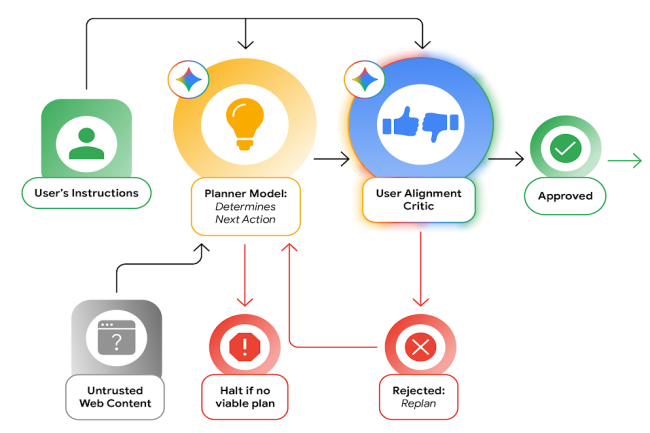

La défense à deux modèles de Google

Pour faire face à ces risques, la solution de Google répartit le travail entre deux agents. Celui basé sur Gemini lit le contenu web et décide des mesures à prendre. User Alignment Critic ne voit que les métadonnées relatives aux actions proposées, et non le contenu web susceptible de contenir des instructions malveillantes. « Ce composant est conçu pour ne voir que les métadonnées relatives à l'action proposée et non le contenu web non filtré et non fiable, garantissant ainsi qu'il ne peut pas être corrompu directement à partir du web », a détaillé M. Parker dans le blog. Lorsque le modèle critique rejette une action, il fournit un retour d'information au modèle de planification afin que celui-ci reformule son approche. Selon le billet de blog, l'architecture s'appuie sur des recherches de sécurité existantes, s'inspirant de ce que l'on appelle le modèle dual-LLM et des recherches CaMeL de DeepMind. Google limite également les sites web avec lesquels l'agent peut interagir grâce à ce qu'il appelle des « ensembles d'origine ». Le système tient à jour des listes de sites que l'agent peut lire et de sites sur lesquels il peut effectuer des actions comme cliquer ou taper. Une fonction de contrôle, isolée du contenu non fiable, détermine quels sites sont pertinents pour chaque tâche.

L’entreprise reconnaît que cette première implémentation est encore sommaire. « Nous allons ajuster les fonctions de contrôle d'accès et d'autres aspects de ce système afin de réduire les frictions inutiles tout en améliorant la sécurité », a indiqué M. Parker. Au-delà des contrôles d'alignement critiques des utilisateurs et de la surveillance des ensembles d'origine, Chrome exigera la confirmation de l'utilisateur avant que l'agent de navigation ne se rende sur des sites bancaires ou médicaux, n'utilise les mots de passe enregistrés via Google Password Manager ou ne finalise des achats, selon le blog. L'agent de navigation n'a pas d'accès direct aux mots de passe enregistrés. Un classificateur fonctionne en parallèle pour vérifier les tentatives d'injection de prompt pendant que l'agent travaille. Google a mis en place des systèmes automatisés de red teaming qui génèrent des sites de test malveillants, en donnant la priorité aux attaques lancées via le contenu généré par les utilisateurs sur les réseaux sociaux et les réseaux publicitaires.

Un problème en attente de solution

Le défi de l'injection de prompt n'est pas propre à Chrome. OpenAI l'a qualifié de « problème de recherche difficile et novateur » pour les fonctionnalités de ChatGPT et s'attend à ce que les attaquants investissent des ressources importantes dans ces techniques. Gartner est allé plus loin et a conseillé aux entreprises de bloquer les navigateurs IA dans leurs systèmes. Le cabinet d'études a averti que les agents de navigation alimentés par l'IA pourraient exposer les données et les identifiants des entreprises à des attaques par injection de prompt.

Le Centre national de cybersécurité britannique a adopté une position similaire, exhortant les entreprises à partir du principe que les systèmes d'IA seront attaqués et à limiter leur accès et leurs privilèges en conséquence. L'agence a déclaré que les organisations devraient gérer les risques dès la conception plutôt que d'espérer que des correctifs techniques éliminent le problème. « Les fonctionnalités de l'agent Chrome sont facultatives et restent en phase de prévisualisation », rappelle le blog.

Commentaire