Avant le week-end, Google a dévoilé Gemini 1.5, son prochain modèle d'intelligence artificielle générative (genAI) appelé à succéder à la version 1.0 publiée une semaine auparavant. Selon l'entreprise, la future version du modèle d'IA multimodale, désormais prêt pour effectuer ses premiers tests, surpasse la précédente sur presque tous les plans. Contrairement au populaire ChatGPT d'OpenAI, les utilisateurs peuvent introduire dans son moteur de requête une quantité beaucoup plus importante d'informations afin d'obtenir des réponses plus précises. À noter qu’OpenAI a également annoncé un modèle d'IA jeudi dernier appelé Sora. Ce modèle texte-vidéo est capable de générer des scènes vidéo complexes avec plusieurs personnages, des types de mouvements spécifiques et des détails précis sur le sujet et l'arrière-plan « tout en maintenant la qualité visuelle et le respect de l'invite de l'utilisateur ». Le modèle d’OpenAI comprend non seulement ce que l'utilisateur a demandé dans l'invite, mais aussi comment ces choses existent dans le monde physique.

Une scène de film générée par le moteur GenAI Sora, d'OpenAI (Crédit : OpenAI).

Les modèles Gemini de Google sont les seuls grands modèles de langages (LLM) natifs et multimodaux de l'industrie. Gemini 1.0 et Gemini 1.5 peuvent ingérer et générer du contenu sous forme de texte, d'images, d'audio, de vidéo et d'invites de code. Par exemple, dans le modèle Gemini, les invites de l'utilisateur peuvent se présenter sous la forme d'images Jpeg, WEBP, HEIC ou HEIF. « OpenAI et Gemini reconnaissent tous deux l'importance de la multimodalité et l'abordent de différentes manières. N'oublions pas que Sora n'est qu'un modèle de prévisualisation, à disponibilité limitée, et qu'il ne sera pas généralement disponible à court terme », a déclaré Arun Chandrasekaran, analyste chez Gartner. « Sora d'OpenAI sera en concurrence avec des start-ups comme Runway AI, fabricant de modèles de conversion de texte en vidéo », a-t-il ajouté.

Annoncé pour la première fois en décembre 2023, Gemini 1.0 a été publié la semaine dernière. À cette occasion, Google a déclaré avoir reconstruit et renommé son chatbot Bard. Gemini est suffisamment flexible pour fonctionner sur tous les supports, depuis les centres de données jusqu’aux terminaux mobiles. Et selon Chirag Dekate, analyste chez Gartner, si ChatGPT 4, le dernier LLM d'OpenAI, est multimodal, il n'offre que quelques modalités d’images et de texte ou de texte vers la vidéo. « Google veut jouer son rôle de leader de fournisseur de services d'IA dans le cloud. Il ne s'agit plus de rattraper le temps perdu. D'autres ont commencé à s’y mettre », a déclaré M. Dekate. « Aujourd'hui, un utilisateur enregistré de Google Cloud peut accéder à plus de 132 modèles dont l’étendue est stupéfiante », a-t-il précisé. « Des secteurs verticaux comme les médias et le divertissement pourraient être les premiers à adopter des modèles de ce type, et des sociétés technologiques et des entreprises pourraient aussi être les premiers à adopter les fonctions commerciales comme des fonctions de marketing et de conception », a avancé M. Chandrasekaran. Actuellement, OpenAI travaille sur sa prochaine génération GPT 5 de son modèle qui devrait être aussi multimodal. M. Dekate estime cependant que GPT 5 consistera en plusieurs petits modèles assemblés et qu'il ne sera pas nativement multimodal et de ce fait, son architecture sera probablement moins efficace.

Le premier modèle Gemini 1.5 proposé par Google pour les tests préliminaires s’appelle Gemini 1.5 Pro, que l'entreprise décrit comme « un modèle multimodal de taille moyenne optimisé pour une mise à l'échelle sur un large éventail de tâches ». « Les performances de ce modèle sont similaires à celles de Gemini 1.0 Ultra, le plus grand modèle de Google à ce jour, mais il nécessite beaucoup moins de cycles GPU », a indiqué l'entreprise. Gemini 1.5 Pro introduit également une fonctionnalité expérimentale de compréhension des contextes longs qui permet aux développeurs de demander au moteur jusqu'à 1 million de tokens de contexte. Les développeurs peuvent s'inscrire à l'aperçu privé de Gemini 1.5 Pro dans Google AI Studio. Google AI Studio est le moyen le plus rapide de créer des modèles Gemini et aux développeurs d'intégrer l'API Gemini dans leurs applications. Il est disponible en 38 langues dans plus de 180 pays et territoires.

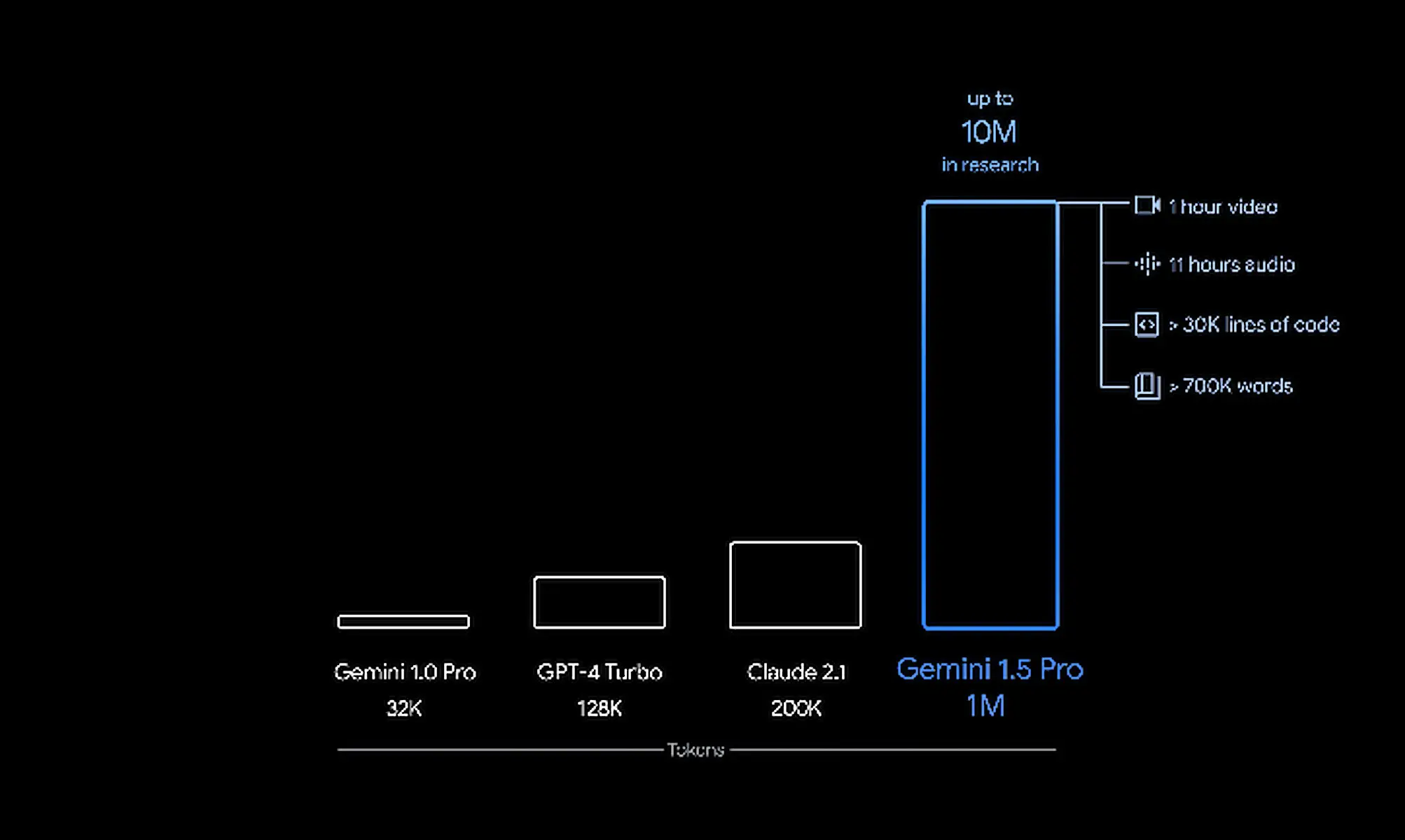

Comparaison entre Gemini 1.5 et d'autres modèles d'IA en termes de fenêtres contextuelles de tokens. (Crédit : Google)

Le modèle Gemini de Google a été conçu dès le départ pour être multimodal et n'est pas constitué de plusieurs parties superposées comme le sont les modèles concurrents. la firme de Mountain View présente Gemini 1.5 comme un « modèle multimodal de taille moyenne » optimisé pour s'adapter à un large éventail de tâches. Si ses performances sont similaires à celles de 1.0 Ultra, c'est parce qu'il applique de nombreux modèles plus petits dans le cadre d'une architecture pour des tâches spécifiques. Google obtient les mêmes performances avec un LLM plus petit en utilisant un framework de plus en plus populaire connu sous le nom de « Mixture of Experts » ou MoE. Basé sur deux éléments clés de l'architecture, MoE superpose une combinaison de petits réseaux neurologiques et exécute une série de routeurs de réseaux neurologiques qui pilotent dynamiquement les résultats des requêtes. « En fonction du type d'entrée, les modèles MoE apprennent à activer sélectivement les voies expertes les plus pertinentes dans leur réseau neuronal. Cette spécialisation améliore considérablement l'efficacité du modèle », a expliqué Demis Hassabis, CEO de Google DeepMind, dans un billet de blog. « Google a été un adopteur précoce et un pionnier de la technique MoE pour l'apprentissage profond grâce à des recherches comme Sparsely-Gated MoE, GShard-Transformer, Switch-Transformer, M4 et bien d'autres encore », a ajouté le CEO.

L'architecture MoE permet à l'utilisateur de saisir une énorme quantité d'informations, mais aussi de traiter ces données avec beaucoup moins de cycles de calcul lors de la phase d'inférence. Elle peut alors fournir ce que M. Dekate appelle « des réponses hyper précises ». « Les concurrents de Google s'efforcent de suivre, mais ils ne disposent pas de DeepMind ou de la capacité GPU dont dispose l’entreprise pour livrer des résultats », a pointé M. Dekate. Grâce à la fonction de compréhension des contextes longs, Gemini 1.5 dispose d'une fenêtre contextuelle de 1,5 million de mots-clés, ce qui signifie qu'un utilisateur peut taper une seule phrase ou télécharger plusieurs livres d'informations dans l'interface du chatbot et recevoir en retour une réponse ciblée et précise. À titre de comparaison, Gemini 1.0 avait une fenêtre contextuelle de 32 000 tokens. Les LLM concurrents sont généralement limités à des fenêtres contextuelles d'environ 10 000 tokens - à l'exception de GPT 4, qui peut accepter jusqu'à 125 000 tokens. Gemini 1.5 Pro est livré avec une fenêtre contextuelle standard de 128 000 tokens. Cependant, Google permet à un groupe limité de développeurs et d'entreprises clientes de l'essayer en avant-première privée avec une fenêtre contextuelle pouvant aller jusqu'à 1 million de tokens via AI Studio et Vertex AI. « Alors que nous déployons la fenêtre contextuelle complète d'un million de tokens, nous travaillons activement sur des optimisations pour améliorer la latence, réduire les exigences de calcul et améliorer l'expérience de l'utilisateur », a déclaré Demis Hassabis, le CEO de Google DeepMind.

Commentaire