Le cabinet d'études IDC a voulu savoir comment les entreprises faisaient cohabiter les gros systèmes d'analyse big data Open Source comme Hadoop avec d'autres solutions pour valoriser leurs données. L'enquête commandée par Red Hat et intitulée « Quelles tendances pour les déploiements Hadoop en entreprise » révèle que 32 % des entreprises interrogées ont déjà réalisé un déploiement Hadoop, que 31 % ont l'intention de déployer Hadoop dans les 12 prochains mois, et 36 % pensent recourir à un déploiement Hadoop dans plus d'un an.

L'étude d'IDC montre aussi que les entreprises associent Hadoop avec d'autres bases de données pour faire de l'analyse big data. Ainsi, près de 39 % des entreprises interrogées indiquent qu'elles utilisent des bases de données NoSQL comme HBase, Cassandra et MongoDB, et près de 36 % déclarent utiliser des bases de données MPP comme Greenplum et Vertica. « Cette situation souligne l'importance de la causalité et de la corrélation, dans lequel les ensembles de données structurées traditionnels sont analysés en conjonction avec des données non structurées provenant de sources nouvelles », indique le rapport. L'enquête confirme une analyse faite la semaine dernière par le chef analytique de Facebook, Ken Rudin : lors d'une conférence à New York, celui-ci a déclaré que, « pour les entreprises cherchant à exploiter de grosses quantités de données, Hadoop ne suffit pas ».

Hadoop pour mettre en route des services innovants

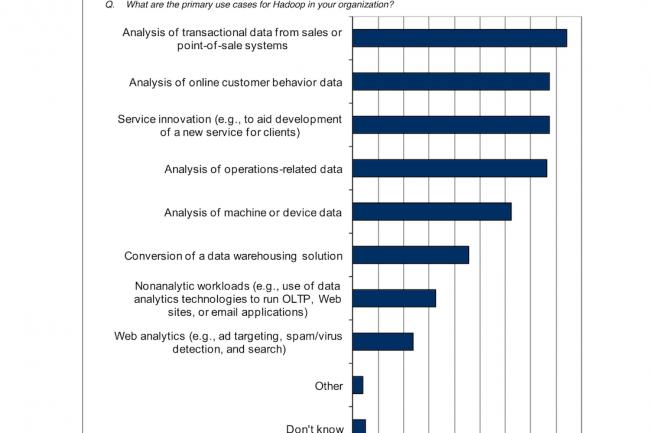

L'étude d'IDC a le mérite de montrer les différentes façons dont les entreprises utilisent Hadoop. Cela va de l'analyse des données brutes, que ce soit des données opérationnelles, des données machines ou provenant de terminaux divers ou de systèmes de point de vente, ou encore des données sur le comportement des clients recueillies par le commerce électronique ou les systèmes de vente au détail. Environ 39 % des entreprises interrogées ont répondu qu'elles utilisaient Hadoop pour « mettre en place des services innovants », comme l'analyse de sets de données secondaires pour la modélisation de scénarios « si-alors » pour les produits et services. Parmi les exemples les moins répandus d'Hadoop, le rapport cite un déploiement en plate-forme pour des charges de travail non analytiques, éventuellement relié à une surcouche SQL pour les tâches OLTP (online transaction processing).

« En conséquence, les entreprises se tournent vers des systèmes de stockage persistants alternatifs », indique le rapport d'IDC. Selon l'enquête, « des systèmes de fichiers comme Global File System (GPFS) d'IBM, Red Hat Storage (GlusterFS), EMC Isilon OneFS et autres qui ont la réputation d'offrir de fortes capacités scale-out, sont clairement préférés au HDFS (Hadoop Distributed File System) d'Hadoop ». L'étude révèle également que la plupart des entreprises traitent les données big data en aval et en amont d'Hadoop. « Cela met en lumière une autre caractéristique intéressante des solutions de stockage alternatives, notamment la possibilité de conserver les données au format Posix natif et le recours persistant à des outils d'analyse traditionnels », ajoute IDC.

Hadoop souvent associé à d'autres systèmes d'analyse big data, selon IDC

0

Réaction

L'enquête réalisée par IDC sur les déploiements Hadoop en entreprise révèle une situation complexe.

Newsletter LMI

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire