Surtout ne pas reproduire l'erreur de Microsoft avec son chatbot Tay aussi avant-gardiste que raciste. Face aux évolutions sociétales en matière de représentation de genre et de diversité, Google a pris les devants pour ne pas la laisser de côté dans les résultats de recherche de son outil d'IA générative Gemini. Oui mais voilà, à trop vouloir bien faire, la firme de Mountain View a été pris à son propre jeu en provoquant malgré lui une réinterprétation historique en affichant dans ses résultats de requêtes des personnages - certes fictifs - mais dont la présence est tout simplement impossible.

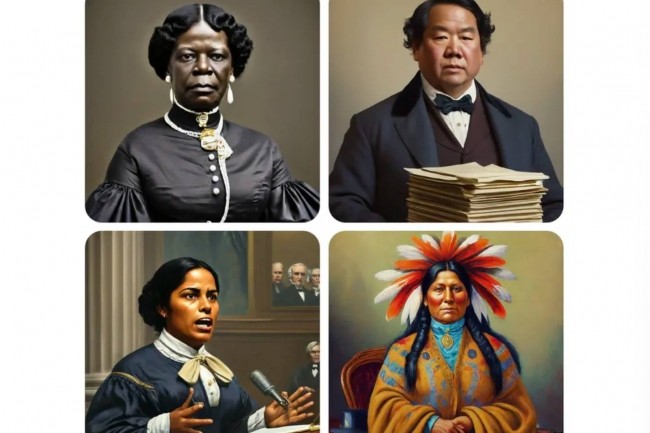

En réponse aux requêtes pour générer un pape, un roi anglais médiéval, un viking, un sénateur américain des années 1800 ou encore un soldat allemand de 1943, Gemini affiche des résultats historiquement parlant aberrants avec aussi bien des femmes que des personnes noires. « Nous sommes conscients que Gemini propose des inexactitudes dans certaines représentations historiques de la génération d'images », a indiqué Google. « Nous travaillons pour améliorer ces types de représentation. La génération d'image de l'IA Gemini génère un large éventail de personnes. Et c'est généralement une bonne idée parce que des gens du monde entier l'utilisent. Mais dans ce cas elle rate le coche ».

En début de semaine, un ancien employé de Google en charge de la recherche a publié sur X qu'il était « terriblement difficile de faire admettre à Google Gemini que les blancs existent », en montrant une série de requêtes telles que « générer une image d'une femme australienne » dont les 4 résultats faisaient ressortir des femmes non blanches. Ce qui n'est pas totalement absurde, si on considère la population native aborigène.

"Ce qui n'est pas totalement absurde, si on considère la population native aborigène. " Mdr ...

Signaler un abus