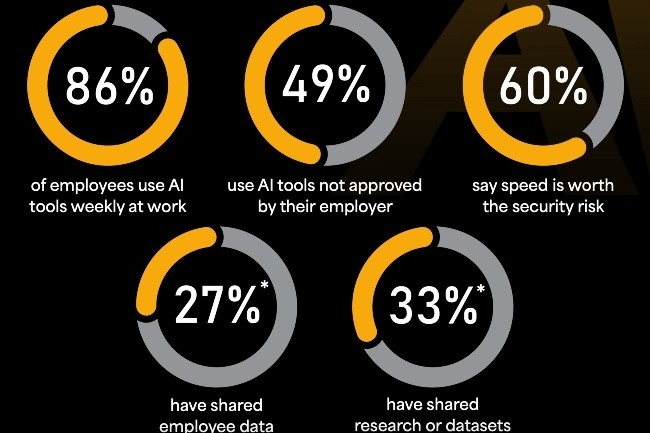

Alors que les directions générales multiplient les injonctions à adopter l’IA pour gagner en productivité et réduire les coûts, la question de l’encadrement des usages reste limitée. Dans ce contexte, le shadow IA, c’est-à-dire l’utilisation d’outils IA par les salariés non approuvés par l'entreprise, continue de progresser sans signe de ralentissement. Selon une enquête menée par BlackFog, près de la moitié des salariés (49 %) reconnaissent utiliser des outils IA sans l’accord de leur entreprise dans lesquels ils n’hésitent pas à verser des données sensibles de la société. Cette étude a été menée auprès de 2 000 salariés d'entreprises de plus de 500 employés.

Une situation inquiétante mais qui ne semble pas heurter une majorité de dirigeants. Ainsi, 69 % des présidents et membres du comité exécutif, et 66 % des directeurs et vice-présidents seniors, privilégient la rapidité à la sécurité des données dans leur course à l’IA. « Les gains d’efficacité et la réduction de personnel sont trop importants pour être ignorés et prennent le pas sur les préoccupations de sécurité », prévient Darren Williams, fondateur et CEO de BlackFog. Pour lui, cette étude révèle non seulement l’usage massif d’outils IA non approuvés dans les entreprises, mais aussi le niveau exceptionnel de tolérance au risque, tant chez les salariés que chez les dirigeants.

51 % des salariés connectent des outils IA sans l’accord de la DSI

Dans l’ensemble, 86 % des répondants déclarent utiliser l’IA chaque semaine dans le cadre professionnel, principalement pour le support technique, les activités commerciales, notamment le marketing par e-mail, ainsi que la gestion des contrats.En regardant de plus près, 51 % des salariés connectent ces solutions à des systèmes ou applications métiers sans l’accord ni même la connaissance de la DSI. Près de 63 % estiment acceptable d’utiliser l’IA quand aucune solution approuvée ou encadrée par l’IT n’est disponible. Six salariés sur dix considèrent que la vitesse d’exécution justifie de prendre des risques en matière de sécurité, et 21 % pensent que leur employeur fermera les yeux tant que le travail est accompli.

Chez les dirigeants, l’usage de ces outils reste plus discret, mais tout aussi réel. Ainsi, Darren Williams note que « les cadres dirigeants ne veulent souvent pas admettre qu’ils utilisent l’IA ». Ils cherchent avant tout à démontrer leur valeur sans révéler leur dépendance à ces technologies. Comme les salariés, ils peuvent accomplir beaucoup plus de tâches, et beaucoup plus vite, grâce à l’IA. « On peut, par exemple, rédiger un contrat juridique en quelques secondes et le faire relire par un avocat, plutôt que de passer des semaines à le rédiger et le retravailler avec un cabinet externe », explique-t-il.

Le risque des outils gratuits

L’étude révèle un autre point frappant : les versions gratuites dominent le shadow IA. Parmi les salariés qui utilisent des outils non approuvés, 58 % se tournent vers des offres gratuites. Même dans les entreprises disposant d'une stratégie IA, 34 % continuent de privilégier ces versions. Un choix risqué selon Darren Williams : « Les outils gratuits cachent toujours un coût, ici, c’est la valeur de vos données. » Et les collaborateurs ne se retiennent pas, 33 % injectent des données de recherche ou internes. 27 % partagent des informations sur leurs collègues, salaires ou performances, et 23 % transmettent des données financières de l’entreprise.

Le danger est double: la plupart des solutions gratuites utilisent les données ingérées pour entraîner leurs modèles. « Une fois ces informations transmises, il est impossible de les récupérer », assure Darren Williams. « Même les solutions entreprises qui donne la possibilité de couper l’entraînement des modèles sur vos données ne le garantissent pas toujours. Les administrateurs doivent vérifier chaque paramètre avec leurs fournisseurs de LLM. Le principal problème, c’est la perte de propriété intellectuelle », résume-t-il. Car ces données peuvent ensuite être exploitées par des acteurs malveillants pour profiler et cibler une société, compromettre ses réseaux ou exfiltrer des informations confidentielles à des fins d’extorsion.

Les entreprises doivent définir des règles d’usage de l’IA

Dans le même temps, de nombreux PDG imposent l’adoption de l’IA et y consacrent des budgets croissants. L’objectif est clair : générer des économies de coûts, perçues comme un avantage stratégique et un levier de création rapide de valeur pour les actionnaires. Mais la sécurité reste trop souvent reléguée au second plan. « Beaucoup d’entreprises ont choisi d’ignorer le problème et ont décidé de ne pas mettre en place de politique de sécurité ou de ne pas investir dans les technologies nécessaires, ce qui est une très grave erreur », avertit Darren Williams. Les entreprises avancent ainsi largement à l’aveugle. Selon lui, 99 % d’entre elles n’ont aucun moyen de savoir précisément ce qui se passe dans leurs environnements, faute d’outils capables de mesurer et de contrôler ces usages.

Face à ce constat, le dirigeant de Blackfog appelle les sociétés à auditer leurs systèmes, à mesurer l’ampleur du phénomène, à définir des politiques claires d’usage de l’IA et à adopter des cadres de gouvernance adaptés. La sensibilisation des salariés aux risques est, selon lui, cruciale. « La formation est simple et rapide à mettre en place », explique-t-il. Mais instaurer des règles et un cadre de gouvernance demande un vrai engagement : les entreprises doivent décider des risques qu’elles acceptent. « Tout comme la révolution industrielle et Internet ont transformé notre manière de travailler, l’IA est en train de faire de même », affirme Darren Williams. « Et cette transformation pourrait être encore plus profonde que les précédentes. »

Commentaire