Il vous reste 96% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Vous avez déjà un compte? Connectez-vous

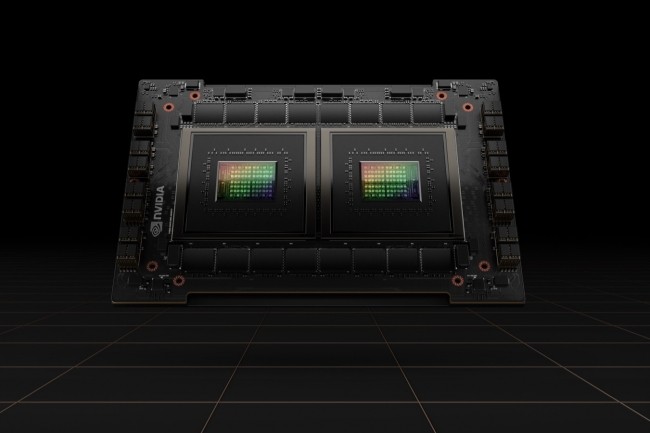

Stimulé par les besoins de l'intelligence artificielle et de l'apprentissage machine, le marché des unités de traitement graphique est en pleine croissance. Et la bataille commence à s'intensifier entre Nvidia, AMD et Intel pour en capter les plus grosses parts.

Il vous reste 96% de l'article à lire

Vous devez posséder un compte pour poursuivre la lecture

Recevez notre newsletter comme plus de 50000 abonnés

Commentaire