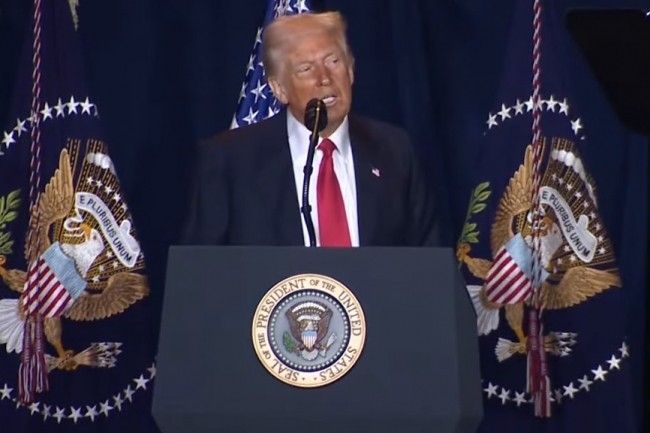

Fruit d’un consensus et de frictions, l’IA Act n’est qu’une première étape. En effet, le règlement prévoit la rédaction de codes de bonnes pratiques pour les modèles d’IA à usage général, y compris ceux qui présentent un risque systémique. Cependant, alors que la rédaction approche de sa date limite, le président américain Donald Trump ferait pression sur les régulateurs européens pour qu'ils abandonnent ce texte. L'administration américaine et d'autres critiques affirment qu'il étouffe l'innovation, qu'il est pesant et qu'il étend les limites de la loi sur l'IA, créant essentiellement de nouvelles règles inutiles. La mission du gouvernement américain auprès de l'UE a récemment contacté la Commission européenne et plusieurs gouvernements européens pour s'opposer à son adoption sous sa forme actuelle, rapporte Bloomberg.

« Les grandes entreprises IT, et maintenant les représentants du gouvernement, affirment que le projet de code impose des obligations supplémentaires, notamment des tests de modèles par des tiers et la divulgation complète des données d'entraînement, qui vont au-delà du texte juridiquement contraignant du règlement sur l'IA et qui, en outre, seraient très difficiles à mettre en œuvre à grande échelle », a expliqué Thomas Randall, directeur des études de marché sur l'IA chez Info-Tech Research Group.

Une discussion en cours de finalisation

Sur sa page web décrivant l'initiative, la Commission européenne a déclaré que « le code devrait représenter un outil central permettant aux fournisseurs de démontrer qu'ils se conforment au règlement sur l'IA, en intégrant les pratiques les plus récentes. » Le code est volontaire, mais son objectif est d'aider les fournisseurs à se préparer à satisfaire aux exigences de la réglementation en matière de transparence, de droits d'auteur et de réduction des risques. Il est rédigé par un groupe diversifié de fournisseurs de modèles d'IA à usage général, d'organisations industrielles, de détenteurs de droits d'auteur, de représentants de la société civile, de membres du monde universitaire et d'experts indépendants, sous la supervision de l'Office européen de l'IA.

La date limite d'achèvement est fixée à la fin du mois d'avril. La version finale devrait être présentée aux représentants de l'UE pour approbation en mai, et entrera en vigueur en août prochain, un an après l'entrée en vigueur du règlement sur l'IA. Elle aura un impact non négligeable. M. Randall a souligné que le non-respect de la loi pourrait entraîner des amendes allant jusqu'à 7 % du chiffre d'affaires mondial, ou un examen plus approfondi de la part des autorités de réglementation, une fois qu'elle sera entrée en vigueur.

Des obligations supplémentaires

« Toute entreprise menant des activités en Europe doit disposer de ses propres guides de risques en matière d'IA, y compris des vérifications de l'impact sur la vie privée, des registres de provenance ou des tests par une red team, afin d'éviter des dommages contractuels, réglementaires et de réputation », souligne l’analyste. Il ajoute que si Bruxelles édulcorait son code de l'IA, elle ne se contenterait pas ddonner un laissez-passer aux entreprises, « elle leur confierait le volant. »

Pour lui, des règles claires et bien définies peuvent au moins indiquer où se trouvent les garde-fous. Si l'on supprime ces règles, chaque entreprise, qu'il s'agisse d'une startup ou d'une société internationale, devra tracer sa propre voie en matière de protection de la vie privée, de droits d'auteur et de sécurité des modèles. Alors que certaines iront de l'avant, d'autres devront probablement freiner parce que la responsabilité « reposerait carrément sur leur bureau. » Thomas Randall observe que « les DSI doivent considérer les contrôles responsables de l'IA comme une infrastructure de base, et non comme un projet secondaire. »

Les Etats-Unis détricotent leur réglementation sur l’IA

Si d'autres pays devaient suivre l'approche de l'administration américaine actuelle en matière de législation sur l'IA, il en résulterait probablement un paysage réglementaire allégé, avec une surveillance réduite, a fait remarquer Bill Wong, chargé de recherche sur l'IA à l'Info-Tech Research Group. Il souligne qu'en janvier, l'administration américaine a publié le décret 14179, « supprimer les obstacles au leadership américain en matière d'intelligence artificielle. » Juste après, le National Institute of Standards and Technology (NIST) a mis à jour ses orientations pour les scientifiques travaillant avec l'US Artificial Intelligence Safety Institute (AISI).

En outre, les références à la « sécurité de l'IA », à l'« IA responsable » et à l'« équité de l'IA » ont été supprimées ; à la place, l'accent a été mis sur la « réduction des préjugés idéologiques pour permettre l'épanouissement de l'homme et la compétitivité économique. » M. Wong a déclaré : « En fait, les orientations mises à jour semblent encourager les partenaires à s'aligner sur la position de déréglementation du décret. »

Commentaire